Начало работы с семантическим ядром

В нескольких шагах вы можете создать первый агент ИИ с семантического ядра в Python, .NET или Java. В этом руководстве показано, как...

- Установка необходимых пакетов

- Создание обратной беседы с искусственным интеллектом

- Предоставление агенту искусственного интеллекта возможность запуска кода

- Посмотрите, как ИИ создает планы на лету

Установка пакета SDK

Семантический ядро имеет несколько доступных пакетов NuGet. Однако для большинства сценариев обычно требуется Microsoft.SemanticKernelтолько .

Ее можно установить с помощью следующей команды:

dotnet add package Microsoft.SemanticKernel

Полный список пакетов Nuget см . в статье о поддерживаемых языках.

Инструкции по доступу к пакету SemanticKernel Python доступны здесь. Это так же просто, как:

pip install semantic-kernel

Инструкции по доступу к пакету SemanticKernel Java доступны здесь. Это так же просто, как:

<dependencyManagement>

<dependencies>

<dependency>

<groupId>com.microsoft.semantic-kernel</groupId>

<artifactId>semantickernel-bom</artifactId>

<version>${sk.version}</version>

<type>pom</type>

<scope>import</scope>

</dependency>

</dependencies>

</dependencyManagement>

<dependencies>

<dependency>

<groupId>com.microsoft.semantic-kernel</groupId>

<artifactId>semantickernel-api</artifactId>

</dependency>

<dependency>

<groupId>com.microsoft.semantic-kernel</groupId>

<artifactId>semantickernel-aiservices-openai</artifactId>

</dependency>

</dependencies>

Быстрое начало работы с записными книжками

Если вы являетесь разработчиком Python или C#, вы можете быстро приступить к работе с нашими записными книжками. Эти записные книжки предоставляют пошаговые руководства по использованию семантического ядра для создания агентов ИИ.

Чтобы начать, выполните эти действия:

- Клонирование репозитория семантического ядра

- Открытие репозитория в Visual Studio Code

- Перейдите к _/python/samples/getting_started

- Откройте 00-get-started.ipynb , чтобы приступить к настройке среды и созданию первого агента ИИ!

Чтобы начать, выполните эти действия:

- Клонирование репозитория семантического ядра

- Открытие репозитория в Visual Studio Code

- Перейдите к _/dotnet/notebooks

- Откройте 00-get-started.ipynb , чтобы приступить к настройке среды и созданию первого агента ИИ!

Написание первого консольного приложения

// Import packages

using Microsoft.SemanticKernel;

using Microsoft.SemanticKernel.ChatCompletion;

using Microsoft.SemanticKernel.Connectors.OpenAI;

// Create a kernel with Azure OpenAI chat completion

var builder = Kernel.CreateBuilder().AddAzureOpenAIChatCompletion(modelId, endpoint, apiKey);

// Add enterprise components

builder.Services.AddLogging(services => services.AddConsole().SetMinimumLevel(LogLevel.Trace));

// Build the kernel

Kernel kernel = builder.Build();

var chatCompletionService = kernel.GetRequiredService<IChatCompletionService>();

// Add a plugin (the LightsPlugin class is defined below)

kernel.Plugins.AddFromType<LightsPlugin>("Lights");

// Enable planning

OpenAIPromptExecutionSettings openAIPromptExecutionSettings = new()

{

FunctionChoiceBehavior = FunctionChoiceBehavior.Auto()

};

// Create a history store the conversation

var history = new ChatHistory();

// Initiate a back-and-forth chat

string? userInput;

do {

// Collect user input

Console.Write("User > ");

userInput = Console.ReadLine();

// Add user input

history.AddUserMessage(userInput);

// Get the response from the AI

var result = await chatCompletionService.GetChatMessageContentAsync(

history,

executionSettings: openAIPromptExecutionSettings,

kernel: kernel);

// Print the results

Console.WriteLine("Assistant > " + result);

// Add the message from the agent to the chat history

history.AddMessage(result.Role, result.Content ?? string.Empty);

} while (userInput is not null);

import asyncio

from semantic_kernel import Kernel

from semantic_kernel.utils.logging import setup_logging

from semantic_kernel.functions import kernel_function

from semantic_kernel.connectors.ai.open_ai import AzureChatCompletion

from semantic_kernel.connectors.ai.function_choice_behavior import FunctionChoiceBehavior

from semantic_kernel.connectors.ai.chat_completion_client_base import ChatCompletionClientBase

from semantic_kernel.contents.chat_history import ChatHistory

from semantic_kernel.functions.kernel_arguments import KernelArguments

from semantic_kernel.connectors.ai.open_ai.prompt_execution_settings.azure_chat_prompt_execution_settings import (

AzureChatPromptExecutionSettings,

)

async def main():

# Initialize the kernel

kernel = Kernel()

# Add Azure OpenAI chat completion

chat_completion = AzureChatCompletion(

deployment_name="your_models_deployment_name",

api_key="your_api_key",

base_url="your_base_url",

)

kernel.add_service(chat_completion)

# Set the logging level for semantic_kernel.kernel to DEBUG.

setup_logging()

logging.getLogger("kernel").setLevel(logging.DEBUG)

# Add a plugin (the LightsPlugin class is defined below)

kernel.add_plugin(

LightsPlugin(),

plugin_name="Lights",

)

# Enable planning

execution_settings = AzureChatPromptExecutionSettings()

execution_settings.function_call_behavior = FunctionChoiceBehavior.Auto()

# Create a history of the conversation

history = ChatHistory()

# Initiate a back-and-forth chat

userInput = None

while True:

# Collect user input

userInput = input("User > ")

# Terminate the loop if the user says "exit"

if userInput == "exit":

break

# Add user input to the history

history.add_user_message(userInput)

# Get the response from the AI

result = await chat_completion.get_chat_message_content(

chat_history=history,

settings=execution_settings,

kernel=kernel,

)

# Print the results

print("Assistant > " + str(result))

# Add the message from the agent to the chat history

history.add_message(result)

# Run the main function

if __name__ == "__main__":

asyncio.run(main())

OpenAIAsyncClient client = new OpenAIClientBuilder()

.credential(new AzureKeyCredential(AZURE_CLIENT_KEY))

.endpoint(CLIENT_ENDPOINT)

.buildAsyncClient();

// Import the LightsPlugin

KernelPlugin lightPlugin = KernelPluginFactory.createFromObject(new LightsPlugin(),

"LightsPlugin");

// Create your AI service client

ChatCompletionService chatCompletionService = OpenAIChatCompletion.builder()

.withModelId(MODEL_ID)

.withOpenAIAsyncClient(client)

.build();

// Create a kernel with Azure OpenAI chat completion and plugin

Kernel kernel = Kernel.builder()

.withAIService(ChatCompletionService.class, chatCompletionService)

.withPlugin(lightPlugin)

.build();

// Add a converter to the kernel to show it how to serialise LightModel objects into a prompt

ContextVariableTypes

.addGlobalConverter(

ContextVariableTypeConverter.builder(LightModel.class)

.toPromptString(new Gson()::toJson)

.build());

// Enable planning

InvocationContext invocationContext = new InvocationContext.Builder()

.withReturnMode(InvocationReturnMode.LAST_MESSAGE_ONLY)

.withToolCallBehavior(ToolCallBehavior.allowAllKernelFunctions(true))

.build();

// Create a history to store the conversation

ChatHistory history = new ChatHistory();

// Initiate a back-and-forth chat

Scanner scanner = new Scanner(System.in);

String userInput;

do {

// Collect user input

System.out.print("User > ");

userInput = scanner.nextLine();

// Add user input

history.addUserMessage(userInput);

// Prompt AI for response to users input

List<ChatMessageContent<?>> results = chatCompletionService

.getChatMessageContentsAsync(history, kernel, invocationContext)

.block();

for (ChatMessageContent<?> result : results) {

// Print the results

if (result.getAuthorRole() == AuthorRole.ASSISTANT && result.getContent() != null) {

System.out.println("Assistant > " + result);

}

// Add the message from the agent to the chat history

history.addMessage(result);

}

} while (userInput != null && !userInput.isEmpty());

Следующий ответный чат должен быть похож на то, что вы видите в консоли. Вызовы функций добавлены ниже, чтобы продемонстрировать, как ИИ использует подключаемый модуль за кулисами.

| Роль | Сообщение |

|---|---|

| 🔵Пользователь | Переключите свет |

| 🔴Помощник (вызов функции) | LightsPlugin.GetState() |

| 🟢Инструмент | off |

| 🔴Помощник (вызов функции) | LightsPlugin.ChangeState(true) |

| 🟢Инструмент | on |

| 🔴Помощник | Свет сейчас включен |

Если вы хотите узнать больше о приведенном выше коде, мы разберем его в следующем разделе.

Основные сведения о коде

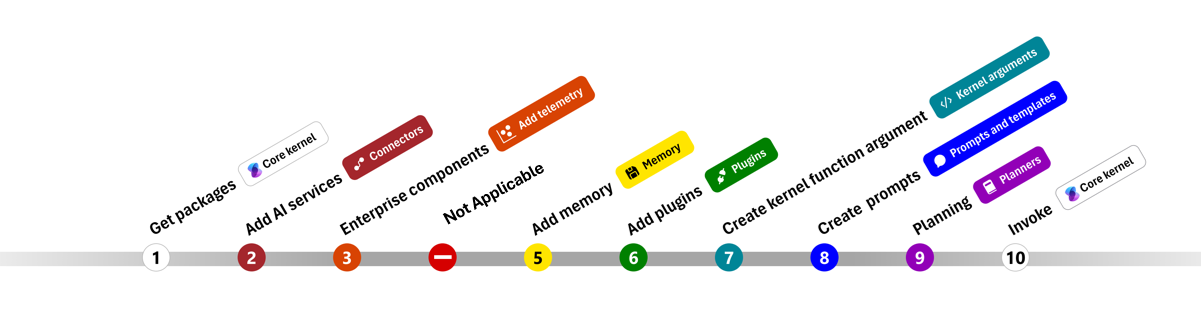

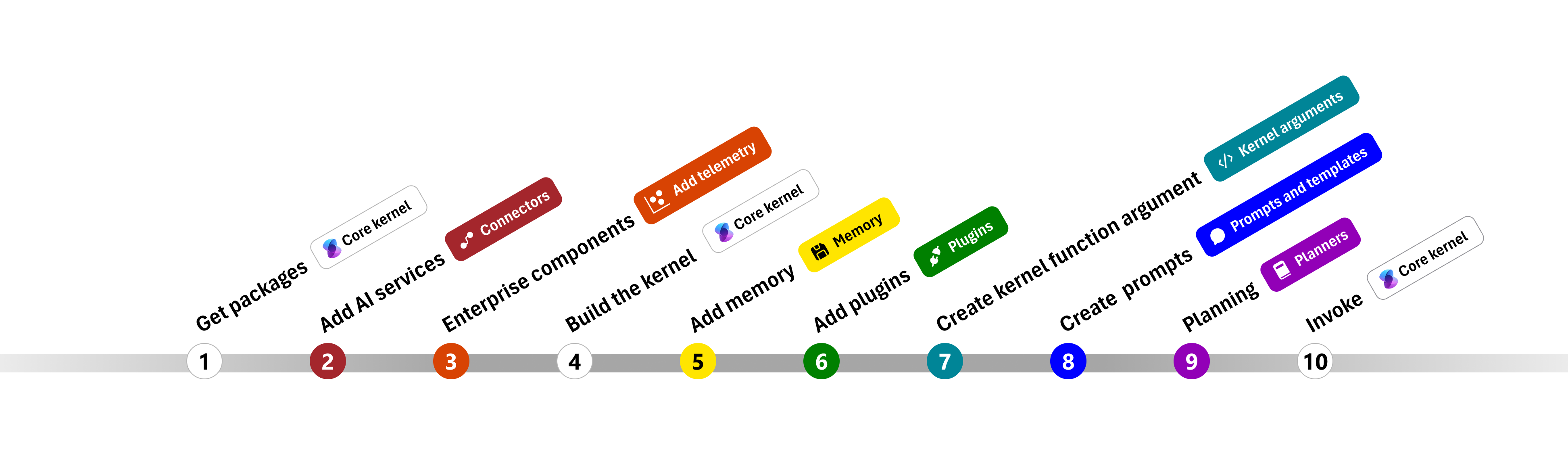

Чтобы упростить создание корпоративных приложений с помощью семантического ядра, мы создали пошаговые инструкции, которые помогут вам создать ядро и использовать его для взаимодействия со службами ИИ.

В следующих разделах мы распакуем приведенный выше пример, выполнив шаги 1, 2, 3, 4, 6, 9 и 10. Все необходимое для создания простого агента, который работает службой ИИ и может выполнять код.

- Импорт пакетов

- Добавление служб ИИ

- Корпоративные компоненты ::: зона

- Создание ядра

- Добавление памяти (пропущено)

- Добавление подключаемых модулей

- Создание аргументов ядра (пропущено)

- Создание запросов (пропущено)

- Планирование

- Взывать

1) Импорт пакетов

Для этого примера мы сначала начали импортируйте следующие пакеты:

using Microsoft.SemanticKernel;

using Microsoft.SemanticKernel.ChatCompletion;

using Microsoft.SemanticKernel.Connectors.OpenAI;

import asyncio

from semantic_kernel import Kernel

from semantic_kernel.connectors.ai.open_ai import AzureChatCompletion

from semantic_kernel.connectors.ai.function_choice_behavior import FunctionChoiceBehavior

from semantic_kernel.connectors.ai.chat_completion_client_base import ChatCompletionClientBase

from semantic_kernel.contents.chat_history import ChatHistory

from semantic_kernel.functions.kernel_arguments import KernelArguments

from semantic_kernel.connectors.ai.open_ai.prompt_execution_settings.azure_chat_prompt_execution_settings import (

AzureChatPromptExecutionSettings,

)

import com.microsoft.semantickernel.Kernel;

import com.microsoft.semantickernel.aiservices.openai.chatcompletion.OpenAIChatCompletion;

import com.microsoft.semantickernel.contextvariables.ContextVariableTypeConverter;

import com.microsoft.semantickernel.contextvariables.ContextVariableTypes;

import com.microsoft.semantickernel.orchestration.InvocationContext;

import com.microsoft.semantickernel.orchestration.InvocationReturnMode;

import com.microsoft.semantickernel.orchestration.ToolCallBehavior;

import com.microsoft.semantickernel.plugin.KernelPlugin;

import com.microsoft.semantickernel.plugin.KernelPluginFactory;

import com.microsoft.semantickernel.services.chatcompletion.AuthorRole;

import com.microsoft.semantickernel.services.chatcompletion.ChatCompletionService;

import com.microsoft.semantickernel.services.chatcompletion.ChatHistory;

import com.microsoft.semantickernel.services.chatcompletion.ChatMessageContent;

2) Добавление служб ИИ

Затем мы добавим наиболее важную часть ядра: службы ИИ, которые вы хотите использовать. В этом примере мы добавили службу завершения чата Azure OpenAI в построителе ядра.

Примечание.

В этом примере мы использовали Azure OpenAI, но вы можете использовать любую другую службу завершения чата. Чтобы просмотреть полный список поддерживаемых служб, см . статью о поддерживаемых языках. Если вам нужна помощь по созданию другой службы, обратитесь к статье служб ИИ. Здесь вы найдете рекомендации по использованию моделей OpenAI или Azure OpenAI в качестве служб.

// Create kernel

var builder = Kernel.CreateBuilder()

builder.AddAzureOpenAIChatCompletion(modelId, endpoint, apiKey);

# Initialize the kernel

kernel = Kernel()

# Add Azure OpenAI chat completion

kernel.add_service(AzureChatCompletion(

deployment_name="your_models_deployment_name",

api_key="your_api_key",

base_url="your_base_url",

))

// Create your AI service client

ChatCompletionService chatCompletionService = OpenAIChatCompletion.builder()

.withModelId(MODEL_ID)

.withOpenAIAsyncClient(client)

.build();

// Create a kernel with Azure OpenAI chat completion and plugin

Kernel kernel = Kernel.builder()

.withAIService(ChatCompletionService.class, chatCompletionService)

.withPlugin(lightPlugin)

.build();

3) Добавление корпоративных служб

Одним из основных преимуществ использования семантического ядра является поддержка служб корпоративного уровня. В этом примере мы добавили службу ведения журнала в ядро для отладки агента ИИ.

builder.Services.AddLogging(services => services.AddConsole().SetMinimumLevel(LogLevel.Trace));

import logging

# Set the logging level for semantic_kernel.kernel to DEBUG.

logging.basicConfig(

format="[%(asctime)s - %(name)s:%(lineno)d - %(levelname)s] %(message)s",

datefmt="%Y-%m-%d %H:%M:%S",

)

logging.getLogger("kernel").setLevel(logging.DEBUG)

4) Создание ядра и получение служб

После добавления служб мы создадим ядро и получите службу завершения чата для последующего использования.

Kernel kernel = builder.Build();

// Retrieve the chat completion service

var chatCompletionService = kernel.Services.GetRequiredService<IChatCompletionService>();

После настройки ядра мы получите службу завершения чата для последующего использования.

Примечание.

В Python не требуется явно создавать ядро. Вместо этого можно получить доступ к службам непосредственно из объекта ядра.

chat_completion : AzureChatCompletion = kernel.get_service(type=ChatCompletionClientBase)

// Create a kernel with Azure OpenAI chat completion and plugin

Kernel kernel = Kernel.builder()

.withAIService(ChatCompletionService.class, chatCompletionService)

.withPlugin(lightPlugin)

.build();

6) Добавление подключаемых модулей

С помощью подключаемых модулей можно предоставить агенту ИИ возможность запуска кода для получения информации из внешних источников или выполнения действий. В приведенном выше примере мы добавили подключаемый модуль, позволяющий агенту ИИ взаимодействовать с лампочкой. Ниже показано, как создать этот подключаемый модуль.

Создание собственного подключаемого модуля

Ниже показано, что создание собственного подключаемого модуля так же просто, как создание нового класса.

В этом примере мы создали подключаемый модуль, который может управлять лампочкой. Хотя это простой пример, этот подключаемый модуль быстро демонстрирует, как можно поддерживать оба...

- Получение дополненного поколения (RAG), предоставив агентУ ИИ состояние лампочки

- И автоматизация задач, позволяя агенту ИИ включить или отключить лампочку.

В собственном коде можно создать подключаемый модуль, взаимодействующий с любой внешней службой или API для достижения аналогичных результатов.

using System.ComponentModel;

using Microsoft.SemanticKernel;

public class LightsPlugin

{

// Mock data for the lights

private readonly List<LightModel> lights = new()

{

new LightModel { Id = 1, Name = "Table Lamp", IsOn = false },

new LightModel { Id = 2, Name = "Porch light", IsOn = false },

new LightModel { Id = 3, Name = "Chandelier", IsOn = true }

};

[KernelFunction("get_lights")]

[Description("Gets a list of lights and their current state")]

[return: Description("An array of lights")]

public async Task<List<LightModel>> GetLightsAsync()

{

return lights;

}

[KernelFunction("change_state")]

[Description("Changes the state of the light")]

[return: Description("The updated state of the light; will return null if the light does not exist")]

public async Task<LightModel?> ChangeStateAsync(int id, bool isOn)

{

var light = lights.FirstOrDefault(light => light.Id == id);

if (light == null)

{

return null;

}

// Update the light with the new state

light.IsOn = isOn;

return light;

}

}

public class LightModel

{

[JsonPropertyName("id")]

public int Id { get; set; }

[JsonPropertyName("name")]

public string Name { get; set; }

[JsonPropertyName("is_on")]

public bool? IsOn { get; set; }

}

from typing import Annotated

from semantic_kernel.functions import kernel_function

class LightsPlugin:

lights = [

{"id": 1, "name": "Table Lamp", "is_on": False},

{"id": 2, "name": "Porch light", "is_on": False},

{"id": 3, "name": "Chandelier", "is_on": True},

]

@kernel_function(

name="get_lights",

description="Gets a list of lights and their current state",

)

def get_state(

self,

) -> Annotated[str, "the output is a string"]:

"""Gets a list of lights and their current state."""

return self.lights

@kernel_function(

name="change_state",

description="Changes the state of the light",

)

def change_state(

self,

id: int,

is_on: bool,

) -> Annotated[str, "the output is a string"]:

"""Changes the state of the light."""

for light in self.lights:

if light["id"] == id:

light["is_on"] = is_on

return light

return None

public class LightsPlugin {

// Mock data for the lights

private final Map<Integer, LightModel> lights = new HashMap<>();

public LightsPlugin() {

lights.put(1, new LightModel(1, "Table Lamp", false));

lights.put(2, new LightModel(2, "Porch light", false));

lights.put(3, new LightModel(3, "Chandelier", true));

}

@DefineKernelFunction(name = "get_lights", description = "Gets a list of lights and their current state")

public List<LightModel> getLights() {

System.out.println("Getting lights");

return new ArrayList<>(lights.values());

}

@DefineKernelFunction(name = "change_state", description = "Changes the state of the light")

public LightModel changeState(

@KernelFunctionParameter(name = "id", description = "The ID of the light to change") int id,

@KernelFunctionParameter(name = "isOn", description = "The new state of the light") boolean isOn) {

System.out.println("Changing light " + id + " " + isOn);

if (!lights.containsKey(id)) {

throw new IllegalArgumentException("Light not found");

}

lights.get(id).setIsOn(isOn);

return lights.get(id);

}

}

Добавление подключаемого модуля в ядро

После создания подключаемого модуля его можно добавить в ядро, чтобы агент ИИ смог получить к нему доступ. В примере мы добавили LightsPlugin класс в ядро.

// Add the plugin to the kernel

kernel.Plugins.AddFromType<LightsPlugin>("Lights");

# Add the plugin to the kernel

kernel.add_plugin(

LightsPlugin(),

plugin_name="Lights",

)

// Import the LightsPlugin

KernelPlugin lightPlugin = KernelPluginFactory.createFromObject(new LightsPlugin(),

"LightsPlugin");

9) Планирование

Семантические ядра используют вызовы функций — собственную функцию большинства LLM— для обеспечения планирования. При вызове функции LLMs может запрашивать (или вызывать) определенную функцию для удовлетворения запроса пользователя. Затем семантический ядро маршалирует запрос на соответствующую функцию в базе кода и возвращает результаты обратно в LLM, чтобы агент ИИ смог создать окончательный ответ.

Чтобы включить автоматический вызов функции, сначала необходимо создать соответствующие параметры выполнения, чтобы семантический ядро знал автоматически вызывать функции в ядре, когда агент ИИ запрашивает их.

OpenAIPromptExecutionSettings openAIPromptExecutionSettings = new()

{

FunctionChoiceBehavior = FunctionChoiceBehavior.Auto()

};

execution_settings = AzureChatPromptExecutionSettings()

execution_settings.function_call_behavior = FunctionChoiceBehavior.Auto()

// Enable planning

InvocationContext invocationContext = new InvocationContext.Builder()

.withReturnMode(InvocationReturnMode.LAST_MESSAGE_ONLY)

.withToolCallBehavior(ToolCallBehavior.allowAllKernelFunctions(true))

.build();

10) Вызов

Наконец, мы вызываем агент ИИ с подключаемым модулем. В примере кода показано, как создать ответ, отличный от потоковой передачи, но можно также создать ответ потоковой передачи с помощью GetStreamingChatMessageContentAsync метода.

// Create chat history

var history = new ChatHistory();

// Get the response from the AI

var result = await chatCompletionService.GetChatMessageContentAsync(

history,

executionSettings: openAIPromptExecutionSettings,

kernel: kernel

);

# Create a history of the conversation

history = ChatHistory()

# Get the response from the AI

result = (await chat_completion.get_chat_message_contents(

chat_history=history,

settings=execution_settings,

kernel=kernel,

arguments=KernelArguments(),

))[0]

userInput = scanner.nextLine();

// Add user input

history.addUserMessage(userInput);

// Prompt AI for response to users input

List<ChatMessageContent<?>> results = chatCompletionService

.getChatMessageContentsAsync(history, kernel, invocationContext)

.block();

Следующие шаги

В этом руководстве вы узнали, как быстро приступить к работе с семантическим ядром, создав простой агент ИИ, который может взаимодействовать со службой ИИ и запускать код. Чтобы просмотреть дополнительные примеры и узнать, как создавать более сложные агенты ИИ, ознакомьтесь с нашими подробными примерами.