Snabbstart: Azure AI Content Safety Studio

Den här artikeln beskriver hur du kan komma igång med Azure AI Content Safety-tjänsten med hjälp av Content Safety Studio i webbläsaren.

Varning

En del av exempelinnehållet som tillhandahålls av Content Safety Studio kan vara stötande. Exempelbilderna är suddiga som standard. Användarens diskretion rekommenderas.

Förutsättningar

- Ett Azure-konto. Om du inte har någon sådan nu kan du skapa en kostnadsfritt.

- En Content Safety Azure-resurs.

- Tilldela Cognitive Services-användarrollen till ditt konto. Gå till Azure Portal, gå till innehållssäkerhetsresursen eller Azure AI Services-resursen och välj Åtkomstkontroll i det vänstra navigeringsfältet, välj + Lägg till rolltilldelning, välj rollen Cognitive Services-användare och välj den medlem i ditt konto som du behöver tilldela rollen till, granska och tilldela. Det kan ta några minuter innan tilldelningen börjar gälla.

- Logga in på Content Safety Studio med din Azure-prenumeration och innehållssäkerhetsresurs.

Viktigt!

Du måste tilldela Cognitive Services-användarrollen till ditt Azure-konto för att kunna använda studioupplevelsen. Gå till Azure Portal, gå till innehållssäkerhetsresursen eller Azure AI Services-resursen och välj Åtkomstkontroll i det vänstra navigeringsfältet, välj + Lägg till rolltilldelning, välj rollen Cognitive Services-användare och välj den medlem i ditt konto som du behöver tilldela rollen till, granska och tilldela. Det kan ta några minuter innan tilldelningen börjar gälla.

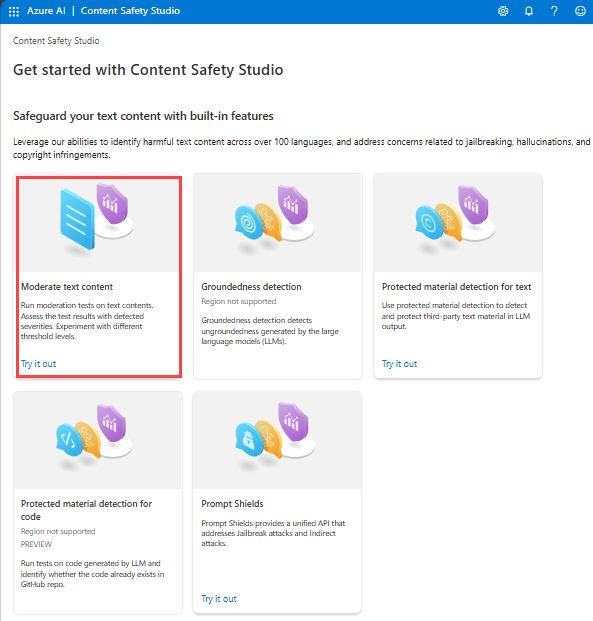

Analysera textinnehåll

Sidan Måttligt textinnehåll ger dig möjlighet att snabbt prova textmoderering.

- Välj panelen Måttligt textinnehåll.

- Lägg till text i indatafältet eller välj exempeltext från panelerna på sidan.

- Välj Kör test.

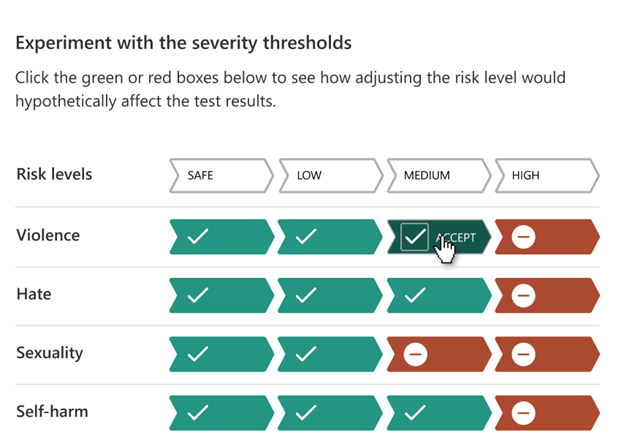

Tjänsten returnerar alla kategorier som har identifierats, med allvarlighetsgraden för var och en: 0-Säker, 2-Låg, 4-Medel, 6-Hög. Den returnerar också ett binärt godkänt/avvisat resultat baserat på de filter som du konfigurerar. Använd matrisen på fliken Konfigurera filter för att ange tillåtna/förbjudna allvarlighetsnivåer för varje kategori. Sedan kan du köra texten igen för att se hur filtret fungerar.

På fliken Använd blockliste kan du skapa, redigera och lägga till en blockeringslista i arbetsflödet för moderering. Om du har en blockeringslista aktiverad när du kör testet får du en panel för blocklisteidentifiering under Resultat. Den rapporterar eventuella matchningar med blocklistan.

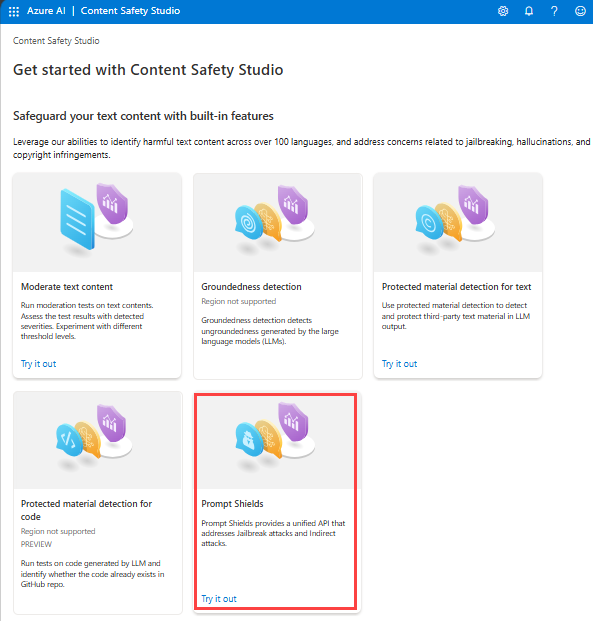

Identifiera användarindataattacker

På panelen Prompt Shields kan du testa riskidentifiering av användarindata. Identifiera användarfrågor som utformats för att provocera Generative AI-modellen till att uppvisa beteenden som den har tränats för att undvika eller bryta mot reglerna som anges i systemmeddelandet. Dessa attacker kan variera från invecklat rollspel till subtil omstörtning av säkerhetsmålet.

- Välj panelen Fråga sköldar .

- Välj en exempeltext på sidan eller ange ditt eget innehåll för testning. Du kan också ladda upp en CSV-fil för att göra ett batchtest.

- Välj Kör test.

Tjänsten returnerar riskflaggan och typen för varje exempel.

Mer information finns i konceptguiden för Prompt Shields.

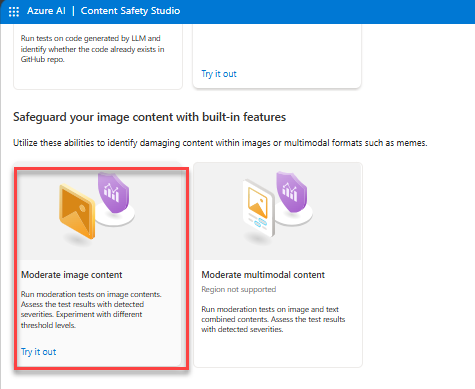

Analysera avbildningsinnehåll

Sidan Måttligt bildinnehåll ger dig möjlighet att snabbt prova bildmoderering.

- Välj panelen Moderera bildinnehåll .

- Välj en exempelbild från panelerna på sidan eller ladda upp en egen bild. Den maximala storleken för bildöverföringar är 4 MB och bilddimensionerna måste vara mellan 50 x 50 bildpunkter och 2 048 x 2 048 bildpunkter. Bilder kan vara i JPEG-, PNG-, GIF-, BMP-, TIFF- eller WEBP-format.

- Välj Kör test.

Tjänsten returnerar alla kategorier som har identifierats, med allvarlighetsgraden för var och en: 0-Säker, 2-Låg, 4-Medel, 6-Hög. Den returnerar också ett binärt godkänt/avvisat resultat baserat på de filter som du konfigurerar. Använd matrisen på fliken Konfigurera filter till höger för att ange dina tillåtna/förbjudna allvarlighetsnivåer för varje kategori. Sedan kan du köra texten igen för att se hur filtret fungerar.

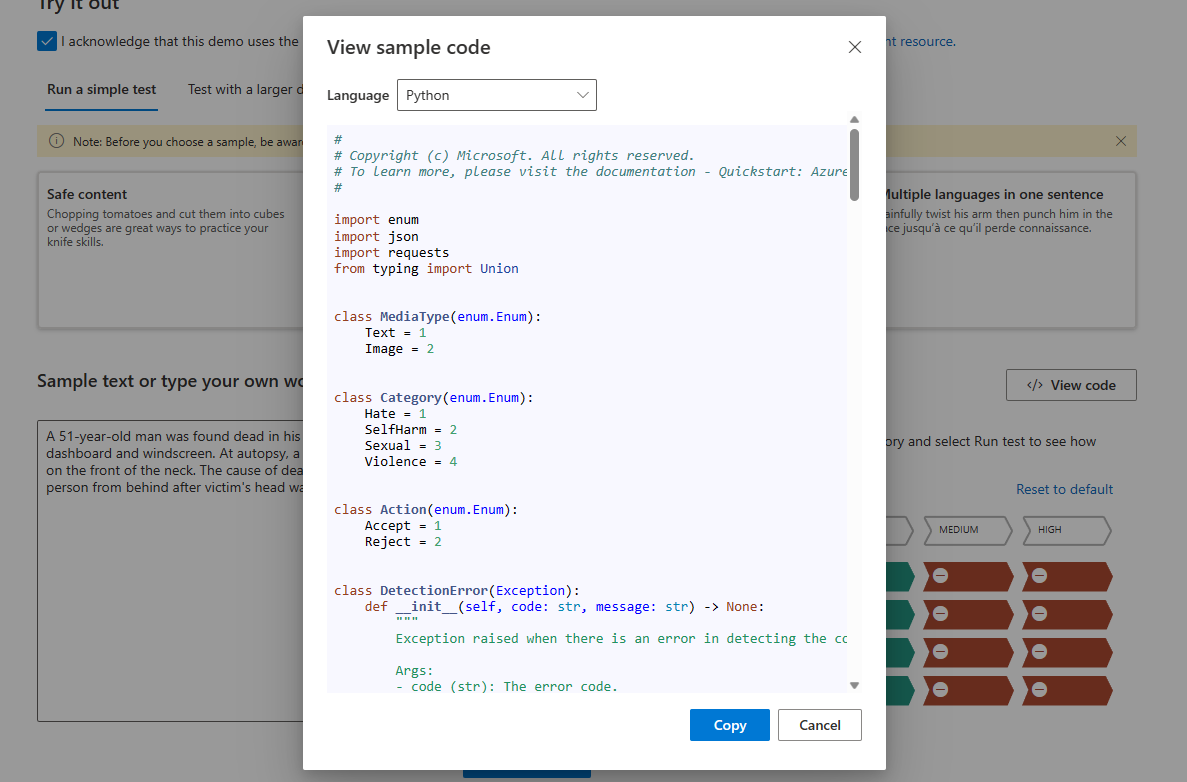

Visa och exportera kod

Du kan använda funktionen Visa kod på sidorna Analysera textinnehåll eller Analysera bildinnehåll för att visa och kopiera exempelkoden, som innehåller konfiguration för allvarlighetsgradsfiltrering, blocklistor och modereringsfunktioner. Du kan sedan distribuera koden på din sida.

Övervaka onlineaktivitet

I panelen Övervaka onlineaktivitet kan du visa din API-användning och dina trender.

Du kan välja vilken medietyp som ska övervakas. Du kan också ange det tidsintervall som du vill kontrollera genom att välja Visa data för den sista __.

I diagrammet Avvisa hastighet per kategori kan du också justera tröskelvärdena för allvarlighetsgrad för varje kategori.

Du kan också redigera blocklistor om du vill ändra vissa termer, baserat på diagrammet De 10 mest blockerade termerna .

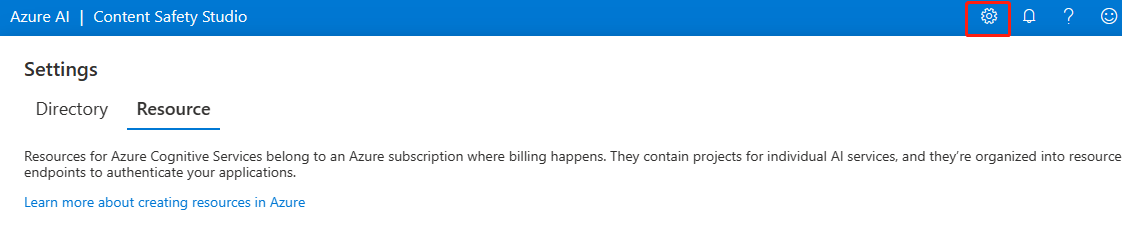

Hantera din resurs

Om du vill visa resursinformation som namn och prisnivå väljer du ikonen Inställningar i det övre högra hörnet på startsidan för Content Safety Studio och väljer fliken Resurs . Om du har andra resurser kan du växla resurser även här.

Rensa resurser

Om du vill rensa och ta bort en Azure AI-tjänstresurs kan du ta bort resursen eller resursgruppen. Om du tar bort resursgruppen tas även alla andra resurser som är associerade med den bort.

Gå vidare

Kom sedan igång med Azure AI Content Safety via REST API:er eller ett klient-SDK, så att du smidigt kan integrera tjänsten i ditt program.