Onlineslutpunktsdistribution för inferens i realtid

GÄLLER FÖR: Azure CLI ml extension v2 (current)

Azure CLI ml extension v2 (current) Python SDK azure-ai-ml v2 (aktuell)

Python SDK azure-ai-ml v2 (aktuell)

Den här artikeln beskriver onlineslutpunkter för realtidsinferens i Azure Machine Learning. Slutsatsdragning är processen att tillämpa nya indata på en maskininlärningsmodell för att generera utdata. Med Azure Machine Learning kan du utföra realtidsinferenser på data med hjälp av modeller som distribueras till onlineslutpunkter. Även om dessa utdata vanligtvis kallas förutsägelser kan du använda slutsatsdragning för att generera utdata för andra maskininlärningsuppgifter, till exempel klassificering och klustring.

Onlineslutpunkter

Onlineslutpunkter distribuerar modeller till en webbserver som kan returnera förutsägelser under HTTP-protokollet. Onlineslutpunkter kan operationalisera modeller för realtidsinferens i synkrona begäranden med låg svarstid och används bäst när:

- Du har krav på låg latens.

- Din modell kan besvara begäran på relativt kort tid.

- Modellens indata får plats på HTTP-nyttolasten för begäran.

- Du måste skala upp antalet begäranden.

Om du vill definiera en slutpunkt måste du ange:

- Slutpunktsnamn. Det här namnet måste vara unikt i Azure-regionen. Andra namngivningskrav finns i Azure Machine Learning Online-slutpunkter och batchslutpunkter.

- Autentiseringsläge. Du kan välja mellan nyckelbaserat autentiseringsläge, tokenbaserat autentiseringsläge i Azure Machine Learning eller Microsoft Entra-tokenbaserad autentisering för slutpunkten. Mer information om autentisering finns i Autentisera klienter för onlineslutpunkter.

Hanterade onlineslutpunkter

Hanterade onlineslutpunkter distribuerar dina maskininlärningsmodeller på ett bekvämt och nyckelfärdigt sätt och är det rekommenderade sättet att använda Azure Machine Learning-slutpunkter online. Hanterade onlineslutpunkter körs skalbart och helt hanterat på datorer med kraftfulla processorer och grafikkort i Azure.

För att frigöra dig från kostnaderna för att konfigurera och hantera den underliggande infrastrukturen tar de här slutpunkterna även hand om servering, skalning, skydd och övervakning av dina modeller. Information om hur du definierar hanterade onlineslutpunkter finns i Definiera slutpunkten.

Hanterade onlineslutpunkter jämfört med Azure Container Instances eller Azure Kubernetes Service (AKS) v1

Hanterade onlineslutpunkter är det rekommenderade sättet att använda onlineslutpunkter i Azure Machine Learning. I följande tabell visas nyckelattribut för hanterade onlineslutpunkter jämfört med Azure Container Instances och Azure Kubernetes Service (AKS) v1-lösningar.

| Attribut | Hanterade onlineslutpunkter (v2) | Containerinstanser eller AKS (v1) |

|---|---|---|

| Nätverkssäkerhet/isolering | Enkel inkommande/utgående kontroll med snabb växling | Virtuellt nätverk stöds inte eller kräver komplex manuell konfiguration |

| Hanterad tjänst | • Fullständigt hanterad beräkningsetablering/skalning • Nätverkskonfiguration för dataexfiltreringsskydd • Uppgradering av värdoperativsystem, kontrollerad distribution av uppdateringar på plats |

• Skalning är begränsad • Användaren måste hantera nätverkskonfiguration eller uppgradering |

| Slutpunkt/distributionskoncept | Skillnaden mellan slutpunkt och distribution möjliggör komplexa scenarier som säker distribution av modeller | Inget begrepp för slutpunkt |

| Diagnostik och övervakning | • Lokal slutpunktsfelsökning är möjlig med Docker och Visual Studio Code • Avancerade mått och logganalyser med diagram/fråga för att jämföra mellan distributioner • Kostnadsuppdelning till distributionsnivå |

Ingen enkel lokal felsökning |

| Skalbarhet | Elastisk och automatisk skalning (inte bunden av standardklusterstorleken) | • Containerinstanser är inte skalbara • AKS v1 stöder endast skalning i kluster och kräver skalbarhetskonfiguration |

| Företagsberedskap | Privat länk, kundhanterade nycklar, Microsoft Entra-ID, kvothantering, faktureringsintegrering, serviceavtal (SLA) | Stöds inte |

| Avancerade ML-funktioner | • Modelldatainsamling • Modellövervakning • Champion-challengermodell, säker distribution, trafikspegling • Ansvarsfull AI-utökningsbarhet |

Stöds inte |

Hanterade onlineslutpunkter jämfört med Kubernetes onlineslutpunkter

Om du föredrar att använda Kubernetes för att distribuera dina modeller och hantera slutpunkter, och du är bekväm med att hantera infrastrukturkrav, kan du använda Kubernetes onlineslutpunkter. Med de här slutpunkterna kan du distribuera modeller och hantera onlineslutpunkter med processorer eller GPU:er i ditt fullständigt konfigurerade och hanterade Kubernetes-kluster var som helst.

Hanterade onlineslutpunkter kan hjälpa dig att effektivisera distributionsprocessen och ge följande fördelar jämfört med Kubernetes onlineslutpunkter:

Automatisk infrastrukturhantering

- Etablerar beräkningen och är värd för modellen. Du anger bara typen av virtuell dator (VM) och skalningsinställningarna.

- Uppdaterar och korrigerar den underliggande värdoperativsystemavbildningen.

- Utför nodåterställning om det uppstår ett systemfel.

Övervakning och loggar

- Möjlighet att övervaka modelltillgänglighet, prestanda och serviceavtal med inbyggd integrering med Azure Monitor.

- Enkel felsökning av distributioner med hjälp av loggar och intern integrering med Log Analytics.

Med kostnadsanalysvyn kan du övervaka kostnader på slutpunkts- och distributionsnivå.

Kommentar

Hanterade onlineslutpunkter baseras på Azure Machine Learning-beräkning. När du använder en hanterad onlineslutpunkt betalar du för beräknings- och nätverksavgifterna. Det finns ingen extra tilläggsavgift. Mer information om priser finns i priskalkylatorn för Azure.

Om du använder ett virtuellt Azure Machine Learning-nätverk för att skydda utgående trafik från den hanterade onlineslutpunkten debiteras du för utgående regler för azure-privat länk och fullständigt kvalificerade domännamn (FQDN) som används av det hanterade virtuella nätverket. Mer information finns i Priser för hanterade virtuella nätverk.

I följande tabell visas de viktigaste skillnaderna mellan hanterade onlineslutpunkter och Kubernetes onlineslutpunkter.

| Hanterade onlineslutpunkter | Kubernetes onlineslutpunkter (AKS v2) | |

|---|---|---|

| Rekommenderade användare | Användare som vill ha en hanterad modelldistribution och förbättrad MLOps-upplevelse | Användare som föredrar Kubernetes och själva kan hantera infrastrukturkrav |

| Nodetablering | Hanterad beräkningsetablering, uppdatering, borttagning | Användaransvar |

| Nodunderhåll | Avbildningsuppdateringar för hanterade värdoperativsystem och säkerhetshärdning | Användaransvar |

| Klusterstorlek (skalning) | Hanterad manuell och autoskalning med stöd för ytterligare nodetablering | Manuell och autoskalning med stöd för skalning av antalet repliker inom fasta klustergränser |

| Beräkningstyp | Hanteras av tjänsten | Kundhanterat Kubernetes-kluster |

| Hanterade identiteter | Stöds | Stöds |

| Virtuellt nätverk | Stöds via hanterad nätverksisolering | Användaransvar |

| Out-of-box-övervakning och loggning | Azure Monitor och Log Analytics drivs, inklusive nyckelmått och loggtabeller för slutpunkter och distributioner | Användaransvar |

| Loggning med Application Insights (äldre) | Stöds | Stöds |

| Kostnadsvy | Detaljerad till slutpunkt/distributionsnivå | Klusternivå |

| Kostnader som tillämpas på | Virtuella datorer som tilldelats distributionen | Virtuella datorer som tilldelats klustret |

| Speglad trafik | Stöds | Stöd saknas |

| Distribution utan kod | Stöder MLflow- och Triton-modeller | Stöder MLflow- och Triton-modeller |

Onlinedistributioner

En distribution är en uppsättning resurser och beräkningar som krävs för att vara värd för modellen som utför inferensen. En enskild slutpunkt kan innehålla flera distributioner med olika konfigurationer. Den här konfigurationen hjälper till att frikoppla gränssnittet som visas av slutpunkten från implementeringsinformationen som finns i distributionen. En onlineslutpunkt har en routningsmekanism som kan dirigera begäranden till specifika distributioner i slutpunkten.

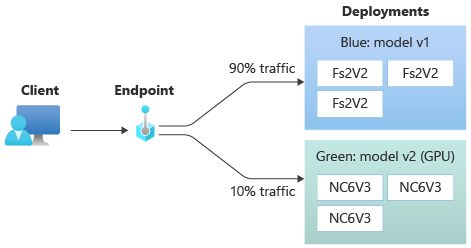

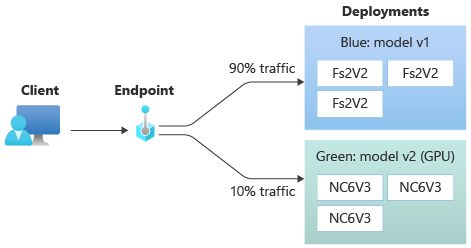

Följande diagram visar en onlineslutpunkt som har två distributioner, blå och gröna. Den blå distributionen använder virtuella datorer med en CPU-SKU och kör version 1 av en modell. Den gröna distributionen använder virtuella datorer med en GPU SKU och kör version 2 av modellen. Slutpunkten är konfigurerad för att dirigera 90 % av inkommande trafik till den blå distributionen, medan den gröna distributionen tar emot de återstående 10 %.

Om du vill distribuera en modell måste du ha:

Modellfiler, eller namnet och versionen av en modell som redan har registrerats på din arbetsyta.

Bedömning av skriptkod som kör modellen på en viss indatabegäran.

Bedömningsskriptet tar emot data som skickats till en distribuerad webbtjänst och skickar dem till modellen. Skriptet kör sedan modellen och returnerar svaret till klienten. Bedömningsskriptet är specifikt för din modell och måste förstå de data som modellen förväntar sig som indata och returnerar som utdata.

En miljö för att köra din modell. Miljön kan vara en Docker-avbildning med Conda-beroenden eller en Dockerfile.

Inställningar för att ange instanstyp och skalningskapacitet.

Information om hur du distribuerar onlineslutpunkter med hjälp av Azure CLI, Python SDK, Azure Machine Learning-studio eller en ARM-mall finns i Distribuera en maskininlärningsmodell med hjälp av en onlineslutpunkt.

Viktiga attribut för en distribution

I följande tabell beskrivs nyckelattributen för en distribution:

| Attribut | Beskrivning |

|---|---|

| Name | Namnet på distributionen. |

| Slutpunktnamn | Namnet på slutpunkten som distributionen ska skapas under. |

| Modell | Den modell som ska användas för distributionen. Det här värdet kan antingen vara en referens till en befintlig version av modellen på arbetsytan eller en infogad modellspecifikation. Mer information om hur du spårar och anger sökvägen till din modell finns i Ange modell som ska distribueras för användning i onlineslutpunkten. |

| Kodsökväg | Sökvägen till katalogen i den lokala utvecklingsmiljön som innehåller all Python-källkod för bedömning av modellen. Du kan använda kapslade kataloger och paket. |

| Bedömningsskript | Den relativa sökvägen till bedömningsfilen i källkodskatalogen. Den här Python-koden måste ha en init() funktion och en run() funktion. Funktionen init() anropas när modellen har skapats eller uppdaterats, till exempel för att cachelagra modellen i minnet. Funktionen run() anropas vid varje anrop av slutpunkten för att utföra den faktiska poängsättningen och förutsägelsen. |

| Environment | Miljön som ska vara värd för modellen och koden. Det här värdet kan antingen vara en referens till en befintlig version av miljön på arbetsytan eller en infogad miljöspecifikation. |

| Instanstyp | Den VM-storlek som ska användas för distributionen. Listan över storlekar som stöds finns i SKU-listan för hanterade onlineslutpunkter. |

| Antal instanser | Antalet instanser som ska användas för distributionen. Basera värdet på den arbetsbelastning du förväntar dig. För hög tillgänglighet anger du värdet till minst 3. Systemet reserverar ytterligare 20 % för att utföra uppgraderingar. Mer information finns i VM-kvotallokering för distributioner. |

Anteckningar för onlinedistributioner

Distributionen kan referera till modellen och containeravbildningen som definierats i Miljö när som helst, till exempel när distributionsinstanserna genomgår säkerhetskorrigeringar eller andra återställningsåtgärder. Om du använder en registrerad modell eller containeravbildning i Azure Container Registry för distribution och senare tar bort modellen eller containeravbildningen kan de distributioner som förlitar sig på dessa tillgångar misslyckas när återskapningen sker. Om du tar bort modellen eller containeravbildningen måste du återskapa eller uppdatera de beroende distributionerna med en alternativ modell eller containeravbildning.

Containerregistret som miljön refererar till kan bara vara privat om slutpunktsidentiteten har behörighet att komma åt den via Microsoft Entra-autentisering och rollbaserad åtkomstkontroll i Azure (RBAC). Av samma anledning stöds inte privata Docker-register förutom Container Registry.

Microsoft korrigerar regelbundet basavbildningarna för kända säkerhetsrisker. Du måste distribuera om slutpunkten för att använda den korrigerade avbildningen. Om du anger en egen avbildning ansvarar du för att uppdatera den. Mer information finns i Bildkorrigering.

Vm-kvotallokering för distribution

För hanterade onlineslutpunkter reserverar Azure Machine Learning 20 % av dina beräkningsresurser för att utföra uppgraderingar på vissa VM-SKU:er. Om du begär ett visst antal instanser för de virtuella dator-SKU:erna i en distribution måste du ha en kvot för tillgänglig för ceil(1.2 * number of instances requested for deployment) * number of cores for the VM SKU att undvika ett fel. Om du till exempel begär 10 instanser av en Standard_DS3_v2 virtuell dator (som levereras med fyra kärnor) i en distribution bör du ha en kvot för 48 kärnor (12 instances * 4 cores) tillgänglig. Den här extra kvoten är reserverad för systeminitierade åtgärder, till exempel OS-uppgraderingar och återställning av virtuella datorer, och den medför inte kostnader om inte sådana åtgärder körs.

Det finns vissa VM-SKU:er som är undantagna från extra kvotreservation. Om du vill visa den fullständiga listan kan du läsa SKU-listan hanterade onlineslutpunkter. Information om hur du visar ökningar av användnings- och begärandekvoter finns i Visa din användning och dina kvoter i Azure Portal. Information om hur du visar kostnaden för att köra en hanterad onlineslutpunkt finns i Visa kostnader för en hanterad onlineslutpunkt.

Delad kvotpool

Azure Machine Learning tillhandahåller en delad kvotpool från vilken användare i olika regioner kan komma åt kvoten för att utföra testning under en begränsad tid, beroende på tillgänglighet. När du använder studion för att distribuera Llama-2-, Phi-, Nemotron-, Mistral-, Dolly- och Deci-DeciLM-modeller från modellkatalogen till en hanterad onlineslutpunkt, ger Azure Machine Learning dig åtkomst till dess delade kvotpool under en kort tid så att du kan utföra testning. Mer information om den delade kvotpoolen finns i Delad kvot för Azure Machine Learning.

Om du vill distribuera Llama-2-, Phi-, Nemotron-, Mistral-, Dolly- och Deci-DeciLM-modeller från modellkatalogen med hjälp av den delade kvoten måste du ha en företagsavtal prenumeration. Mer information om hur du använder den delade kvoten för distribution av onlineslutpunkter finns i Distribuera grundmodeller med hjälp av studion.

Mer information om kvoter och gränser för resurser i Azure Machine Learning finns i Hantera och öka kvoter och gränser för resurser med Azure Machine Learning.

Distribution för kodare och icke-kodare

Azure Machine Learning stöder modelldistribution till onlineslutpunkter för kodare och icke-kodare genom att tillhandahålla alternativ för distribution utan kod, distribution med låg kod och BYOC-distribution (Bring Your Own Container).

- Distribution utan kod ger färdiga slutsatser för vanliga ramverk som scikit-learn, TensorFlow, PyTorch och Open Neural Network Exchange (ONNX) via MLflow och Triton.

- Med distribution med låg kod kan du tillhandahålla minimal kod tillsammans med din maskininlärningsmodell för distribution.

- Med BYOC-distributionen kan du ta med praktiskt taget alla containrar för att köra din onlineslutpunkt. Du kan använda alla Azure Machine Learning-plattformsfunktioner som autoskalning, GitOps, felsökning och säker distribution för att hantera dina MLOps-pipelines.

Följande tabell belyser viktiga aspekter av distributionsalternativen online:

| Ingen kod | Låg kod | BYOC | |

|---|---|---|---|

| Sammanfattning | Använder färdiga inferenser för populära ramverk som scikit-learn, TensorFlow, PyTorch och ONNX via MLflow och Triton. Mer information finns i Distribuera MLflow-modeller till onlineslutpunkter. | Använder säkra, offentligt publicerade granskade bilder för populära ramverk, med uppdateringar varannan vecka för att åtgärda säkerhetsrisker. Du tillhandahåller bedömningsskript och/eller Python-beroenden. Mer information finns i Azure Machine Learning-kurerade miljöer. | Du tillhandahåller din fullständiga stack via Azure Machine Learning-stöd för anpassade avbildningar. Mer information finns i Använda en anpassad container för att distribuera en modell till en onlineslutpunkt. |

| Anpassad basavbildning | Inga. Utvalda miljöer ger basavbildningen för enkel distribution. | Du kan använda antingen en kurerad bild eller en anpassad avbildning. | Ta antingen med en tillgänglig containeravbildningsplats som docker.io, Container Registry eller Microsofts artefaktregister eller en Dockerfile som du kan skapa/push-överföra med Container Registry för din container. |

| Anpassade beroenden | Inga. Utvalda miljöer ger beroenden för enkel distribution. | Ta med Azure Machine Learning-miljön där modellen körs, antingen en Docker-avbildning med Conda-beroenden eller en dockerfile. | Anpassade beroenden ingår i containeravbildningen. |

| Anpassad kod | Inga. Bedömningsskriptet genereras automatiskt för enkel distribution. | Ta med ditt bedömningsskript. | Bedömningsskriptet ingår i containeravbildningen. |

Kommentar

AutoML-körningar skapar ett bedömningsskript och beroenden automatiskt för användare. För distribution utan kod kan du distribuera valfri AutoML-modell utan att redigera annan kod. För distribution med låg kod kan du ändra automatiskt genererade skript efter dina affärsbehov. Information om hur du distribuerar med AutoML-modeller finns i Distribuera en AutoML-modell till en onlineslutpunkt.

Felsökning av slutpunkt online

Testa om möjligt slutpunkten lokalt för att verifiera och felsöka koden och konfigurationen innan du distribuerar till Azure. Azure CLI och Python SDK stöder lokala slutpunkter och distributioner, medan Azure Machine Learning-studio- och ARM-mallar inte stöder lokala slutpunkter eller distributioner.

Azure Machine Learning tillhandahåller följande sätt att felsöka onlineslutpunkter lokalt och med hjälp av containerloggar:

- Lokal felsökning med HTTP-server för Azure Machine Learning-slutsatsdragning

- Lokal felsökning med lokal slutpunkt

- Lokal felsökning med lokal slutpunkt och Visual Studio Code

- Felsökning med containerloggar

Lokal felsökning med HTTP-server för Azure Machine Learning-slutsatsdragning

Du kan felsöka ditt bedömningsskript lokalt med hjälp av HTTP-servern för Azure Machine Learning-slutsatsdragning. HTTP-servern är ett Python-paket som exponerar din bedömningsfunktion som en HTTP-slutpunkt och omsluter Flask-serverkoden och beroendena till ett enda paket.

Azure Machine Learning innehåller en HTTP-server i de fördefinierade Docker-avbildningarna för slutsatsdragning som används för att distribuera en modell. Genom att bara använda paketet kan du distribuera modellen lokalt för produktion, och du kan också enkelt verifiera ditt postbedömningsskript i en lokal utvecklingsmiljö. Om det uppstår ett problem med bedömningsskriptet returnerar servern ett fel och platsen där felet inträffade. Du kan också använda Visual Studio Code för att felsöka med HTTP-servern för Azure Machine Learning-slutsatsdragning.

Dricks

Du kan använda Azure Machine Learning-inferensen HTTP Server Python-paketet för att felsöka ditt bedömningsskript lokalt utan Docker Engine. Felsökning med slutsatsdragningsservern hjälper dig att felsöka bedömningsskriptet innan du distribuerar till lokala slutpunkter, så att du kan felsöka utan att påverkas av konfigurationerna av distributionscontainer.

Mer information om felsökning med HTTP-servern finns i Felsöka bedömningsskript med HTTP-server för Azure Machine Learning-slutsatsdragning.

Lokal felsökning med lokal slutpunkt

För lokal felsökning behöver du en modell som distribueras till en lokal Docker-miljö. Du kan använda den här lokala distributionen för testning och felsökning innan du distribuerar till molnet.

För att distribuera lokalt behöver du Docker-motorn installerad och igång. Azure Machine Learning skapar sedan en lokal Docker-avbildning för att efterlikna onlinebilden. Azure Machine Learning skapar och kör distributioner åt dig lokalt och cachelagrar avbildningen för snabba iterationer.

Dricks

Om Docker Engine inte startar när datorn startas kan du felsöka Docker Engine. Du kan använda verktyg på klientsidan, till exempel Docker Desktop, för att felsöka vad som händer i containern.

Lokal felsökning omfattar vanligtvis följande steg:

- Kontrollera först att den lokala distributionen lyckades.

- Anropa sedan den lokala slutpunkten för slutsatsdragning.

- Granska slutligen utdataloggarna för åtgärden

invoke.

Lokala slutpunkter har följande begränsningar:

Inget stöd för trafikregler, autentisering eller avsökningsinställningar.

Stöd för endast en distribution per slutpunkt.

Stöd för lokala modellfiler och miljöer med endast lokal conda-fil.

Om du vill testa registrerade modeller laddar du först ned dem med CLI eller SDK och använder

pathsedan i distributionsdefinitionen för att referera till den överordnade mappen.Om du vill testa registrerade miljöer kontrollerar du miljöns kontext i Azure Machine Learning-studio och förbereder en lokal conda-fil som ska användas.

Mer information om lokal felsökning finns i Distribuera och felsöka lokalt med hjälp av en lokal slutpunkt.

Lokal felsökning med lokal slutpunkt och Visual Studio Code (förhandsversion)

Viktigt!

Den här funktionen är för närvarande i allmänt tillgänglig förhandsversion. Den här förhandsversionen tillhandahålls utan ett serviceavtal och vi rekommenderar det inte för produktionsarbetsbelastningar. Vissa funktioner kanske inte stöds eller kan vara begränsade.

Mer information finns i Kompletterande villkor för användning av Microsoft Azure-förhandsversioner.

Precis som med lokal felsökning måste du ha Docker-motorn installerad och igång och sedan distribuera en modell till den lokala Docker-miljön. När du har en lokal distribution använder azure Machine Learning lokala slutpunkter Docker- och Visual Studio Code-utvecklingscontainrar (dev-containrar) för att skapa och konfigurera en lokal felsökningsmiljö.

Med dev-containrar kan du använda Visual Studio Code-funktioner, till exempel interaktiv felsökning inifrån en Docker-container. Mer information om interaktiv felsökning av onlineslutpunkter i Visual Studio Code finns i Felsöka onlineslutpunkter lokalt i Visual Studio Code.

Felsökning med containerloggar

Du kan inte få direkt åtkomst till en virtuell dator där en modell distribueras, men du kan hämta loggar från följande containrar som körs på den virtuella datorn:

- Inferensserverkonsolloggen innehåller utdata från utskrifts-/loggningsfunktioner från ditt bedömningsskript score.py kod.

- Loggar för lagringsinitierare innehåller information om huruvida kod- och modelldata har laddats ned till containern. Containern körs innan inferensservercontainern börjar köras.

Mer information om felsökning med containerloggar finns i Hämta containerloggar.

Trafikroutning och spegling till onlinedistributioner

En enskild onlineslutpunkt kan ha flera distributioner. När slutpunkten tar emot inkommande trafikbegäranden kan den dirigera procentandelar av trafiken till varje distribution, som i den inbyggda blå/gröna distributionsstrategin. Slutpunkten kan också spegla eller kopiera trafik från en distribution till en annan, som kallas för trafikspegling eller skuggning.

Trafikroutning för blå/grön distribution

Blå/grön distribution är en distributionsstrategi som gör att du kan distribuera en ny grön distribution till en liten delmängd av användare eller begäranden innan du distribuerar den helt. Slutpunkten kan implementera belastningsutjämning för att allokera vissa procentandelar av trafiken till varje distribution, där den totala allokeringen för alla distributioner uppgår till upp till 100 %.

Dricks

En begäran kan kringgå den konfigurerade belastningsutjämningen genom att inkludera ett HTTP-huvud för azureml-model-deployment. Ange rubrikvärdet till namnet på den distribution som du vill att begäran ska dirigeras till.

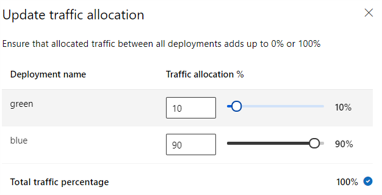

Följande bild visar inställningar i Azure Machine Learning-studio för allokering av trafik mellan en blå och grön distribution.

Föregående trafikallokering dirigerar 10 % av trafiken till den gröna distributionen och 90 % av trafiken till den blå distributionen, enligt följande bild.

Trafikspegling till onlinedistributioner

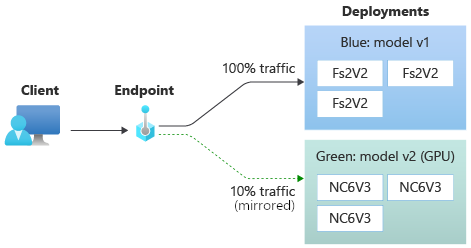

Slutpunkten kan också spegla eller kopiera trafik från en distribution till en annan. Du kan använda trafikspegling, även kallat skuggtestning, när du vill testa en ny distribution med produktionstrafik utan att påverka de resultat som kunderna får från befintliga distributioner.

Du kan till exempel implementera en blå/grön distribution där 100 % av trafiken dirigeras till blått och 10 % speglas i den gröna distributionen. Resultatet av den speglade trafiken till den gröna distributionen returneras inte till klienterna, men måtten och loggarna registreras.

Mer information om hur du använder trafikspegling finns i Utföra säker distribution av nya distributioner för slutsatsdragning i realtid.

Fler onlineslutpunktsfunktioner

I följande avsnitt beskrivs andra funktioner i Azure Machine Learning-onlineslutpunkter.

Autentisering och kryptering

- Autentisering: Nyckel- och Azure Machine Learning-token

- Hanterad identitet: Användartilldelad och systemtilldelad

- SSL (Secure Socket Layer) som standard för slutpunktsanrop

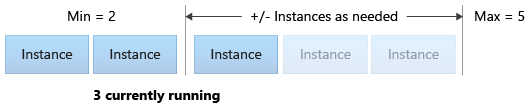

Automatisk skalning

Med autoskalning körs automatiskt rätt mängd resurser för att hantera arbetsbelastningen i appen. Hanterade slutpunkter stöder automatisk skalning genom integrering med autoskalningsfunktionen i Azure Monitor. Du kan konfigurera måttbaserad skalning, till exempel CPU-användning >70 %, schemabaserad skalning, till exempel regler för hög affärstimmen eller båda.

Mer information finns i Autoskala onlineslutpunkter i Azure Machine Learning.

Hanterad nätverksisolering

När du distribuerar en maskininlärningsmodell till en hanterad onlineslutpunkt kan du skydda kommunikationen med onlineslutpunkten med hjälp av privata slutpunkter. Du kan konfigurera säkerhet för inkommande bedömningsbegäranden och utgående kommunikation separat.

Inkommande kommunikation använder den privata slutpunkten för Azure Machine Learning-arbetsytan, medan utgående kommunikation använder privata slutpunkter som skapats för arbetsytans hanterade virtuella nätverk. Mer information finns i Nätverksisolering med hanterade onlineslutpunkter.

Övervaka onlineslutpunkter och distributioner

Azure Machine Learning-slutpunkter integreras med Azure Monitor. Med Azure Monitor-integrering kan du visa mått i diagram, konfigurera aviseringar, fråga loggtabeller och använda Application Insights för att analysera händelser från användarcontainrar. Mer information finns i Övervaka onlineslutpunkter.

Hemlig inmatning i onlinedistributioner (förhandsversion)

Hemlig inmatning för en onlinedistribution innebär att du hämtar hemligheter som API-nycklar från hemliga arkiv och matar in dem i användarcontainern som körs i distributionen. Om du vill tillhandahålla säker hemlig förbrukning för slutsatsdragningsservern som kör ditt bedömningsskript eller inferensstacken i BYOC-distributionen kan du använda miljövariabler för att komma åt hemligheter.

Du kan själv mata in hemligheter med hjälp av hanterade identiteter eller använda funktionen för hemlig inmatning. Mer information finns i Hemlig inmatning i onlineslutpunkter (förhandsversion).

Relaterat innehåll

- Distribuera och poängsätta en maskininlärningsmodell med hjälp av en onlineslutpunkt

- Batch-slutpunkter

- Skydda dina hanterade onlineslutpunkter med nätverksisolering

- Distribuera modeller med REST

- Övervaka onlineslutpunkter

- Visa kostnader för en Azure Machine Learning-hanterad onlineslutpunkt

- Hantera och öka kvoter och gränser för resurser med Azure Machine Learning