Använda Azure Data Lake Storage Gen1 för stordatakrav

Kommentar

Azure Data Lake Storage Gen1 har nu dragits tillbaka. Se pensionsmeddelandet här. Data Lake Storage Gen1-resurser är inte längre tillgängliga.

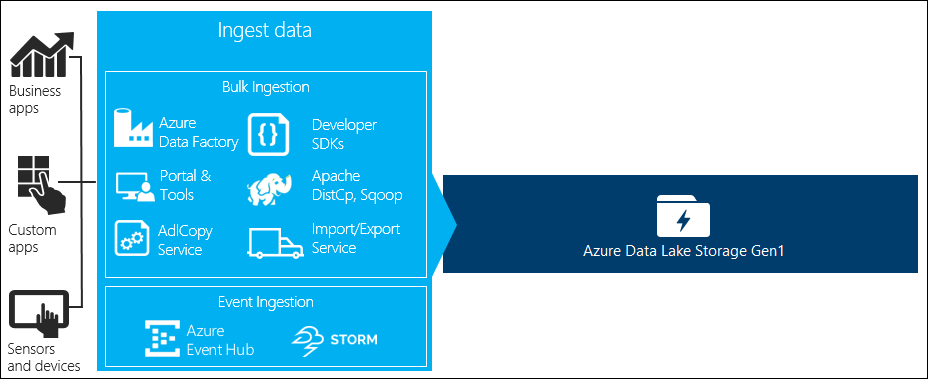

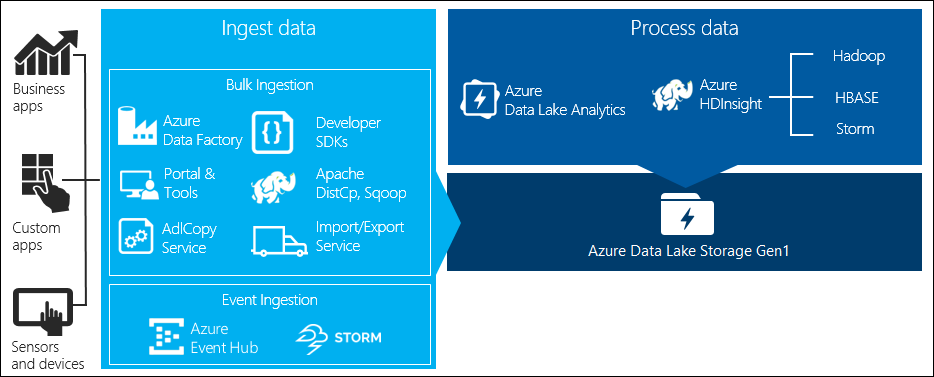

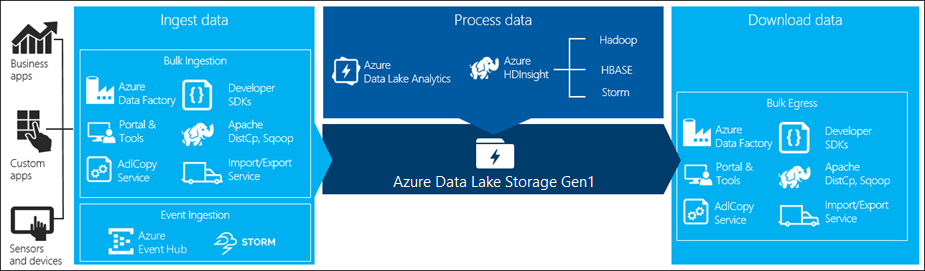

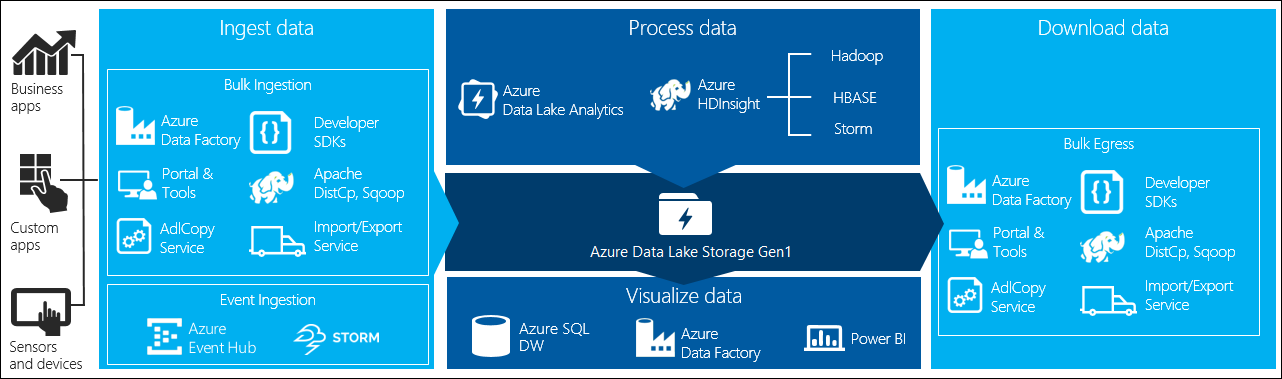

Det finns fyra viktiga steg i bearbetningen av stordata:

- Mata in stora mängder data i ett datalager, i realtid eller i batchar

- Bearbeta data

- Ladda ned data

- Visualisera data

I den här artikeln tittar vi på de här stegen med avseende på Azure Data Lake Storage Gen1 för att förstå vilka alternativ och verktyg som är tillgängliga för att uppfylla dina stordatabehov.

Mata in data i Data Lake Storage Gen1

Det här avsnittet visar de olika datakällorna och de olika sätt på vilka dessa data kan matas in på ett Data Lake Storage Gen1-konto.

Ad hoc-data

Detta representerar mindre datauppsättningar som används för prototyper av ett stordataprogram. Det finns olika sätt att mata in ad hoc-data beroende på datakällan.

| Datakälla | Mata in den med hjälp av |

|---|---|

| Lokal dator | |

| Azure Storage Blob |

Strömmade data

Detta representerar data som kan genereras av olika källor, till exempel program, enheter, sensorer osv. Dessa data kan matas in i Data Lake Storage Gen1 med en mängd olika verktyg. Dessa verktyg samlar vanligtvis in och bearbetar data händelse för händelse i realtid och skriver sedan händelserna i batchar till Data Lake Storage Gen1 så att de kan bearbetas ytterligare.

Följande är verktyg som du kan använda:

- Azure Stream Analytics – Händelser som matas in i Event Hubs kan skrivas till Azure Data Lake Storage Gen1 med hjälp av utdata från Azure Data Lake Storage Gen1.

- EventProcessorHost – Du kan ta emot händelser från Event Hubs och sedan skriva dem till Data Lake Storage Gen1 med hjälp av Data Lake Storage Gen1 .NET SDK.

Relationsdata

Du kan också hämta data från relationsdatabaser. Under en tidsperiod samlar relationsdatabaser in enorma mängder data som kan ge viktiga insikter om de bearbetas via en stordatapipeline. Du kan använda följande verktyg för att flytta sådana data till Data Lake Storage Gen1.

Loggdata för webbserver (ladda upp med anpassade program)

Den här typen av datauppsättning kallas specifikt eftersom analys av webbserverloggdata är ett vanligt användningsfall för stordataprogram och kräver att stora mängder loggfiler laddas upp till Data Lake Storage Gen1. Du kan använda något av följande verktyg för att skriva egna skript eller program för att ladda upp sådana data.

För att ladda upp webbserverloggdata och även för att ladda upp andra typer av data (t.ex. sociala attityddata) är det en bra metod att skriva egna anpassade skript/program eftersom det ger dig flexibiliteten att inkludera din datauppladdningskomponent som en del av ditt större stordataprogram. I vissa fall kan den här koden ha formen av ett skript eller ett enkelt kommandoradsverktyg. I andra fall kan koden användas för att integrera bearbetning av stordata i ett affärsprogram eller en lösning.

Data som är associerade med Azure HDInsight-kluster

De flesta HDInsight-klustertyper (Hadoop, HBase, Storm) stöder Data Lake Storage Gen1 som lagringsplats för datalagring. HDInsight-kluster får åtkomst till data från Azure Storage Blobs (WASB). För bättre prestanda kan du kopiera data från WASB till ett Data Lake Storage Gen1-konto som är associerat med klustret. Du kan använda följande verktyg för att kopiera data.

Data som lagras i lokala eller IaaS Hadoop-kluster

Stora mängder data kan lagras i befintliga Hadoop-kluster lokalt på datorer med HDFS. Hadoop-klustren kan finnas i en lokal distribution eller finnas i ett IaaS-kluster i Azure. Det kan finnas krav på att kopiera sådana data till Azure Data Lake Storage Gen1 för en engångsmetod eller på ett återkommande sätt. Det finns olika alternativ som du kan använda för att uppnå detta. Nedan visas en lista över alternativ och tillhörande kompromisser.

| Metod | Details | Fördelar | Att tänka på |

|---|---|---|---|

| Använd Azure Data Factory (ADF) för att kopiera data direkt från Hadoop-kluster till Azure Data Lake Storage Gen1 | ADF stöder HDFS som datakälla | ADF tillhandahåller inbyggt stöd för HDFS och förstklassig hantering och övervakning från slutpunkt till slutpunkt | Kräver att Data Management Gateway distribueras lokalt eller i IaaS-klustret |

| Exportera data från Hadoop som filer. Kopiera sedan filerna till Azure Data Lake Storage Gen1 med lämplig mekanism. | Du kan kopiera filer till Azure Data Lake Storage Gen1 med hjälp av:

|

Snabb att komma igång. Kan göra anpassade uppladdningar | Process i flera steg som omfattar flera tekniker. Hantering och övervakning kommer att bli en utmaning över tid med tanke på de anpassade verktygens |

| Använd Distcp för att kopiera data från Hadoop till Azure Storage. Kopiera sedan data från Azure Storage till Data Lake Storage Gen1 med lämplig mekanism. | Du kan kopiera data från Azure Storage till Data Lake Storage Gen1 med hjälp av: | Du kan använda verktyg med öppen källkod. | Process i flera steg som omfattar flera tekniker |

Riktigt stora datamängder

För att ladda upp datauppsättningar som sträcker sig i flera terabyte kan det ibland vara långsamt och kostsamt att använda metoderna som beskrivs ovan. I sådana fall kan du använda alternativen nedan.

Använda Azure ExpressRoute. Med Azure ExpressRoute kan du skapa privata anslutningar mellan Azure-datacenter och infrastruktur lokalt. Detta ger ett tillförlitligt alternativ för överföring av stora mängder data. Mer information finns i Dokumentation om Azure ExpressRoute.

Offlineuppladdning av data. Om det inte går att använda Azure ExpressRoute av någon anledning kan du använda Azure Import/Export-tjänsten för att skicka hårddiskar med dina data till ett Azure-datacenter. Dina data laddas först upp till Azure Storage Blobs. Du kan sedan använda Azure Data Factory eller AdlCopy-verktyget för att kopiera data från Azure Storage Blobs till Data Lake Storage Gen1.

Kommentar

När du använder import-/exporttjänsten bör filstorlekarna på de diskar som du skickar till Azure-datacentret inte vara större än 195 GB.

Bearbeta data som lagras i Data Lake Storage Gen1

När data är tillgängliga i Data Lake Storage Gen1 kan du köra analys på dessa data med hjälp av de stordataprogram som stöds. För närvarande kan du använda Azure HDInsight och Azure Data Lake Analytics för att köra dataanalysjobb på data som lagras i Data Lake Storage Gen1.

Du kan titta på följande exempel.

- Skapa ett HDInsight-kluster med Data Lake Storage Gen1 som lagring

- Använda Azure Data Lake Analytics med Data Lake Storage Gen1

Ladda ned data från Data Lake Storage Gen1

Du kanske också vill ladda ned eller flytta data från Azure Data Lake Storage Gen1 för scenarier som:

- Flytta data till andra lagringsplatser för att interagera med dina befintliga databehandlingspipelines. Du kanske till exempel vill flytta data från Data Lake Storage Gen1 till Azure SQL Database eller SQL Server.

- Ladda ned data till din lokala dator för bearbetning i IDE-miljöer när du skapar programprototyper.

I sådana fall kan du använda något av följande alternativ:

Du kan också använda följande metoder för att skriva ett eget skript/program för att ladda ned data från Data Lake Storage Gen1.

Visualisera data i Data Lake Storage Gen1

Du kan använda en blandning av tjänster för att skapa visuella representationer av data som lagras i Data Lake Storage Gen1.

- Du kan börja med att använda Azure Data Factory för att flytta data från Data Lake Storage Gen1 till Azure Synapse Analytics

- Därefter kan du integrera Power BI med Azure Synapse Analytics för att skapa en visuell representation av data.