Meta Llama model ailesini Azure Machine Learning stüdyosu ile kullanma

Bu makalede Meta Lama modelleri ailesi (LLM) hakkında bilgi edineceksiniz. Meta Lama modelleri ve araçları, SLM'lerden (1B, Cihaz içi ve uç çıkarım için 3B Temel ve Yönerge modelleri) - orta ölçekli LLM'lere (7B, 8B ve 70B Base ve Instruct modelleri) ve Meta Llama 3.1 405B gibi yüksek performanslı modeller Yapay veri oluşturma ve distilasyon kullanım örnekleri için yönerge.

İpucu

Meta'nın Lama 3.2 aile modelleri hakkındaki duyurularımızı Meta'nın blogu ve Microsoft Tech Community Blogu aracılığıyla Azure Yapay Zeka Modeli Kataloğu'nda bulabilirsiniz.

LangChain, LiteLLM, OpenAI ve Azure API ile tümleştirmeleri keşfetmek için aşağıdaki GitHub örneklerine bakın.

Önemli

Bu özellik şu anda genel önizlemededir. Bu önizleme sürümü hizmet düzeyi sözleşmesi olmadan sağlanır ve üretim iş yükleri için bu sürümü önermeyiz. Bazı özellikler desteklenmiyor olabileceği gibi özellikleri sınırlandırılmış da olabilir.

Daha fazla bilgi için bkz. Microsoft Azure Önizlemeleri Ek Kullanım Koşulları.

Meta Llama model ailesi

Meta Llama model ailesi aşağıdaki modelleri içerir:

Llama 3.2 koleksiyonu SLM'ler ve görüntü akıl yürütme modelleri artık kullanılabilir. Yakında Llama 3.2 11B Vision Instruct ve Llama 3.2 90B Vision Instruct, Models-as-a-Service aracılığıyla sunucusuz API uç noktası olarak kullanıma sunulacaktır. Bugünden itibaren, aşağıdaki modeller yönetilen işlem aracılığıyla dağıtım için kullanılabilir olacaktır:

- Lama 3.2 1B

- Lama 3.2 3B

- Llama 3.2 1B Yönerge

- Lama 3.2 3B Yönerge

- Lama Guard 3 1B

- Lama Guard 11B Görüntü İşleme

- Lama 3.2 11B Görüntü İşleme Yönergesi

- Llama 3.2 90B Vision Instruct yönetilen işlem dağıtımı için kullanılabilir.

Önkoşullar

Geçerli bir ödeme yöntemine sahip bir Azure aboneliği. Ücretsiz veya deneme Azure abonelikleri çalışmaz. Azure aboneliğiniz yoksa başlamak için ücretli bir Azure hesabı oluşturun.

Azure Machine Learning çalışma alanı ve işlem örneği. Bunlara sahip değilseniz, bunları oluşturmak için Hızlı Başlangıç: Çalışma alanı kaynakları oluşturma makalesindeki adımları kullanın. Meta Llama 3.1 ve Llama 3 için sunucusuz API modeli dağıtım teklifi yalnızca şu bölgelerde oluşturulan çalışma alanlarıyla kullanılabilir:

- Doğu ABD

- Doğu ABD 2

- Orta Kuzey ABD

- Orta Güney ABD

- Batı ABD

- Batı ABD 3

- Orta İsveç

Sunucusuz API uç noktası dağıtımlarını destekleyen modellerin her biri için kullanılabilen bölgelerin listesi için bkz. Sunucusuz API uç noktalarındaki modeller için bölge kullanılabilirliği.

Azure Machine Learning’deki işlemlere erişim vermek için Azure rol tabanlı erişim denetimleri (Azure RBAC) kullanılır. Bu makaledeki adımları gerçekleştirmek için kullanıcı hesabınıza Azure aboneliğinde sahip veya katkıda bulunan rolü atanmalıdır. Alternatif olarak, hesabınıza aşağıdaki izinlere sahip bir özel rol de atanabilir:

Azure aboneliğinde - Çalışma alanının her çalışma alanı ve teklif başına bir kez Azure Market teklifine abone olması için:

Microsoft.MarketplaceOrdering/agreements/offers/plans/readMicrosoft.MarketplaceOrdering/agreements/offers/plans/sign/actionMicrosoft.MarketplaceOrdering/offerTypes/publishers/offers/plans/agreements/readMicrosoft.Marketplace/offerTypes/publishers/offers/plans/agreements/readMicrosoft.SaaS/register/action

Kaynak grubunda - SaaS kaynağını oluşturmak ve kullanmak için:

Microsoft.SaaS/resources/readMicrosoft.SaaS/resources/write

Çalışma alanında - Uç noktaları dağıtmak için (Azure Machine Learning veri bilimci rolü bu izinleri zaten içerir):

Microsoft.MachineLearningServices/workspaces/marketplaceModelSubscriptions/*Microsoft.MachineLearningServices/workspaces/serverlessEndpoints/*

İzinler hakkında daha fazla bilgi için bkz. Azure Machine Learning çalışma alanlarına erişimi yönetme.

Yeni dağıtım oluşturma

Dağıtım oluşturmak için:

Modellerinizi dağıtmak istediğiniz çalışma alanını seçin. Kullandıkça öde modeli dağıtım teklifini kullanmak için çalışma alanınızın bu makalenin önkoşullarında listelenen kullanılabilir bölgelerden birine ait olması gerekir.

Model kataloğundan dağıtmayı seçin

Meta-Llama-3.1-405B-Instruct.Alternatif olarak, çalışma alanınıza gidip Uç Noktalar>Sunucusuz uç noktalar>Oluştur'u seçerek dağıtımı başlatabilirsiniz.

için Ayrıntılar sayfasında

Meta-Llama-3.1-405B-InstructDağıt'ı ve ardından Azure AI İçerik Güvenliği ile Sunucusuz API'yi seçin.Kullanım koşulları hakkında daha fazla bilgi edinmek için dağıtım sihirbazında Azure Market Koşulları bağlantısını seçin. Seçilen modelin fiyatlandırması hakkında bilgi edinmek için Market teklifi ayrıntıları sekmesini de seçebilirsiniz.

Modeli çalışma alanında ilk kez dağıtıyorsanız, çalışma alanınızı belirli bir teklif için (örneğin,

Meta-Llama-3.1-405B-Instruct) Azure Market abone olmanız gerekir. Bu adım, hesabınızın önkoşullarda listelenen Azure abonelik izinlerine ve kaynak grubu izinlerine sahip olmasını gerektirir. Her çalışma alanının, harcamaları denetlemenize ve izlemenize olanak tanıyan belirli Azure Market teklifine kendi aboneliği vardır. Abone Ol ve Dağıt'ı seçin.Not

Çalışma alanını belirli bir Azure Market teklifine abone yapmak (bu örnekte Llama-3-70B), hesabınızın projenin oluşturulduğu abonelik düzeyinde Katkıda Bulunan veya Sahip erişimine sahip olmasını gerektirir. Alternatif olarak, kullanıcı hesabınıza önkoşullarda listelenen Azure aboneliği izinlerine ve kaynak grubu izinlerine sahip özel bir rol atanabilir.

Belirli bir Azure Market teklifi için çalışma alanına kaydolduktan sonra, aynı teklifin aynı çalışma alanında sonraki dağıtımları için yeniden abone olmanız gerekmez. Bu nedenle, sonraki dağıtımlar için abonelik düzeyinde izinlere sahip olmanız gerekmez. Bu senaryo sizin için geçerliyse dağıtmak için Devam'ı seçin.

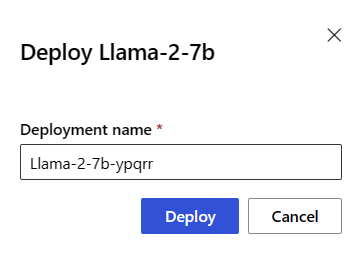

Dağıtıma bir ad verin. Bu ad, dağıtım API'si URL'sinin bir parçası olur. Bu URL her Azure bölgesinde benzersiz olmalıdır.

Dağıt'ı seçin. Dağıtım tamamlanana ve sunucusuz uç noktalar sayfasına yönlendirilene kadar bekleyin.

Uç noktayı seçerek Ayrıntılar sayfasını açın.

Modelle etkileşime geçmek için Test sekmesini seçin.

Ayrıca, dağıtımı çağırmak ve tamamlamaları oluşturmak için Hedef URL'yi ve Gizli Anahtar'ı da not alabilirsiniz.

Her zaman Çalışma Alanı>Uç Noktaları Sunucusuz uç noktalarına> giderek uç noktanın ayrıntılarını, URL'sini ve erişim anahtarlarını bulabilirsiniz.

Sunucusuz API olarak dağıtılan Meta Llama modellerinin faturalaması hakkında bilgi edinmek için bkz . Sunucusuz API olarak dağıtılan Meta Llama modelleri için maliyet ve kota konuları.

Meta Lama modellerini hizmet olarak kullanma

Hizmet olarak dağıtılan modeller, dağıtılan modelin türüne bağlı olarak sohbet veya tamamlamaLAR API'si kullanılarak kullanılabilir.

Çalışma alanında Uç Noktalar>Sunucusuz uç noktalar'ı seçin.

Oluşturduğunuz dağıtımı bulun ve seçin

Meta-Llama-3.1-405B-Instruct.Hedef URL'yi ve Anahtar belirteci değerlerini kopyalayın.

Dağıtılan modelin türüne göre bir API isteğinde bulunun.

- gibi

Llama-3-8Btamamlama modelleri için API'yi<target_url>/v1/completionskullanın. - gibi

Meta-Llama-3.1-405B-Instructsohbet modelleri için API'yi/chat/completionskullanın.

API'leri kullanma hakkında daha fazla bilgi için başvuru bölümüne bakın.

- gibi

Sunucusuz API dağıtılan Meta Llama 3.1 modelleri için başvuru

Lama modelleri hem yolda /chat/completions Azure AI Model Çıkarım API'sini hem de üzerinde bir Lama Sohbet API'sini kabul edebilir/v1/chat/completions. Aynı şekilde, metin tamamlama işlemleri rotadaki /completions Azure AI Model Çıkarımı API'sini veya üzerinde bir Lama Tamamlamaları API'sini kullanarak oluşturulabilir/v1/completions

Azure AI Model Çıkarım API şeması, Sohbet Tamamlamaları referansı makalesinde bulunabilir ve uç noktanın kendisinden bir OpenAPI belirtimi elde edilebilir.

Tamamlamalar API'si

İsteği yola göndermek için /v1/completions yöntemini POST kullanın:

İste

POST /v1/completions HTTP/1.1

Host: <DEPLOYMENT_URI>

Authorization: Bearer <TOKEN>

Content-type: application/json

İstek şeması

Payload, aşağıdaki parametreleri içeren JSON biçimli bir dizedir:

| Anahtar | Tür | Varsayılan | Açıklama |

|---|---|---|---|

prompt |

string |

Varsayılan yoktur. Bu değer belirtilmelidir. | Modele gönderme istemi. |

stream |

boolean |

False |

Akış, oluşturulan belirteçlerin her kullanılabilir olduğunda yalnızca veri sunucu tarafından gönderilen olaylar olarak gönderilmesini sağlar. |

max_tokens |

integer |

16 |

Tamamlanmada oluşturulacak en fazla belirteç sayısı. İsteminizin ve artı max_tokens değerin belirteç sayısı modelin bağlam uzunluğunu aşamaz. |

top_p |

float |

1 |

Modelin olasılık kütleli belirteçlerin sonuçlarını dikkate aldığı, çekirdek örneklemesi olarak adlandırılan sıcaklıkla top_p örneklemeye alternatiftir. Bu nedenle 0,1 yalnızca ilk %10 olasılık kütlesinden oluşan belirteçlerin dikkate alınması anlamına gelir. Genellikle veya temperaturedeğiştirmenizi top_p öneririz, ancak ikisini birden önermeyiz. |

temperature |

float |

1 |

0 ile 2 arasında kullanılacak örnekleme sıcaklığı. Daha yüksek değerler, model örneklerinin belirteçlerin daha geniş bir şekilde dağıtılması anlamına gelir. Sıfır, doyumsuz örnekleme anlamına gelir. Bunu veya top_pdeğiştirmenizi öneririz, ancak ikisini birden değiştirmemenizi öneririz. |

n |

integer |

1 |

Her istem için kaç tamamlama oluşturulacağı. Not: Bu parametre birçok tamamlama oluşturduğundan belirteç kotanızı hızla kullanabilir. |

stop |

array |

null |

Dize veya API'nin başka belirteçler oluşturmayı durdurduğu sözcüğü içeren dizelerin listesi. Döndürülen metin durdurma sırasını içermez. |

best_of |

integer |

1 |

Tamamlamaları best_of sunucu tarafı oluşturur ve "en iyi" değerini (belirteç başına en düşük günlük olasılığına sahip olan) döndürür. Sonuçlar akışla aktarılamaz. ile nkullanıldığında, best_of aday tamamlama sayısını denetler ve n döndürülecek sayısını belirtir; best_of değerinden nbüyük olması gerekir. Not: Bu parametre birçok tamamlama oluşturduğundan belirteç kotanızı hızla kullanabilir. |

logprobs |

integer |

null |

En olası belirteçlere ve seçilen belirteçlere günlük olasılıklarını logprobs eklemeyi gösteren bir sayı. Örneğin, 10 ise logprobs , API en olası 10 belirtecin listesini döndürür. API her zaman örneklenen belirtecin logprob'unu döndürür, bu nedenle yanıtta en fazla logprobs+1 öğe olabilir. |

presence_penalty |

float |

null |

-2,0 ile 2,0 arasında bir sayı. Pozitif değerler, yeni belirteçleri metinde şu ana kadar görünip görünmediklerine göre cezalandırarak modelin yeni konularla ilgili konuşma olasılığını artırır. |

ignore_eos |

boolean |

True |

EOS belirtecinin yoksayılıp yoksayılmayacağı ve EOS belirteci oluşturulduktan sonra belirteç oluşturmaya devam edilip edilmeyeceği. |

use_beam_search |

boolean |

False |

Örnekleme yerine ışın aramasının kullanılıp kullanılmaymayacağı. Böyle bir durumda, best_of değerinden 1 büyük ve temperature olmalıdır 0. |

stop_token_ids |

array |

null |

Oluşturulduğunda daha fazla belirteç oluşturmayı durduran belirteçler için kimliklerin listesi. Döndürülen çıkış, durdurma belirteçleri özel belirteçler olmadığı sürece durdurma belirteçlerini içerir. |

skip_special_tokens |

boolean |

null |

Çıkıştaki özel belirteçlerin atlanıp atlanmayacağı. |

Örnek

Gövde

{

"prompt": "What's the distance to the moon?",

"temperature": 0.8,

"max_tokens": 512,

}

Yanıt şeması

Yanıt yükü, aşağıdaki alanlara sahip bir sözlüktür.

| Anahtar | Type | Açıklama |

|---|---|---|

id |

string |

Tamamlanma için benzersiz bir tanımlayıcı. |

choices |

array |

Giriş istemi için modelin oluşturduğu tamamlama seçeneklerinin listesi. |

created |

integer |

Tamamlanmanın oluşturulduğu Unix zaman damgası (saniye olarak). |

model |

string |

Tamamlanmak için kullanılan model_id. |

object |

string |

Her zaman text_completionolan nesne türü. |

usage |

object |

Tamamlanma isteği için kullanım istatistikleri. |

İpucu

Akış modunda, her yanıt öbeği için, finish_reason bir yük [DONE]tarafından sonlandırılan son öbek dışında her zaman nullolur.

choices nesnesi aşağıdaki alanlara sahip bir sözlüktür.

| Anahtar | Type | Açıklama |

|---|---|---|

index |

integer |

Seçim dizini. 1 olduğunda best_of> , bu dizideki dizin sıralı olmayabilir ve 0 ile n-1 arasında olmayabilir. |

text |

string |

Tamamlanma sonucu. |

finish_reason |

string |

Modelin belirteç oluşturma işlemini durdurmasının nedeni: - stop: model doğal bir durdurma noktasına veya sağlanan bir durdurma dizisine isabet etti. - length: en fazla belirteç sayısına ulaşıldıysa. - content_filter: RAI moderatör olduğunda ve CMP moderasyonu zorladığında. - content_filter_error: denetim sırasında bir hata oluştu ve yanıtla ilgili karar veremedi. - null: API yanıtı devam ediyor veya tamamlanmadı. |

logprobs |

object |

Çıkış metninde oluşturulan belirteçlerin günlük olasılıkları. |

usage nesnesi aşağıdaki alanlara sahip bir sözlüktür.

| Anahtar | Tür | Değer |

|---|---|---|

prompt_tokens |

integer |

İstemdeki belirteç sayısı. |

completion_tokens |

integer |

Tamamlanmada oluşturulan belirteçlerin sayısı. |

total_tokens |

integer |

Toplam belirteç sayısı. |

logprobs nesnesi aşağıdaki alanlara sahip bir sözlüktür:

| Anahtar | Tür | Değer |

|---|---|---|

text_offsets |

array / integers |

Tamamlanma çıkışındaki her belirtecin konumu veya dizini. |

token_logprobs |

array / float |

Dizideki top_logprobs sözlükten seçildilogprobs. |

tokens |

array / string |

Seçili belirteçler. |

top_logprobs |

array / dictionary |

Sözlük dizisi. Her sözlükte anahtar belirteç, değer ise olasılıktır. |

Örnek

{

"id": "12345678-1234-1234-1234-abcdefghijkl",

"object": "text_completion",

"created": 217877,

"choices": [

{

"index": 0,

"text": "The Moon is an average of 238,855 miles away from Earth, which is about 30 Earths away.",

"logprobs": null,

"finish_reason": "stop"

}

],

"usage": {

"prompt_tokens": 7,

"total_tokens": 23,

"completion_tokens": 16

}

}

Sohbet API'si

İsteği yola göndermek için /v1/chat/completions yöntemini POST kullanın:

İste

POST /v1/chat/completions HTTP/1.1

Host: <DEPLOYMENT_URI>

Authorization: Bearer <TOKEN>

Content-type: application/json

İstek şeması

Payload, aşağıdaki parametreleri içeren JSON biçimli bir dizedir:

| Anahtar | Tür | Varsayılan | Açıklama |

|---|---|---|---|

messages |

string |

Varsayılan yoktur. Bu değer belirtilmelidir. | Modele sorulmak için kullanılacak ileti veya ileti geçmişi. |

stream |

boolean |

False |

Akış, oluşturulan belirteçlerin her kullanılabilir olduğunda yalnızca veri sunucu tarafından gönderilen olaylar olarak gönderilmesini sağlar. |

max_tokens |

integer |

16 |

Tamamlanmada oluşturulacak en fazla belirteç sayısı. İsteminizin ve artı max_tokens değerin belirteç sayısı modelin bağlam uzunluğunu aşamaz. |

top_p |

float |

1 |

Modelin olasılık kütleli belirteçlerin sonuçlarını dikkate aldığı, çekirdek örneklemesi olarak adlandırılan sıcaklıkla top_p örneklemeye alternatiftir. Bu nedenle 0,1 yalnızca ilk %10 olasılık kütlesinden oluşan belirteçlerin dikkate alınması anlamına gelir. Genellikle veya temperaturedeğiştirmenizi top_p öneririz, ancak ikisini birden önermeyiz. |

temperature |

float |

1 |

0 ile 2 arasında kullanılacak örnekleme sıcaklığı. Daha yüksek değerler, model örneklerinin belirteçlerin daha geniş bir şekilde dağıtılması anlamına gelir. Sıfır, doyumsuz örnekleme anlamına gelir. Bunu veya top_pdeğiştirmenizi öneririz, ancak ikisini birden değiştirmemenizi öneririz. |

n |

integer |

1 |

Her istem için kaç tamamlama oluşturulacağı. Not: Bu parametre birçok tamamlama oluşturduğundan belirteç kotanızı hızla kullanabilir. |

stop |

array |

null |

Dize veya API'nin başka belirteçler oluşturmayı durdurduğu sözcüğü içeren dizelerin listesi. Döndürülen metin durdurma sırasını içermez. |

best_of |

integer |

1 |

Tamamlamaları best_of sunucu tarafı oluşturur ve "en iyi" değerini (belirteç başına en düşük günlük olasılığına sahip olan) döndürür. Sonuçlar akışla aktarılamaz. ile nbest_of kullanıldığında, aday tamamlama sayısını denetler ve n döndürülecek sayısını belirtir;best_of değerinden nbüyük olmalıdır. Not: Bu parametre birçok tamamlama oluşturduğundan belirteç kotanızı hızla kullanabilir. |

logprobs |

integer |

null |

En olası belirteçlere ve seçilen belirteçlere günlük olasılıklarını logprobs eklemeyi gösteren bir sayı. Örneğin, 10 ise logprobs , API en olası 10 belirtecin listesini döndürür. API her zaman örneklenen belirtecin logprob'unu döndürür, bu nedenle yanıtta en fazla logprobs+1 öğe olabilir. |

presence_penalty |

float |

null |

-2,0 ile 2,0 arasında bir sayı. Pozitif değerler, yeni belirteçleri metinde şu ana kadar görünip görünmediklerine göre cezalandırarak modelin yeni konularla ilgili konuşma olasılığını artırır. |

ignore_eos |

boolean |

True |

EOS belirtecinin yoksayılıp yoksayılmayacağı ve EOS belirteci oluşturulduktan sonra belirteç oluşturmaya devam edilip edilmeyeceği. |

use_beam_search |

boolean |

False |

Örnekleme yerine ışın aramasının kullanılıp kullanılmaymayacağı. Böyle bir durumda, best_of değerinden 1 büyük ve temperature olmalıdır 0. |

stop_token_ids |

array |

null |

Oluşturulduğunda daha fazla belirteç oluşturmayı durduran belirteçler için kimliklerin listesi. Döndürülen çıkış, durdurma belirteçleri özel belirteçler olmadığı sürece durdurma belirteçlerini içerir. |

skip_special_tokens |

boolean |

null |

Çıkıştaki özel belirteçlerin atlanıp atlanmayacağı. |

messages Nesnesi aşağıdaki alanlara sahiptir:

| Anahtar | Tür | Değer |

|---|---|---|

content |

string |

İletinin içeriği. tüm iletiler için içerik gereklidir. |

role |

string |

İletinin yazarının rolü. system, userveya assistant. |

Örnek

Gövde

{

"messages":

[

{

"role": "system",

"content": "You are a helpful assistant that translates English to Italian."},

{

"role": "user",

"content": "Translate the following sentence from English to Italian: I love programming."

}

],

"temperature": 0.8,

"max_tokens": 512,

}

Yanıt şeması

Yanıt yükü, aşağıdaki alanlara sahip bir sözlüktür.

| Anahtar | Type | Açıklama |

|---|---|---|

id |

string |

Tamamlanma için benzersiz bir tanımlayıcı. |

choices |

array |

Modelin giriş iletileri için oluşturduğu tamamlama seçimlerinin listesi. |

created |

integer |

Tamamlanmanın oluşturulduğu Unix zaman damgası (saniye olarak). |

model |

string |

Tamamlanmak için kullanılan model_id. |

object |

string |

Her zaman chat.completionolan nesne türü. |

usage |

object |

Tamamlanma isteği için kullanım istatistikleri. |

İpucu

Akış modunda, her yanıt öbeği için, finish_reason bir yük [DONE]tarafından sonlandırılan son öbek dışında her zaman nullolur. Her choices nesnede, için messages anahtarı tarafından deltadeğiştirilir.

choices nesnesi aşağıdaki alanlara sahip bir sözlüktür.

| Anahtar | Type | Açıklama |

|---|---|---|

index |

integer |

Seçim dizini. 1 olduğundabest_of>, bu dizideki dizin sıralı olmayabilir ve için n-1olmayabilir0. |

messages veya delta |

string |

Nesnede messages sohbet tamamlama sonucu. Akış modu kullanıldığında anahtar delta kullanılır. |

finish_reason |

string |

Modelin belirteç oluşturma işlemini durdurmasının nedeni: - stop: model doğal bir durdurma noktasına veya sağlanan bir durdurma dizisine isabet etti. - length: en fazla belirteç sayısına ulaşıldıysa. - content_filter: RAI moderatör olduğunda ve CMP moderasyonu zorladığında - content_filter_error: denetim sırasında bir hata oluştu ve yanıtla ilgili karar veremedi - null: API yanıtı devam ediyor veya tamamlanmadı. |

logprobs |

object |

Çıkış metninde oluşturulan belirteçlerin günlük olasılıkları. |

usage nesnesi aşağıdaki alanlara sahip bir sözlüktür.

| Anahtar | Tür | Değer |

|---|---|---|

prompt_tokens |

integer |

İstemdeki belirteç sayısı. |

completion_tokens |

integer |

Tamamlanmada oluşturulan belirteçlerin sayısı. |

total_tokens |

integer |

Toplam belirteç sayısı. |

logprobs nesnesi aşağıdaki alanlara sahip bir sözlüktür:

| Anahtar | Tür | Değer |

|---|---|---|

text_offsets |

array / integers |

Tamamlanma çıkışındaki her belirtecin konumu veya dizini. |

token_logprobs |

array / float |

Dizideki top_logprobs sözlükten seçildilogprobs. |

tokens |

array / string |

Seçili belirteçler. |

top_logprobs |

array / dictionary |

Sözlük dizisi. Her sözlükte anahtar belirteç, değer ise olasılıktır. |

Örnek

Aşağıda örnek bir yanıt gösterilmektedir:

{

"id": "12345678-1234-1234-1234-abcdefghijkl",

"object": "chat.completion",

"created": 2012359,

"model": "",

"choices": [

{

"index": 0,

"finish_reason": "stop",

"message": {

"role": "assistant",

"content": "Sure, I\'d be happy to help! The translation of ""I love programming"" from English to Italian is:\n\n""Amo la programmazione.""\n\nHere\'s a breakdown of the translation:\n\n* ""I love"" in English becomes ""Amo"" in Italian.\n* ""programming"" in English becomes ""la programmazione"" in Italian.\n\nI hope that helps! Let me know if you have any other sentences you\'d like me to translate."

}

}

],

"usage": {

"prompt_tokens": 10,

"total_tokens": 40,

"completion_tokens": 30

}

}

Meta Llama modellerini yönetilen işlem için dağıtma

Kullandıkça öde yönetilen hizmetiyle dağıtmanın yanı sıra Meta Llama 3.1 modellerini Azure Machine Learning stüdyosu yönetilen işlem için de dağıtabilirsiniz. Yönetilen işleme dağıtıldığında, kullanılacak sanal makineler ve beklediğiniz yükü kaldıracak örnek sayısı dahil olmak üzere modeli çalıştıran altyapıyla ilgili tüm ayrıntıları seçebilirsiniz. Yönetilen işlem kotasına dağıtılan modeller aboneliğinizden kota tüketir. Yönetilen işlemde 3.1 sürüm dalgasından aşağıdaki modeller kullanılabilir:

Meta-Llama-3.1-8B-Instruct(FT desteklenir)Meta-Llama-3.1-70B-Instruct(FT desteklenir)Meta-Llama-3.1-8B(FT desteklenir)Meta-Llama-3.1-70B(FT desteklenir)Llama Guard 3 8BPrompt Guard

Yeni dağıtım oluşturma

gibi Meta-Llama-3.1-70B-Instruct bir modeli Azure Machine Learning stüdyosu yönetilen bir işleme dağıtmak için bu adımları izleyin.

Modeli dağıtmak istediğiniz çalışma alanını seçin.

Stüdyonun model kataloğundan dağıtmak istediğiniz modeli seçin.

Alternatif olarak, çalışma alanınıza gidip Uç Noktalar>Yönetilen Hesaplama>Oluşturma'yı seçerek dağıtımı başlatabilirsiniz.

Modelin genel bakış sayfasında Dağıt'ı ve ardından Azure AI İçerik Güvenliği olmadan Yönetilen İşlem'i seçin.

Azure AI İçerik Güvenliği ile Dağıt (önizleme) sayfasında Azure AI İçerik Güvenliği'ni atla'yı seçerek modeli kullanıcı arabirimini kullanarak dağıtmaya devam edebilirsiniz.

İpucu

Genel olarak Meta Llama modelinin dağıtımı için Azure AI İçerik Güvenliğini Etkinleştir (Önerilen) seçeneğini belirlemenizi öneririz. Bu dağıtım seçeneği şu anda yalnızca Python SDK'sı kullanılarak desteklenir ve bir not defterinde gerçekleşir.

Devam Et'i seçin.

İpucu

Seçili projede yeterli kotanız yoksa, Paylaşılan kota kullanmak istiyorum seçeneğini kullanabilirsiniz ve bu uç noktanın 168 saat içinde silineceğini kabul ediyorum.

Dağıtıma atamak istediğiniz Sanal makineyi ve Örnek sayısını seçin.

Bu dağıtımı yeni bir uç noktanın veya mevcut bir uç noktanın parçası olarak oluşturmak isteyip istemediğinizi seçin. Uç noktalar, kaynak yapılandırmasını her biri için özel olarak tutarken birden çok dağıtım barındırabilir. Aynı uç nokta altındaki dağıtımlar uç nokta URI'sini ve erişim anahtarlarını paylaşır.

Çıkarım veri toplamayı (önizleme) etkinleştirmek isteyip istemediğinizi belirtin.

Paket Modeli'nin (önizleme) etkinleştirilmesini isteyip istemediğinizi belirtin.

Dağıt'ı seçin. Birkaç dakika sonra uç noktanın Ayrıntılar sayfası açılır.

Uç nokta oluşturma ve dağıtımının tamamlanmasını bekleyin. Bu adım birkaç dakika sürebilir.

Uygulamanızda dağıtılan modeli kullanmak için kullanabileceğiniz kod örneklerini almak için uç noktanın Kullan sayfasını seçin.

Studio kullanarak yönetilen işlemde modelleri dağıtma hakkında daha fazla bilgi için bkz . Çıkarım için temel modelleri uç noktalara dağıtma.

Yönetilen işlemde dağıtılan Meta Llama modellerini kullanma

Yönetilen işlemde dağıtılan Meta Llama 3 modellerini çağırma hakkında başvuru için Azure Machine Learning stüdyosu model kataloğunda modelin kartına bakın. Her modelin kartında modelin açıklamasını, kod tabanlı çıkarım, ince ayarlama ve model değerlendirmesi için örnekler içeren bir genel bakış sayfası vardır.

Ek çıkarım örnekleri

| Paket | Örnek Not Defteri |

|---|---|

| CURL ve Python web isteklerini kullanan CLI | webrequests.ipynb |

| OpenAI SDK (deneysel) | openaisdk.ipynb |

| LangChain | langchain.ipynb |

| LiteLLM SDK | litellm.ipynb |

Maliyet ve kotalar

Sunucusuz API olarak dağıtılan Meta Llama 3.1 modelleri için maliyet ve kota konuları

Sunucusuz API olarak dağıtılan Meta Llama 3.1 modelleri Meta tarafından Azure Market aracılığıyla sunulur ve kullanım için Azure Machine Learning stüdyosu ile tümleştirilir. Modelleri dağıtırken veya ince ayar yaparken Azure Market fiyatlandırmasını bulabilirsiniz.

Bir çalışma alanı Azure Market'ten belirli bir model teklifine her abone olduğunda tüketimiyle ilişkili maliyetleri izlemek için yeni bir kaynak oluşturulur. Çıkarımla veya ince ayar yapmayla ilişkili maliyetleri izlemek için aynı kaynak kullanılır ancak, her senaryoda bağımsız izleme için birden çok metre kullanılabilir.

Maliyetlerin nasıl izleneceği hakkında daha fazla bilgi için Azure Market aracılığıyla sunulan modellerin maliyetlerini izleme bölümüne bakın.

Kota dağıtım başına yönetilir. Her dağıtımın dakikada 400.000 belirteç ve dakikada 1.000 API isteği hız sınırı vardır. Ancak şu anda proje başına model başına bir dağıtımla sınırlandırıyoruz. Geçerli hız sınırları senaryolarınız için yeterli değilse Microsoft Azure Desteği'ne başvurun.

Yönetilen işlem dağıtılan Meta Llama 3.1 modelleri için maliyet ve kota konuları

Meta Llama 3.1 modellerinin yönetilen işlemle dağıtılması ve çıkarılması için, bölge bazında aboneliğinize atanan sanal makine (VM) çekirdek kotasını kullanırsınız. Azure Yapay Zeka Stüdyosu'na kaydolduğunuzda, bölgede kullanılabilen çeşitli VM aileleri için varsayılan bir VM kotası alırsınız. Kota sınırınıza ulaşana kadar dağıtım oluşturmaya devam edebilirsiniz. Bu sınıra ulaştıktan sonra kota artışı isteyebilirsiniz.

İçerik filtrelemesi

Sunucusuz API olarak dağıtılan modeller Azure AI içerik güvenliği tarafından korunur. Yönetilen işleme dağıtıldığında bu özelliği devre dışı bırakabilirsiniz. Azure AI içerik güvenliği etkinleştirildiğinde, hem istem hem de tamamlama, zararlı içeriğin çıkışını algılamayı ve önlemeyi hedefleyen sınıflandırma modellerinden oluşan bir topluluk aracılığıyla geçer. İçerik filtreleme (önizleme) sistemi, hem giriş istemlerinde hem de çıkış tamamlamalarında zararlı olabilecek içeriğin belirli kategorilerini algılar ve bu kategoriler üzerinde işlem gerçekleştirir. Azure AI İçerik Güvenliği hakkında daha fazla bilgi edinin.