Hızlı Başlangıç: Azure Kinect gövde izlemeyi ayarlama

Bu hızlı başlangıç, Azure Kinect DK'nizde vücut izlemeyi çalıştırma işleminde size yol gösterir.

Sistem gereksinimleri

Gövde İzleme SDK'sı, ana bilgisayarda yüklü bir NVIDIA GPU gerektirir. Önerilen gövde izleme ana bilgisayar gereksinimi sistem gereksinimleri sayfasında açıklanmıştır.

Yazılımı yükleme

En son NVIDIA Sürücüsünü yükleme

Grafik kartınız için en son NVIDIA sürücüsünü indirin ve yükleyin. Eski sürücüler, gövde izleme SDK'sı ile yeniden dağıtılan CUDA ikili dosyalarıyla uyumlu olmayabilir.

Visual Studio için Visual C++ Yeniden Dağıtılabilir 2015

Visual Studio için Visual C++ Yeniden Dağıtılabilir 2015'i indirin ve yükleyin.

Donanımı kurma

Azure Kinect DK’yi kurma

Azure Kinect DK'nizin doğru ayarlandığını denetlemek için Azure Kinect Görüntüleyicisi'ni başlatın.

Gövde İzleme SDK’sını indirin

- Gövde İzleme SDK'sını İndirme bağlantısını seçin

- Bilgisayarınıza Gövde İzleme SDK'sını yükleyin.

Gövde izlemeyi doğrulama

Gövde İzleme SDK'sının doğru ayarlandığını denetlemek için Azure Kinect Gövde İzleme Görüntüleyicisi'ni başlatın. Görüntüleyici, SDK msi yükleyicisi ile yüklenir. Başlangıç menünüzü veya adresinde <SDK Installation Path>\tools\k4abt_simple_3d_viewer.exebulabilirsiniz.

Yeterince güçlü bir GPU'nuz yoksa ve yine de sonucu test etmek istiyorsanız, aşağıdaki komutu kullanarak komut satırında Azure Kinect Gövde İzleme Görüntüleyicisi'ni başlatabilirsiniz:<SDK Installation Path>\tools\k4abt_simple_3d_viewer.exe CPU

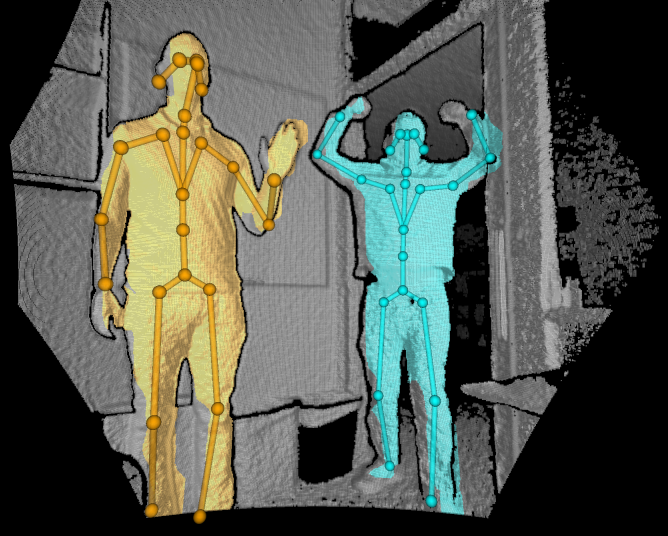

Her şey doğru ayarlanmışsa, 3B nokta bulutu ve izlenen gövdeleri olan bir pencere görünmelidir.

ONNX Çalışma Zamanı yürütme ortamını belirtme

Gövde İzleme SDK'sı, poz tahmin modelini çıkarsamak için CPU, CUDA, DirectML (yalnızca Windows) ve TensorRT yürütme ortamlarını destekler. Varsayılan K4ABT_TRACKER_PROCESSING_MODE_GPU olarak Linux'ta CUDA yürütme ve Windows'da DirectML yürütmesi. Belirli yürütme ortamlarını seçmek için üç farklı mod eklenmiştir: K4ABT_TRACKER_PROCESSING_MODE_GPU_CUDA, K4ABT_TRACKER_PROCESSING_MODE_GPU_DIRECTMLve K4ABT_TRACKER_PROCESSING_MODE_GPU_TENSORRT.

Not

ONNX Çalışma Zamanı, hızlandırılmayan opcode'lar için uyarılar görüntüler. Bunlar güvenle yoksayılabilir.

ONNX Runtime, TensorRT model önbelleğini denetlemek için ortam değişkenleri içerir. Önerilen değerler şunlardır:

- ORT_TENSORRT_ENGINE_CACHE_ENABLE=1

- ORT_TENSORRT_CACHE_PATH="pathname"

Klasör, gövde izleme başlatılmadan önce oluşturulmalıdır.

Önemli

TensorRT, çıkarım öncesinde modeli önceden işler ve diğer yürütme ortamlarıyla karşılaştırıldığında genişletilmiş başlangıç süreleri elde eder. Altyapı önbelleği bunu ilk yürütmeyle sınırlar ancak deneyseldir ve modele, ONNX Çalışma Zamanı sürümüne, TensorRT sürümüne ve GPU modeline özgüdür.

TensorRT yürütmesi hem FP32 (varsayılan) hem de FP16 Çevre desteği. FP16, minimum doğruluk düşüşleri için ~2 kat performans artışı elde ediyor. FP16 belirtmek için:

- ORT_TENSORRT_FP16_ENABLE=1

ONNX Çalışma Zamanı yürütme ortamları için gerekli DLL'ler

| Mod | ORT 1.10 | CUDA 11.4.3 | CUDNN 8.2.2.26 | TensorRT 8.0.3.4 |

|---|---|---|---|---|

| CPU | msvcp140 | - | - | - |

| onnxruntime | ||||

| CUDA | msvcp140 | cudart64_110 | cudnn64_8 | - |

| onnxruntime | cufft64_10 | cudnn_ops_infer64_8 | ||

| onnxruntime_providers_cuda | cublas64_11 | cudnn_cnn_infer64_8 | ||

| onnxruntime_providers_shared | cublasLt64_11 | |||

| DirectML | msvcp140 | - | - | - |

| onnxruntime | ||||

| directml | ||||

| TensorRT | msvcp140 | cudart64_110 | - | nvinfer |

| onnxruntime | cufft64_10 | nvinfer_plugin | ||

| onnxruntime_providers_cuda | cublas64_11 | |||

| onnxruntime_providers_shared | cublasLt64_11 | |||

| onnxruntime_providers_tensorrt | nvrtc64_112_0 | |||

| nvrtc-builtins64_114 |

Örnekler

Gövde izleme SDK'sını kullanmayla ilgili örnekleri burada bulabilirsiniz.