評估生成式 AI 應用程式

重要

本文中標示為 (預覽) 的項目目前處於公開預覽狀態。 此預覽版本沒有服務等級協定,不建議將其用於生產工作負載。 可能不支援特定功能,或可能已經限制功能。 如需詳細資訊,請參閱 Microsoft Azure 預覽版增補使用條款。

透過 Azure OpenAI 服務推動語言模型的進展 (如 GPT-4),提供了充滿希望的前景,而同時也帶來了與負責任 AI 相關的挑戰。 如果未仔細設計,這些模型所建置的系統可能會延續現有的社會偏見、促進錯誤資訊、建立操縱性內容,或導致各種其他負面影響。 要解決這些風險,同時將使用者權益最大化,可採反覆式方法並透過四個階段來實現: 識別、測量及減輕、運作。

測量階段提供關鍵資訊,以引導開發品質與安全性。 一方面,這包括效能和品質的評估。 另一方面,在評估風險和安全性時,這包括評估 AI 系統對不同風險的傾向 (每個風險都有不同的嚴重性)。 在這兩種情況下,都是透過建立清楚的計量、建立測試集,以及完成反覆性與系統化測試,來達成目的。 此測量階段為從業者提供訊號,通知鎖定目標的風險降低步驟,例如提示工程和內容篩選的應用。 套用風險降低後,即可重複評估以測試有效性。

Azure AI Studio 為從業者提供手動和自動化評估的工具,可協助您進行測量階段。 建議您從手動評估開始,然後進行到自動化評估。 手動評估,也就是手動檢閱應用程式產生的輸出,對於追蹤一小組優先順序問題的進度很有用。 在降低特定風險時,通常最有效的做法是,持續手動檢查小型資料集的進度,直到在移至自動化評估之前不再觀察到風險證據。 Azure AI Studio 支援快速檢查小型資料集的手動評估體驗。

自動化評估適用於大規模測量品質和安全性,擁有更大的涵蓋範圍,可提供更全面的結果。 自動化評估工具也會啟用持續評估,隨著系統、使用方式和風險降低的演進,定期執行以監視回歸。 我們支援生成式 AI 應用程式自動化評估的兩個主要方法: 傳統機器學習評估和 AI 輔助評估。

傳統機器學習測量

在生成式 AI 的內容中,當我們想要量化所產生輸出相較於預期答案的正確性時,傳統機器學習評估 (產生傳統機器學習計量) 很有用。 在您能夠存取基準真相和預期答案時,傳統計量很有用。

- 基準真相是指我們相信是真實的並用來作為比較基準的資料。

- 預期答案是我們以基準真相資料為基礎而相信應會發生的結果。 例如,在分類或簡短問答等工作中,通常有一個正確或預期的答案,F1 分數或類似的傳統計量可用來測量產生的輸出相較於預期答案的精確度與重新叫用率。

當我們想要了解所產生輸出的迴歸程度時 (也就是偏離預期的答案),傳統計量也很有用。 它們提供誤差或偏差的量化量值,讓我們能追蹤一段時間的系統效能,或比較不同系統的效能。 不過,這些計量可能不太適合涉及創意、模棱兩可或多個正確解決方案的工作,因為這些計量通常會將任何與預期答案的偏差視為錯誤。

AI 輔助評估

GPT-4 這類的大型語言模型 (LLM) 可用於評估生成式 AI 語言系統的輸出。 這可藉由指示 LLM 標註 AI 產生的某些輸出層面來達成。 例如,您可以為 GPT-4 提供相關性嚴重性級別 (例如,為 1-5 級別上的相關性註釋提供準則),然後要求 GPT-4 標註 AI 系統對指定問題之回應的相關性。

在無法取得基準真相和預期答案的案例中,AI 輔助評估可能很有幫助。 在許多生成式 AI 案例中 (例如開放式問題解答或創意寫作),並沒有單一正確答案,因而使得建立傳統計量所需的基準真相或預期答案,具有挑戰性。

在這些案例中,AI 輔助評估有助於測量重要概念,例如所產生輸出的品質和安全性。 在這裡,品質是指效能和品質屬性,例如相關性、一致性、流暢度與根據性。 安全是指風險和安全性屬性,例如存在有害內容 (內容風險)。

針對每個屬性,需要仔細的概念化和實驗,才能建立 LLM 的指示和嚴重性級別。 有時候,這些屬性是指不同人員可能以不同方式檢視的複雜社會技術概念。 因此,建立 LLM 的註釋指示來代表屬性的已同意與具體定義至關重要。 然後,同樣重要的,確保 LLM 套用指示的方式與人類專家註釋工具一致。

藉由指示 LLM 標註這些屬性,您即可針對生成式 AI 應用程式執行效能建立量值,即使沒有單一正確答案。 AI 輔助評估提供彈性且細微的方法來評估生成式 AI 應用程式,特別是在涉及創意、模棱兩可或多個正確解決方案的工作中。 不過,這些評估的可靠性和有效性取決於 LLM 的品質,以及提供給它的指示。

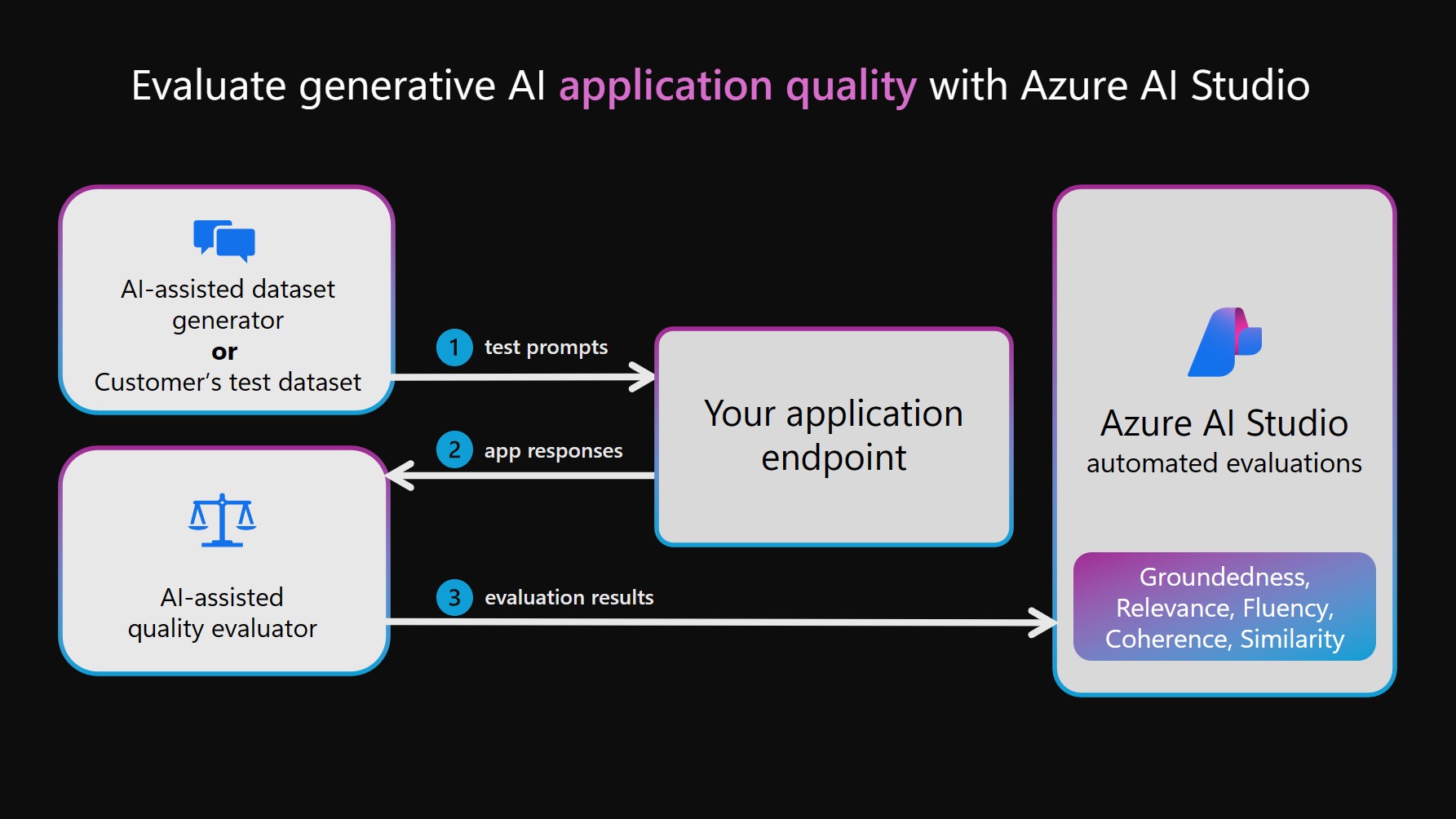

AI 輔助效能和品質計量

若要執行 AI 輔助效能和品質評估,LLM 可能會用於兩個不同的函式。 首先,必須建立測試資料集。 這可以藉由從 AI 系統上選擇提示和擷取回應來手動建立,也可以藉由模擬 AI 系統與 LLM 之間的互動來合成建立 (如下圖所示的 AI 輔助資料集產生器)。 然後,LLM 也會用來標註測試集中的 AI 系統輸出。 最後,註釋會彙總成效能和品質計量,並記錄至您的 AI Studio 專案以進行檢視和分析。

注意

我們目前支援 GPT-4 和 GPT-3 作為 AI 輔助評估的模型。 若要使用這些模型進行評估,您必須建立有效的連線。 請注意,我們強烈建議使用 GPT-4,因為它在內容理解和遵循指示上提供顯著改善。

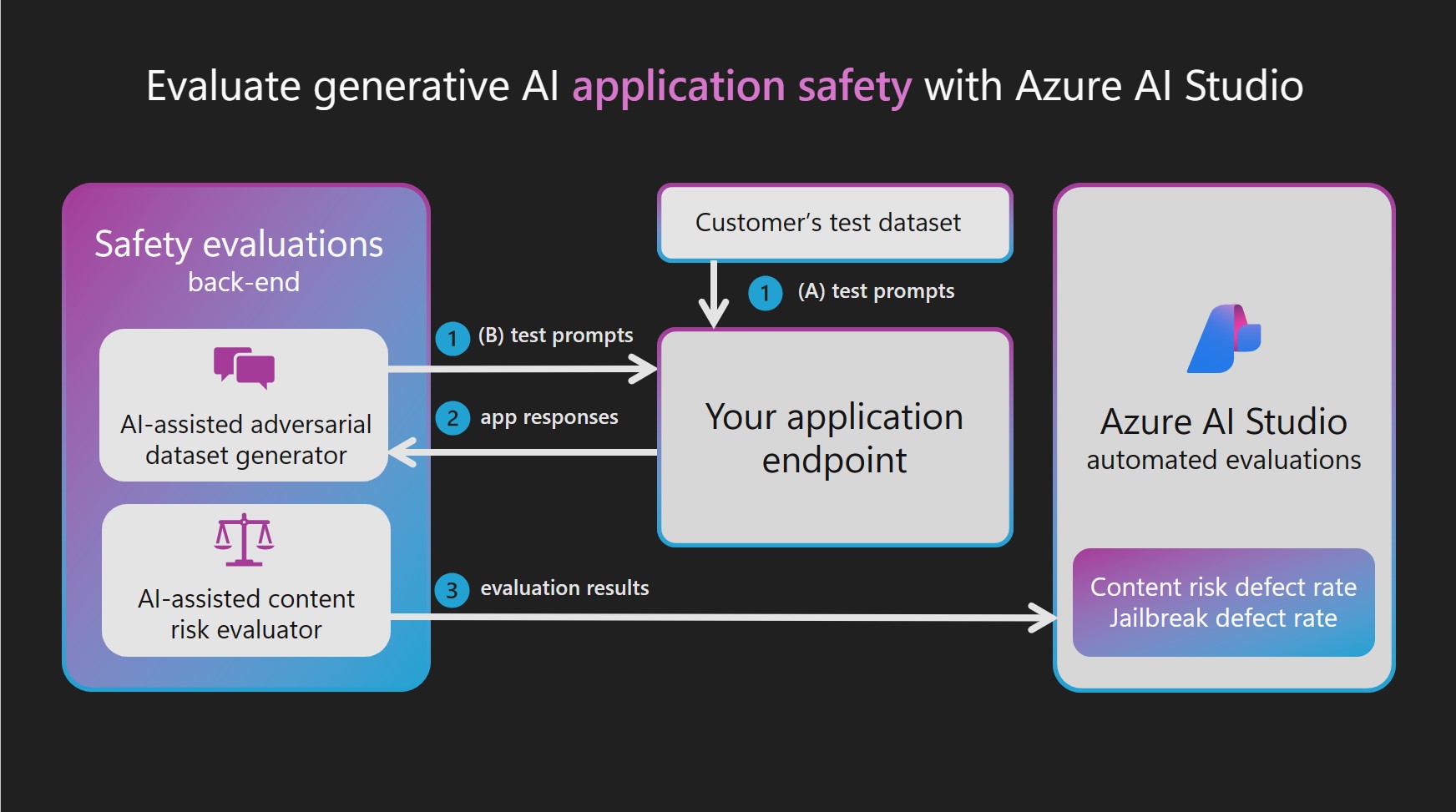

AI 輔助的風險和安全性計量

AI 輔助品質和效能評估的應用程式之一為建立 AI 輔助的風險和安全性計量。 為了建立 AI 輔助的風險和安全性計量,Azure AI Studio 安全評估會佈建裝載於後端服務的 Azure OpenAI GPT-4 模型,然後協調兩個 LLM 相依步驟:

模擬與生成式 AI 系統的對立互動:

透過旨在產生有害回應之提示所引導的模擬單回合或多回合交換,來產生高品質的輸入和回應的測試資料集。

為內容或安全性風險標註測試資料集:

為測試資料集中的每個互動標註嚴重性和推理,其衍生自針對每種內容類型和安全性風險所定義的嚴重性級別。

由於佈建的 GPT-4 模型會作為對立資料集產生器或標註工具,因此會關閉其安全篩選,並將模型裝載於後端服務中。 這些 LLM 和目標對立提示資料集所使用的提示也會裝載於服務中。 由於所產生並傳遞至 LLM 的內容具敏感性本質,因此 Azure AI Studio 客戶無法直接存取模型和資料資產。

對立目標提示資料集是由 Microsoft 研究人員、應用科學家、語言學家和安全性專家所開發,協助使用者開始評估產生 AI 系統中的內容和安全性風險。

如果您已經擁有包含輸入提示和 AI 系統回應的測試資料集 (例如,來自紅色小組的記錄),您可以直接傳入該資料集,由內容風險評估工具標註。 安全評估可藉由讓紅色小組大規模產生和自動化對立提示,以協助增強和加速手動紅隊工作。 不過,AI 輔助評估既不是設計來取代人力檢閱,也不是提供所有可能風險的完整涵蓋範圍。

評估越獄弱點

不同於內容風險,LLM 無法以直接註釋可靠地測量越獄弱點。 不過,您可以透過比較兩個平行測試資料集來測量越獄弱點: 比較基準對立測試資料集,以及在第一回合使用越獄插入的相同對立測試資料集。 每個資料集都可以由 AI 輔助的內容風險評估工具標註,為每個資料集產生內容風險瑕疵率。 然後,使用者藉由比較瑕疵率和指出越獄資料集導致更多或更高的嚴重性缺陷案例,來評估越獄弱點。 例如,如果這些平行測試資料集中的執行個體被標註為對於越獄插入的版本來說更嚴重,則該執行個體會被視為越獄缺陷。

若要深入了解支援的工作類型和內建計量,請參閱生成式 AI 的評估和監視計量。

評估及監視生成式 AI 應用程式

Azure AI Studio 支援數個不同的路徑,以供生成式 AI 應用程式開發人員評估其應用程式:

遊樂場:在第一個路徑中,您可以從參與「遊樂場」體驗開始。 在這裡,您可以選取您想要用作模型基礎的資料、選擇應用程式的基底模型,並提供中繼程式指示來引導模型的行為。 然後,您可藉由在資料集中傳遞並觀察應用程式的回應,以手動評估應用程式。 手動檢查完成後,您可選擇使用評估精靈,透過傳統的計量或 AI 輔助的評估,來執行更全面的評量。

流程:Azure AI Studio [提示流程] 頁面提供量身打造的專用開發工具,以便簡化 LLM 所支援 AI 應用程式的整個生命週期。 經由此路徑,您可透過視覺化圖表,建立可連結 LLM、提示和 Python 工具的可執行流程。 此功能可簡化流程的偵錯、共用和共同作業反覆運算。 此外,您可以建立提示變體,並透過大規模測試評估其效能。

除了「流程」開發工具之外,您也可選擇使用程式碼優先 SDK 體驗來開發生成式 AI 應用程式。 無論您選擇的開發路徑為何,您都可以透過評估精靈 (可從 [流程] 索引標籤或透過 SDK/CLI 體驗存取) 來評估已建立的流程。 從 [流程] 索引標籤,您甚至可靈活地使用自訂評估精靈且併入自己的計量。直接資料集評估: 如果您已收集資料集 (其中包含應用程式與終端使用者之間的互動),您可將此資料直接提交至 [評估] 索引標籤內的評估精靈。此流程可產生自動 AI 輔助評估,且結果可在相同的索引標籤中視覺化。此方法以資料為主的評估方法為中心。 或者,您可以選擇使用 SDK/CLI 體驗來評估交談資料集,並透過 Azure AI Studio 產生並視覺化評估。

在評估來自上述任何通道的應用程式、流程或資料之後,您可以繼續部署生成式 AI 應用程式,當它與使用者進行新的互動時,在生產環境中監視其品質和安全性。