Azure AI Studio 中的模型目錄和集合

重要

本文中標示為 (預覽) 的項目目前處於公開預覽狀態。 此預覽版本沒有服務等級協定,不建議將其用於生產工作負載。 可能不支援特定功能,或可能已經限制功能。 如需詳細資訊,請參閱 Microsoft Azure 預覽版增補使用條款。

Azure AI Studio 中的模型目錄是用於探索和使用各種模型,以便建置生成式 AI 應用程式的中樞。 模型目錄提供來自 Azure OpenAI 服務、Mistral、Meta、Cohere、NVIDIA、Hugging Face 等模型提供者的數百個模型,包括由 Microsoft 定型的模型。 來自 Microsoft 以外提供者的模型是非 Microsoft 產品,如 Microsoft 的產品條款所定義,並受模型提供的條款規範。

模型集合

模型目錄會將模型組織成三個集合:

由 Azure AI 策展:最熱門的非 Microsoft 開放式加權和專利模型,已經過封裝和最佳化,可在 Azure AI 平台上順暢地運作。 這些模型的使用受模型提供者的授權條款規範。 在 Azure AI Studio 中部署這些模型時,其可用性受適用的 Azure 服務等級協定 (SLA) 規範,Microsoft 會為部署問題提供支援。

來自 Meta、NVIDIA 和 Mistral AI 等合作夥伴的模型即為目錄中集合中可用模型的範例。 可以透過查看目錄中模型磚上的綠色勾選記號來識別這些模型。 或者,可以依由 Azure AI 策展集合進行篩選。

Azure 上獨家提供的 Azure OpenAI 模型:透過與 Azure OpenAI 服務整合提供的 Azure OpenAI 旗艦模型。 Microsoft 會為這些模型提供支援,其使用受產品條款和 Azure OpenAI 服務的 SLA規範。

來自 Hugging Face 中樞的開放式模型:來自 Hugging Face 中樞的數百個模型,用於在受控計算中進行即時推斷。 此集合中列出的模型由 Hugging Face 建立並維護。 如需協助,請使用 Hugging Face 論壇或 Hugging Face 支援。 深入了解如何使用 Azure AI Studio 部署開放式模型。

您可以使用此表單來要求將模型新增至模型目錄。

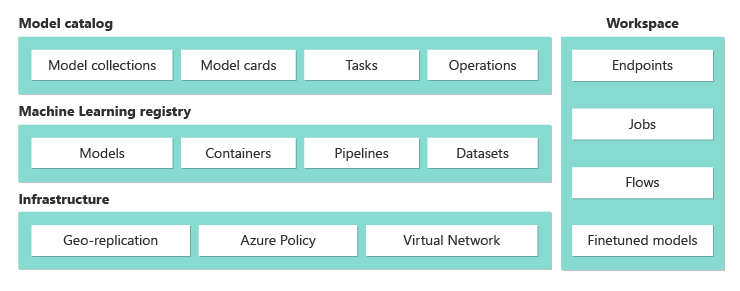

模型目錄功能的概觀

您可以使用受控計算選項部署由 Azure AI 策展和來自 Hugging Face 中樞的開放式模型集合中的一些模型。 某些模型可透過無伺服器 API 部署,採用隨用隨付計費模式。

您可以探索、比較、評估、微調 (如果支援) 並大規模部署這些模型。 然後,可以將模型整合到提供企業級安全性和資料控管的生成式 AI 應用程式中。 下列清單詳細說明了這些活動:

- 探索:檢閱模型卡片、嘗試範例推斷及瀏覽程式碼範例,以評估、微調或部署模型。

- 比較:比較產業中可用模型和資料集的基準,以評估哪一個符合您的商務案例。

- 評估:提供自己的測試資料,評估模型是否適合您的特定工作負載。 使用評估計量,來視覺化所選模型在案例中的表現。

- 微調:使用自己的定型資料來自訂可微調的模型,並透過比較所有微調作業的計量來選擇最佳模型。 內建最佳化可以加速微調,並減少所需的記憶體和計算的資源。

- 部署: 順暢地部署預先定型的模型或經過微調的模型以進行推斷。 您也可以下載可部署到受控計算的模型。

如需 Azure OpenAI 模型的詳細資訊,請參閱什麼是 Azure OpenAI 服務?。

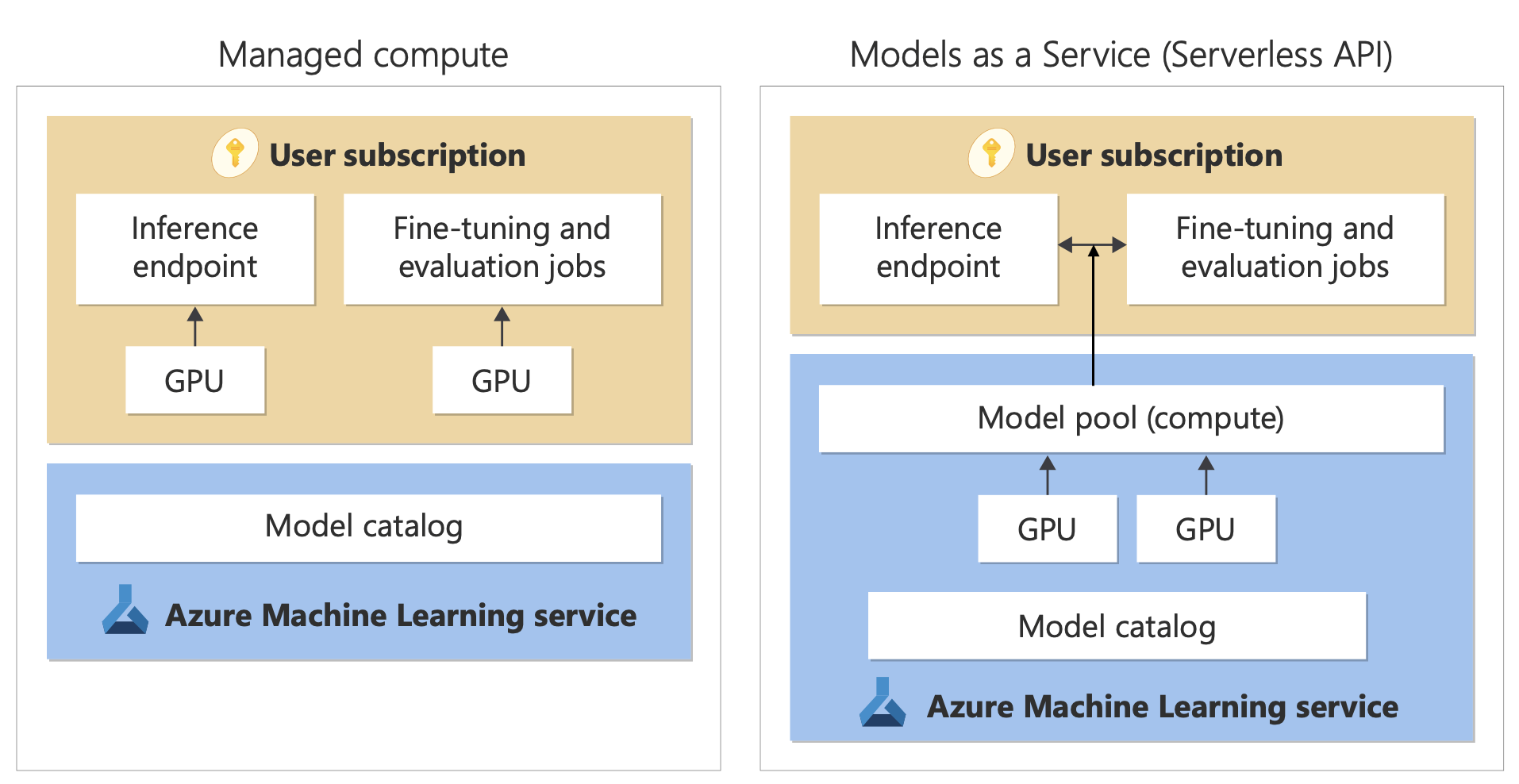

模型部署:受控計算和無伺服器 API (隨用隨付)

模型目錄提供了兩種不同的方法來部署模型以供使用:受控計算和無伺服器 API。

每個模型的可用部署選項和功能會有所不同,如下表所述。 深入了解部署選項的資料處理。

模型部署選項的功能

| 功能 | 受控計算 | 無伺服器 API (隨用隨付) |

|---|---|---|

| 部署體驗和計費 | 模型權數會部署到具有受控計算的專用虛擬機器。 受控計算 (可以有一或多個部署) 會提供 REST API 以進行推斷。 將根據部署所使用的虛擬機器核心時數計費。 | 透過部署存取模型,這會佈建一個 API 來存取模型。 使用該 API 可以存取 Microsoft 裝載和管理的模型,以進行推斷。 您需要為 API 的輸入和輸出 (通常為權杖形式) 付費。 在部署之前會提供定價資訊。 |

| API 驗證 | 金鑰和 Microsoft Entra 驗證。 | 僅限金鑰。 |

| 內容安全性 | 使用 Azure AI 內容安全服務 API。 | 提供與推斷 API 整合的 Azure AI 內容安全篩選。 Azure AI 內容安全篩選可能會分開計費。 |

| 網路隔離 | 設定 Azure AI Studio 中樞的受控網路。 | 受控計算會遵循中樞的公用網路存取 (PNA) 旗標設定。 如需詳細資訊,請參閱本文稍後的透過無伺服器 API 所部署模型的網路隔離一節。 |

支援部署選項的可用模型

| Model | 受控計算 | 無伺服器 API (隨用隨付) |

|---|---|---|

| Llama 系列模型 | Llama-2-7b Llama-2-7b-chat Llama-2-13b Llama-2-13b-chat Llama-2-70b Llama-2-70b-chat Llama-3-8B-Instruct Llama-3-70B-Instruct Llama-3-8B Llama-3-70B |

Llama-3-70B-Instruct Llama-3-8B-Instruct Llama-2-7b Llama-2-7b-chat Llama-2-13b Llama-2-13b-chat Llama-2-70b Llama-2-70b-chat |

| Mistral 系列模型 | mistralai-Mixtral-8x22B-v0-1 mistralai-Mixtral-8x22B-Instruct-v0-1 mistral-community-Mixtral-8x22B-v0-1 mistralai-Mixtral-8x7B-v01 mistralai-Mistral-7B-Instruct-v0-2 mistralai-Mistral-7B-v01 mistralai-Mixtral-8x7B-Instruct-v01 mistralai-Mistral-7B-Instruct-v01 |

Mistral-large (2402) Mistral-large (2407) Mistral-small Mistral-NeMo |

| Cohere 系列模型 | 無法使用 | Cohere-command-r-plus-08-2024 Cohere-command-r-08-2024 Cohere-command-r-plus Cohere-command-r Cohere-embed-v3-english Cohere-embed-v3-多語系版 Cohere-rerank-v3-english Cohere-rerank-v3-multilingual |

| JAIS | 無法使用 | jais-30b-chat |

| 醫療保健 AI 系列模型 | MedImageInsight CxrReportGen MedImageParse |

無法使用 |

| Phi-3 系列模型 | Phi-3-mini-4k-Instruct Phi-3-mini-128k-Instruct Phi-3-small-8k-Instruct Phi-3-small-128k-Instruct Phi-3-medium-4k-instruct Phi-3-medium-128k-instruct Phi-3-vision-128k-Instruct Phi-3.5-mini-Instruct Phi-3.5-vision-Instruct Phi-3.5-MoE-Instruct |

Phi-3-mini-4k-Instruct Phi-3-mini-128k-Instruct Phi-3-small-8k-Instruct Phi-3-small-128k-Instruct Phi-3-medium-4k-instruct Phi-3-medium-128k-instruct Phi-3.5-mini-Instruct Phi-3.5-vision-Instruct Phi-3.5-MoE-Instruct |

| Nixtla | 無法使用 | TimeGEN-1 |

| 其他模型 | 可以使用 | 無法使用 |

受控計算

以受控計算形式部署模型的功能會建置在 Azure Machine Learning 的平台功能上,以在大型語言模型 (LLM) 作業的整個生命週期中順暢地整合模型目錄中的各種模型集合。

可部署為受控計算的模型的可用性

這些模型可透過 Azure Machine Learning 登錄提供。 這些登錄允許啟用機器學習優先方法來裝載和散發 Azure Machine Learning 資產。 這些資產包括模型權重、用於執行模型的容器執行階段、用於評估和微調模型的管線,以及基準和範例的資料集。

這些登錄建置在可高度調整並符合企業需求的基礎結構之上,以便:

透過內建異地複寫,將低延遲存取模型成品傳遞至所有 Azure 區域。

支援企業安全性需求,例如使用 Azure 原則限制對模型的存取,以及使用受控虛擬網路保護部署。

使用受控計算來部署模型以進行推斷

可用於部署至受控計算的模型可以部署至 Azure Machine Learning 受控計算以進行即時推斷。 部署到受控計算時,需要在 Azure 訂閱中為特定產品提供虛擬機器配額,以便能夠以最佳方式執行模型。 某些模型可讓您部署到暫時共用的配額以進行模型測試。

深入了解如何部署下列模型:

使用受控計算來建置生成式 AI 應用程式

Azure Machine Learning 中的提示流程功能為原型設計提供了絕佳的體驗。 您可以使用提示流程中已部署受控計算的模型,搭配開放式模型 LLM 工具。 您也可以使用 LangChain 等熱門 LLM 工具中受控計算所公開的 REST API,搭配 Azure Machine Learning 延伸模組。

部署為受控計算之模型的內容安全

Azure AI 內容安全服務可與受控計算搭配使用,以篩選各種有害內容的類別,例如色情內容、暴力、仇恨和自殘。 您也可以使用服務來篩選進階威脅,例如越獄風險偵測和受保護材料的文字偵測。

您可以參考此筆記本來了解與適用於 Llama 2 的 Azure AI 內容安全的整合。 或者,可以在提示流程中使用內容安全 (文字) 工具,將模型的回應傳遞至 Azure AI 內容安全以進行篩選。 如 Azure AI 內容安全定價中所述,您需要為這類用法單獨付費。

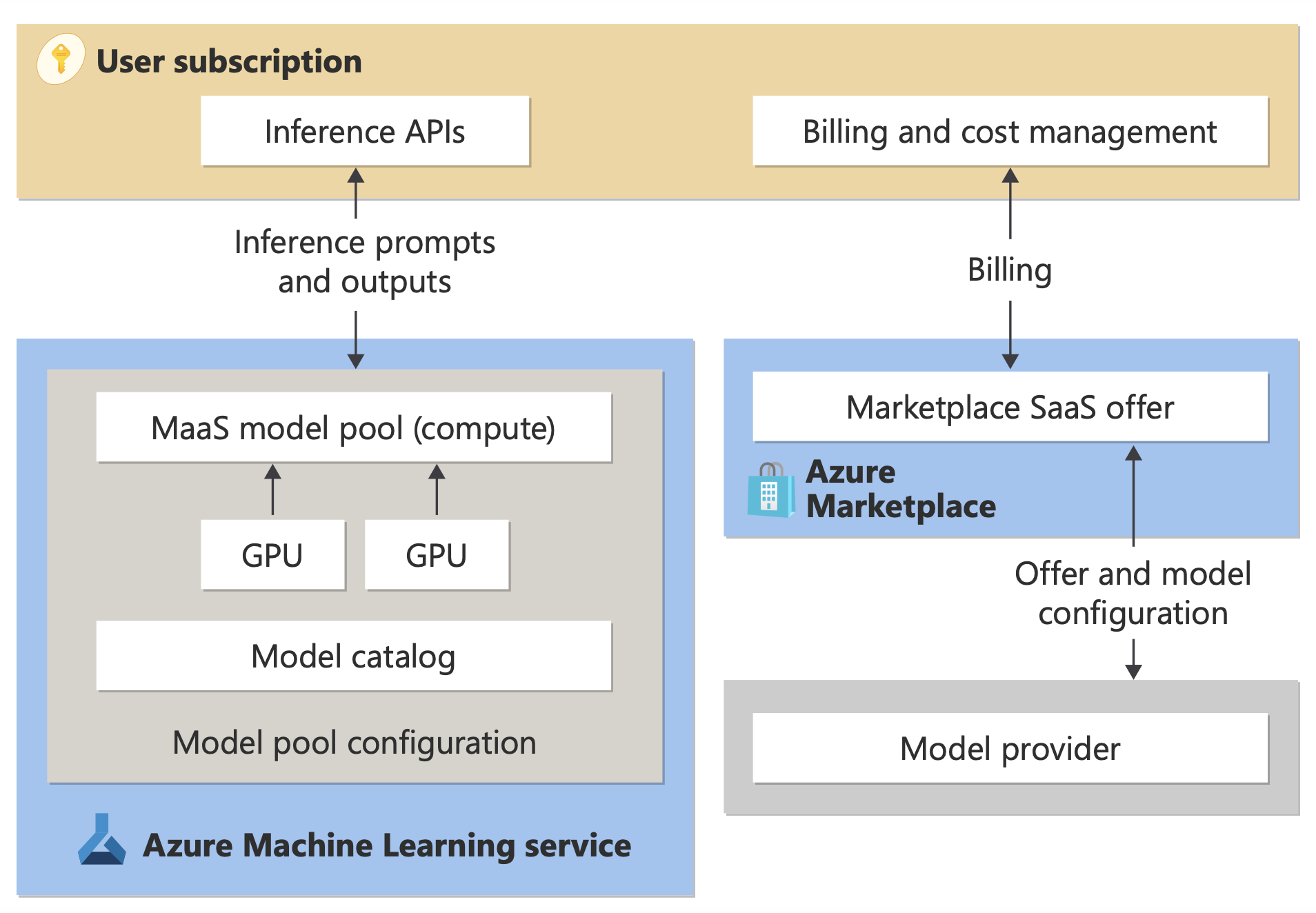

搭配隨用隨付計費的無伺服器 API

您可以使用隨用隨付計費,將模型目錄中的特定模型部署為無伺服器 API。 這種部署方法有時稱為模型即服務 (MaaS),它可以 API 的形式取用模型,而不須在您的訂用帳戶上裝載模型。 模型會裝載於 Microsoft 管理的基礎結構中,以便對模型提供者的模型進行 API 型存取。 API 型存取可大幅降低存取模型的成本,並簡化佈建體驗。

模型提供者會提供可部署為採用隨用隨付計費的無伺服器 API 模型,但這些模型裝載於受 Microsoft 管理的 Azure 基礎結構中,並透過 API 存取。 模型提供者會為其模型定義授權條款並設定使用的價格。 Azure Machine Learning 服務:

- 管理裝載基礎結構。

- 提供推斷 API。

- 做為資料處理器,用於處理透過 MaaS 部署的模型所提交提示和輸出的內容。

在有關資料隱私一文中深入了解 MaaS 的資料處理。

計費

透過 MaaS 部署之模型的探索、訂閱和取用體驗位於 Azure AI Studio 和 Azure Machine Learning 工作室中。 使用者接受使用模型時所要遵守的授權條款。 在部署期間會提供取用定價資訊。

非 Microsoft 提供者所提供的模型會根據 Microsoft 商業市集使用條款,透過 Azure Marketplace 計費。

Microsoft 提供的模型會作為第一方取用服務透過 Azure 計量計費。 如產品條款所述,可以使用 Azure 計量購買第一方取用服務,但不受 Azure 服務條款的約束。 使用這些模型必須遵守提供的授權條款。

微調模型

某些模型也支援無伺服器微調。 對於這些模型,您可以使用託管微調功能和隨用隨付計費,使用您提供的資料來量身打造模型。 如需詳細資訊,請參閱微調概觀。

部署為無伺服器 API 之模型的 RAG

在 Azure AI Studio 中,可以使用向量索引和擷取擴增生成 (RAG)。 您可以使用可透過無伺服器 API 部署的模型,根據自訂資料產生內嵌和推斷。 然後,這些內嵌和推斷可以產生所使用案例專屬的解答。 如需詳細資訊,請參閱在 Azure AI Studio 中建置和取用向量索引。

供應項目和模型的區域可用性

只有在使用者的 Azure 訂用帳戶屬於模型提供者已提供該產品/服務的國家/地區的某個計費帳戶時,才能使用隨用隨付計費。 如果該產品/服務在相關區域中提供,則使用者必須在可供部署或微調該模型 (如果適用) 的 Azure 區域中,擁有一個中樞/專案。 如需詳細資訊,請參閱無伺服器 API 端點 | Azure AI Studio 中模型的區域可用性。

透過無伺服器 API 所部署模型的內容安全

針對透過無伺服器 API 所部署的語言模型,Azure AI 會實作 Azure AI 內容安全文字調節篩選的預設設定,而文字調節篩選可偵測仇恨、自殘、性與暴力這類有害內容。 若要深入了解內容篩選 (預覽版),請參閱 Azure AI 內容安全中的有害類別。

提示

內容篩選 (預覽) 不適用於透過無伺服器 API 所部署的特定模型類型。 這些模型類型包括內嵌模型和時間序列模型。

當服務處理提示產生內容時,內容篩選 (預覽版) 會同步發生。 您可以根據 Azure AI 內容安全價格個別計費,以供此類使用。 您可以在以下時機停用個別無伺服器端點的內容篩選 (預覽版):

- 第一次部署語言模型時

- 稍後設定,透過選取部署詳細資料頁面上的內容篩選切換開關

假設您決定使用 Azure AI 模型推斷 API 以外的 API 來處理透過無伺服器 API 所部署的模型。 在這種情況下,除非您使用 Azure AI 內容安全個別實作內容篩選 (預覽版),否則不會啟用內容篩選。

若要開始使用 Azure AI 內容安全,請參閱快速入門:分析文字內容。 如果您在使用透過無伺服器 API 所部署的模型時未使用內容篩選 (預覽),則有較高風險讓使用者暴露在有害內容中。

透過無伺服器 API 所部署模型的網路隔離

部署為無伺服器 API 之模型的受控計算會遵循具有部署所在專案的 AI Studio 中樞公用網路存取旗標設定。 若要協助保護您的受控計算,請在 AI Studio 中樞上停用公用網路存取旗標。 您可以協助使用中樞的私人端點,保護從用戶端到受控計算的輸入通訊。

若要設定 AI Studio 中樞的公用網路存取旗標:

- 前往 Azure 入口網站。

- 搜尋中樞所屬的資源群組,然後從此資源群組所列的資源中選取您的 AI Studio 中樞。

- 在中樞概觀頁面上的左窗格中,移至 [設定]>[網路]。

- 在 [公用存取] 索引標籤上,您可以設定公用網路存取旗標的設定。

- 儲存您的變更。 您的變更最多可能需要五分鐘才能散佈。

限制

如果您的 AI Studio 中樞具有 2024 年 7 月 11 日之前所建立的受控計算,則新增至此中樞內專案的受控計算將不會遵循中樞的網路設定。 相反地,您需要為中樞建立新的受控計算,並在專案中建立新的無伺服器 API 部署,讓新的部署可以遵循中樞的網路設定。

如果您的 AI Studio 中樞具有 2024 年 7 月 11 日之前所建立的 MaaS 部署,並且您在此中樞上啟用受控計算,則現有的 MaaS 部署即不會遵循中樞的網路設定。 若要讓中樞內的無伺服器 API 部署遵循中樞的網路設定,您需要再次建立部署。

目前,基於自有資料的 Azure OpenAI 支援不適用於私人中樞內的 MaaS 部署,因為私人中樞已停用公用網路存取旗標。

任何網路設定變更 (例如,啟用或停用公用網路存取旗標) 最多可能需要五分鐘的時間才能散佈。