Co je zodpovědná AI?

PLATÍ PRO: Rozšíření Azure CLI ml v2 (aktuální)

Rozšíření Azure CLI ml v2 (aktuální) Python SDK azure-ai-ml v2 (aktuální)

Python SDK azure-ai-ml v2 (aktuální)

Zodpovědná umělá inteligence (zodpovědná umělá inteligence) je přístup k vývoji, hodnocení a nasazování systémů AI bezpečným, důvěryhodným a etickým způsobem. Systémy AI jsou produktem mnoha rozhodnutí, která učinili ti, kteří je vyvíjejí a nasazují. Od systémového účelu až po způsob, jakým lidé pracují se systémy AI, může zodpovědná AI aktivně řídit tato rozhodnutí směrem k užitečnějším a spravedlivým výsledkům. To znamená, že lidé a jejich cíle jsou v centru rozhodování o návrhu systému a respektují trvalé hodnoty, jako je nestrannost, spolehlivost a transparentnost.

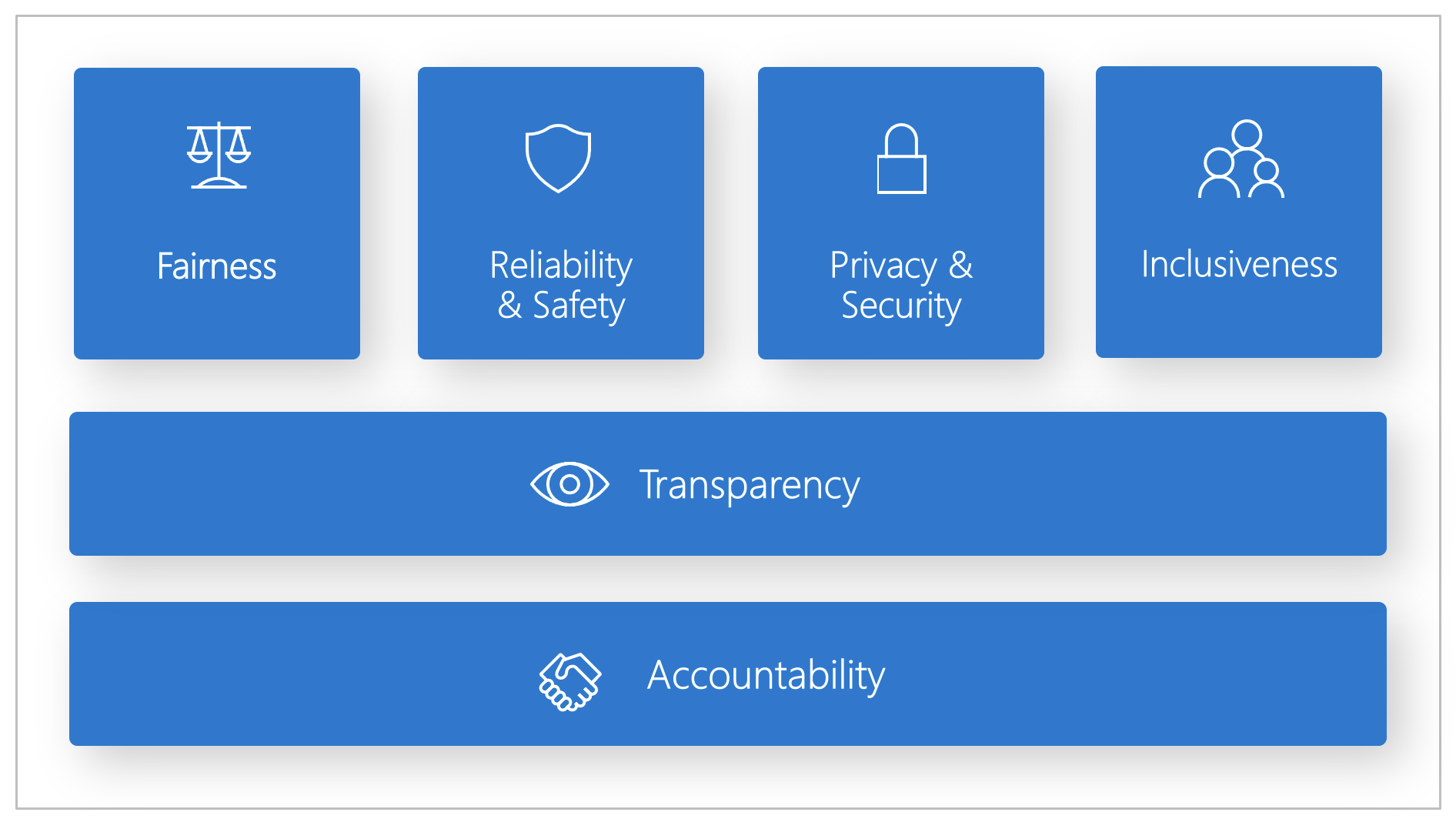

Microsoft vyvinul zodpovědný standard AI. Je to rámec pro vytváření systémů AI podle šesti principů: nestrannost, spolehlivost a bezpečnost, ochrana osobních údajů a zabezpečení, inkluzivnost, transparentnost a odpovědnost. Pro Microsoft jsou tyto principy základním kamenem zodpovědného a důvěryhodného přístupu k umělé inteligenci, a to zejména v případě, že u produktů a služeb, které lidé každý den používají, převládají inteligentní technologie.

Tento článek ukazuje, jak Azure Machine Learning podporuje nástroje, které vývojářům a datovým vědcům umožňují implementovat a zprovoznit šest principů.

Nestrannost a inkluzivnost

Systémy AI by měly zacházet se všemi spravedlivými způsoby a vyhnout se ovlivnění podobně umístěných skupin lidí různými způsoby. Pokud například systémy AI poskytují pokyny k lékařské léčbě, žádostem o půjčku nebo zaměstnání, měly by stejná doporučení poskytovat všem, kteří mají podobné příznaky, finanční okolnosti nebo odborné kvalifikace.

Nestrannost a inkluzivnost ve službě Azure Machine Learning: Komponenta posouzení nestrannosti řídicího panelu Zodpovědné umělé inteligence umožňuje datovým vědcům a vývojářům vyhodnotit model nestrannosti mezi citlivými skupinami definovanými z hlediska pohlaví, etnického původu, věku a dalších charakteristik.

Spolehlivost a zabezpečení

Pro budování důvěryhodnosti je důležité, aby systémy AI spolehlivě, bezpečně a konzistentně fungovaly. Tyto systémy by měly být schopné fungovat tak, jak byly původně navrženy, reagovat bezpečně na neočekávané podmínky a odolat škodlivé manipulaci. Chování a různé podmínky, které můžou zpracovat, odráží celou řadu situací a okolností, které vývojáři očekávali během návrhu a testování.

Spolehlivost a bezpečnost ve službě Azure Machine Learning: Komponenta analýzy chyb na řídicím panelu Zodpovědné umělé inteligence umožňuje datovým vědcům a vývojářům:

- Získejte podrobné informace o tom, jak se pro model distribuuje selhání.

- Identifikujte kohorty (podmnožinu) dat s vyšší chybovostí než celkový srovnávací test.

K těmto nesrovnalostem může dojít v případě, že systém nebo model nedodržuje určité demografické skupiny nebo zřídka pozorované vstupní podmínky v trénovacích datech.

Transparency

Když systémy AI pomáhají informovat rozhodnutí, která mají obrovský dopad na životy lidí, je důležité, aby lidé pochopili, jak se tato rozhodnutí udělala. Například banka může použít systém AI k rozhodnutí, zda je osoba úvěrová. Společnost může použít systém AI k určení nejpohodnějších kandidátů, kteří si můžou najmout.

Klíčovou součástí transparentnosti je interpretovatelnost: užitečné vysvětlení chování systémů AI a jejich součástí. Zlepšení interpretovatelnosti vyžaduje, aby zúčastněné strany porozuměly tomu, jak a proč systémy AI fungují tak, jak fungují. Účastníci pak můžou identifikovat potenciální problémy s výkonem, problémy s nestranností, postupy vyloučení nebo nezamýšlené výsledky.

Transparentnost ve službě Azure Machine Learning: Interpretovatelnost modelu a kontrafaktuální komponenty řídicího panelu Zodpovědné umělé inteligence umožňují odborníkům na data a vývojářům generovat srozumitelný popis predikcí modelu.

Komponenta interpretovatelnosti modelu poskytuje více zobrazení chování modelu:

- Globální vysvětlení. Jaké funkce mají například vliv na celkové chování modelu alokace půjčky?

- Místní vysvětlení. Proč byla například žádost o půjčku zákazníka schválena nebo odmítnuta?

- Vysvětlení modelu pro vybranou kohortu datových bodů Jaké funkce mají například vliv na celkové chování modelu přidělování úvěrů pro žadatele s nízkým příjmem?

Kontrafaktuální komponenta citlivostní citlivosti umožňuje pochopit a ladit model strojového učení z hlediska toho, jak reaguje na změny funkcí a perturbace.

Azure Machine Learning také podporuje přehled výkonnostních metrik zodpovědné umělé inteligence. Přehled výkonnostních metrik je přizpůsobitelná sestava PDF, kterou můžou vývojáři snadno konfigurovat, generovat, stahovat a sdílet se svými technickými a netechnickými účastníky a informovat je o stavu datových sad a modelů, dosáhnout dodržování předpisů a vybudovat důvěru. Tento přehled výkonnostních metrik lze také použít v kontrolách auditu k odhalení charakteristik modelů strojového učení.

Ochrana osobních údajů a zabezpečení

S tím, jak se AI stává častější, je ochrana osobních údajů a zabezpečení osobních a obchodních informací stále důležitější a složitější. Díky umělé inteligenci vyžadují ochranu osobních údajů a zabezpečení dat úzkou pozornost, protože přístup k datům je nezbytný pro systémy AI, aby mohli provádět přesné a informované předpovědi a rozhodnutí o lidech. Systémy AI musí dodržovat zákony o ochraně osobních údajů, které:

- Vyžadovat transparentnost shromažďování, používání a ukládání dat.

- Požádejte spotřebitele, aby měli odpovídající kontrolní mechanismy k volbě způsobu jejich použití dat.

Ochrana osobních údajů a zabezpečení ve službě Azure Machine Learning: Azure Machine Learning umožňuje správcům a vývojářům vytvořit zabezpečenou konfiguraci, která vyhovuje zásadám jejich společností. S Azure Machine Learning a platformou Azure můžou uživatelé:

- Omezte přístup k prostředkům a operacím podle uživatelského účtu nebo skupiny.

- Omezte příchozí a odchozí síťovou komunikaci.

- Šifrování přenášených a neaktivních uložených dat

- Vyhledejte ohrožení zabezpečení.

- Použijte a auditujte zásady konfigurace.

Společnost Microsoft také vytvořila dva opensourcové balíčky, které můžou umožnit další implementaci principů ochrany osobních údajů a zabezpečení:

SmartNoise: Rozdílová ochrana osobních údajů je sada systémů a postupů, které pomáhají udržovat data jednotlivců v bezpečí a soukromí. V řešeních strojového učení může být pro dodržování právních předpisů vyžadována rozdílová ochrana osobních údajů. SmartNoise je opensourcový projekt (společně vyvinutý Microsoftem), který obsahuje komponenty pro vytváření rozdílových privátních systémů, které jsou globální.

Counterfit: Counterfit je opensourcový projekt, který se skládá z nástroje příkazového řádku a obecné automatizační vrstvy, která vývojářům umožňuje simulovat kybernetické útoky na systémy AI. Nástroj si může stáhnout kdokoli a nasadit ho přes Azure Cloud Shell a spustit ho v prohlížeči nebo ho nasadit místně v prostředí Anaconda Python. Může vyhodnotit modely AI hostované v různých cloudových prostředích, místně nebo na hraničních zařízeních. Nástroj je nezávislý na modelech AI a podporuje různé datové typy, včetně textu, obrázků nebo obecného vstupu.

Odpovědnost

Lidé, kteří navrhují a nasazují systémy AI, musí být zodpovědní za fungování jejich systémů. Organizace by měly vycházet z oborových standardů pro vývoj norem odpovědnosti. Tyto normy mohou zajistit, aby systémy AI nejsou konečným orgánem k žádnému rozhodnutí, které ovlivňuje životy lidí. Mohou také zajistit, aby lidé udržovali smysluplnou kontrolu nad jinak vysoce autonomními systémy AI.

Odpovědnost ve službě Azure Machine Learning: Operace strojového učení (MLOps) jsou založené na principech a postupech DevOps, které zvyšují efektivitu pracovních postupů AI. Azure Machine Learning poskytuje následující funkce MLOps pro lepší odpovědnost vašich systémů AI:

- Zaregistrujte, zabalte a nasaďte modely odkudkoli. Můžete také sledovat přidružená metadata, která jsou potřebná k použití modelu.

- Zachyťte data zásad správného řízení pro kompletní životní cyklus strojového učení. Protokolované informace rodokmenu můžou zahrnovat, kdo publikuje modely, proč byly provedeny změny a kdy byly modely nasazeny nebo použity v produkčním prostředí.

- Upozorněte a upozorněte na události v životním cyklu strojového učení. Mezi příklady patří dokončování experimentů, registrace modelu, nasazení modelu a detekce odchylek dat.

- Monitorování provozních problémů a problémů souvisejících s strojovém učením Porovnejte vstupy modelu mezi trénováním a odvozováním, prozkoumejte metriky specifické pro model a poskytněte monitorování a výstrahy ve vaší infrastruktuře strojového učení.

Kromě možností MLOps vytváří přehled výkonnostních metrik zodpovědné umělé inteligence ve službě Azure Machine Learning odpovědnost tím, že umožňuje komunikaci mezi zúčastněnými stranami. Přehled výkonnostních metrik také vytváří odpovědnost tím, že vývojářům umožňuje konfigurovat, stahovat a sdílet přehledy o stavu modelu se svými technickými a netechnickými účastníky o stavu dat a modelů AI. Sdílení těchto přehledů může pomoct vytvořit důvěryhodnost.

Platforma strojového učení také umožňuje rozhodování tím, že informuje obchodní rozhodnutí prostřednictvím:

- Přehledy řízené daty, které zúčastněným stranám pomůžou pochopit kauzální účinky na léčbu výsledku pouze pomocí historických dat. Například "Jak by lék ovlivnil krevní tlak pacienta?" Tyto přehledy jsou poskytovány prostřednictvím kauzální odvozování komponenty řídicího panelu Zodpovědné umělé inteligence.

- Modelem řízené přehledy pro odpovědi na otázky uživatelů (například "Co můžu udělat, když příště získám jiný výsledek než umělá inteligence?"), aby mohli provést akci. Tyto přehledy se poskytují datovým vědcům prostřednictvím kontrafaktuální komponenty citlivostní analýzy řídicího panelu Zodpovědné umělé inteligence.

Další kroky

- Další informace o implementaci zodpovědné umělé inteligence ve službě Azure Machine Learning najdete na řídicím panelu Zodpovědné AI.

- Zjistěte, jak vygenerovat řídicí panel zodpovědné umělé inteligence prostřednictvím rozhraní příkazového řádku a sady SDK nebo studio Azure Machine Learning uživatelského rozhraní.

- Zjistěte, jak vygenerovat přehled výkonnostních metrik Zodpovědné AI na základě přehledů zjištěných na řídicím panelu Zodpovědné AI.

- Přečtěte si o zodpovědném standardu AI pro vytváření systémů AI podle šesti klíčových principů.