Esercizio - Integrare Visione personalizzata di Azure

In questo modulo verrà illustrato come usare Visione personalizzata di Azure. Verrà preso un set di foto di un oggetto tracciato, si caricheranno le foto nel servizio Visione personalizzata e si avvierà il processo di training. Si userà quindi il servizio per rilevare l'oggetto tracciato acquisendo le foto dal feed webcam.

Informazioni sui Visione personalizzata di intelligenza artificiale di Azure

Azure AI Visione personalizzata fa parte della famiglia servizi cognitivi e viene usato per eseguire il training dei classificatori di immagini. Il classificatore di immagini è un servizio di intelligenza artificiale che usa il modello con training per applicare tag corrispondenti. L'applicazione userà questa funzionalità di classificazione per rilevare gli oggetti tracciati.

Altre informazioni sulle Visione personalizzata.

Preparare Visione personalizzata

Prima di iniziare, è necessario creare un progetto Visione personalizzata. Il modo più rapido per creare il progetto di Visione personalizzata consiste nell'usare il portale di Visione personalizzata.

Seguire questa esercitazione di avvio rapido per configurare l'account e il progetto. Seguire i passaggi fino alla sezione Caricare e aggiungere tag alle immagini. È consigliabile creare un tag con cinque immagini.

Avviso

Per eseguire il training di un modello, è necessario disporre di almeno due tag e cinque immagini per ogni tag. Successivamente, verranno aggiunte altre immagini tramite l'applicazione. Tuttavia, per usare questa applicazione, è necessario creare almeno un tag con cinque immagini in modo che il processo di training non avrà esito negativo in un secondo momento.

Preparare la scena

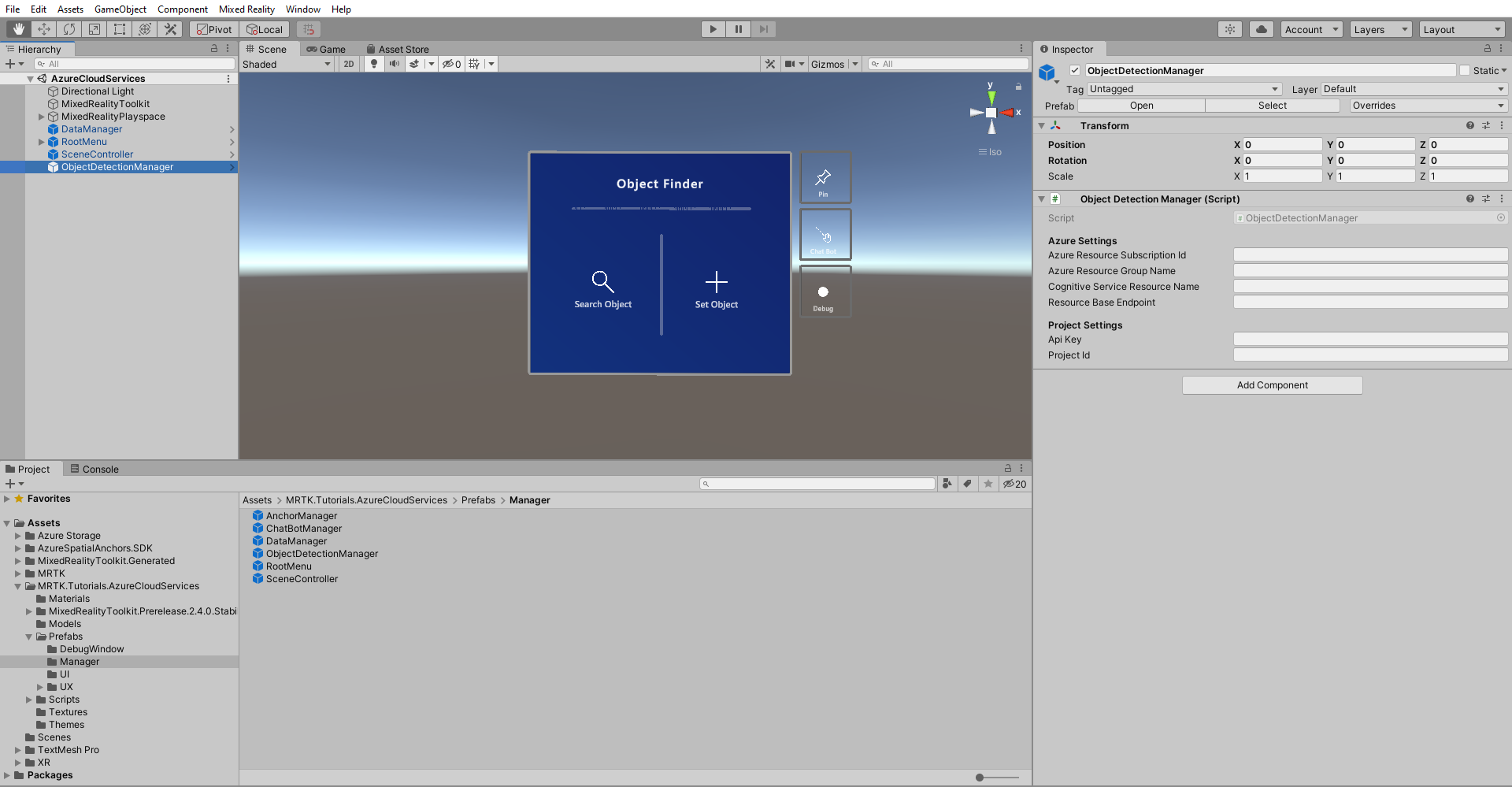

Nella finestra Project (Progetto) passare alla cartella Assets (Asset) >MRTK.Tutorials.AzureCloudServices>Prefabs (Prefab) >Manager.

Da qui trascinare il prefab ObjectDetectionManager nella gerarchia della scena.

Nella finestra Hierarchy (Gerarchia) individuare e selezionare l'oggetto ObjectDetectionManager . Il prefab ObjectDetectionManager contiene il componente ObjectDetectionManager (script) e, come si può vedere dalla finestra Inspector, dipende dalle impostazioni di Azure e dalle impostazioni del progetto.

Recuperare le credenziali della risorse API di Azure

È possibile recuperare le credenziali necessarie per le impostazioni objectDetectionManager (script) dal portale di Azure e dal portale di Visione personalizzata.

Recuperare le credenziali delle impostazioni di Azure

Trovare e individuare la risorsa Visione personalizzata del tipo di Servizi cognitivi creato nella sezione Preparazione della scena di questa esercitazione. Fare quindi clic su Panoramica o Chiavi ed endpoint per recuperare le credenziali necessarie.

- ID sottoscrizione risorsa di Azure: usare l'ID sottoscrizione della sezione Panoramica .

- Nome gruppo di risorse di Azure: usare il nome del gruppo di risorse nella sezione Panoramica .

Per Nome gruppo di servizi cognitivi usare il nome della risorsa Visione personalizzata seguito da -Prediction.

- Endpoint previsione di base della risorsa: usare l'endpoint delle chiavi e dell'endpoint nella risorsa Visione personalizzata -Prediction.

- Chiave di stima API: usare la chiave 1 dalle chiavi e dall'endpoint nella risorsa Visione personalizzata -Prediction.

Recuperare le credenziali delle impostazioni del progetto

Nel dashboard Visione personalizzata aprire il progetto creato per questa esercitazione, quindi selezionare l'icona Impostazioni (ingranaggio) nell'angolo superiore destro della pagina per aprire la pagina Impostazioni. Le credenziali necessarie sono disponibili nella sezione Risorse sul lato destro e nella sezione Generale sul lato sinistro.

- Endpoint di base della risorsa: usare l'endpoint dalla sezione Risorse . Deve corrispondere all'endpoint in Chiavi ed endpoint nella risorsa Visione personalizzata.

- Chiave API: usare la chiave dalla sezione Risorse . Deve corrispondere alla chiave in Chiavi ed endpoint nella risorsa Visione personalizzata.

- ID progetto: usare l'ID progetto della sezione Generale .

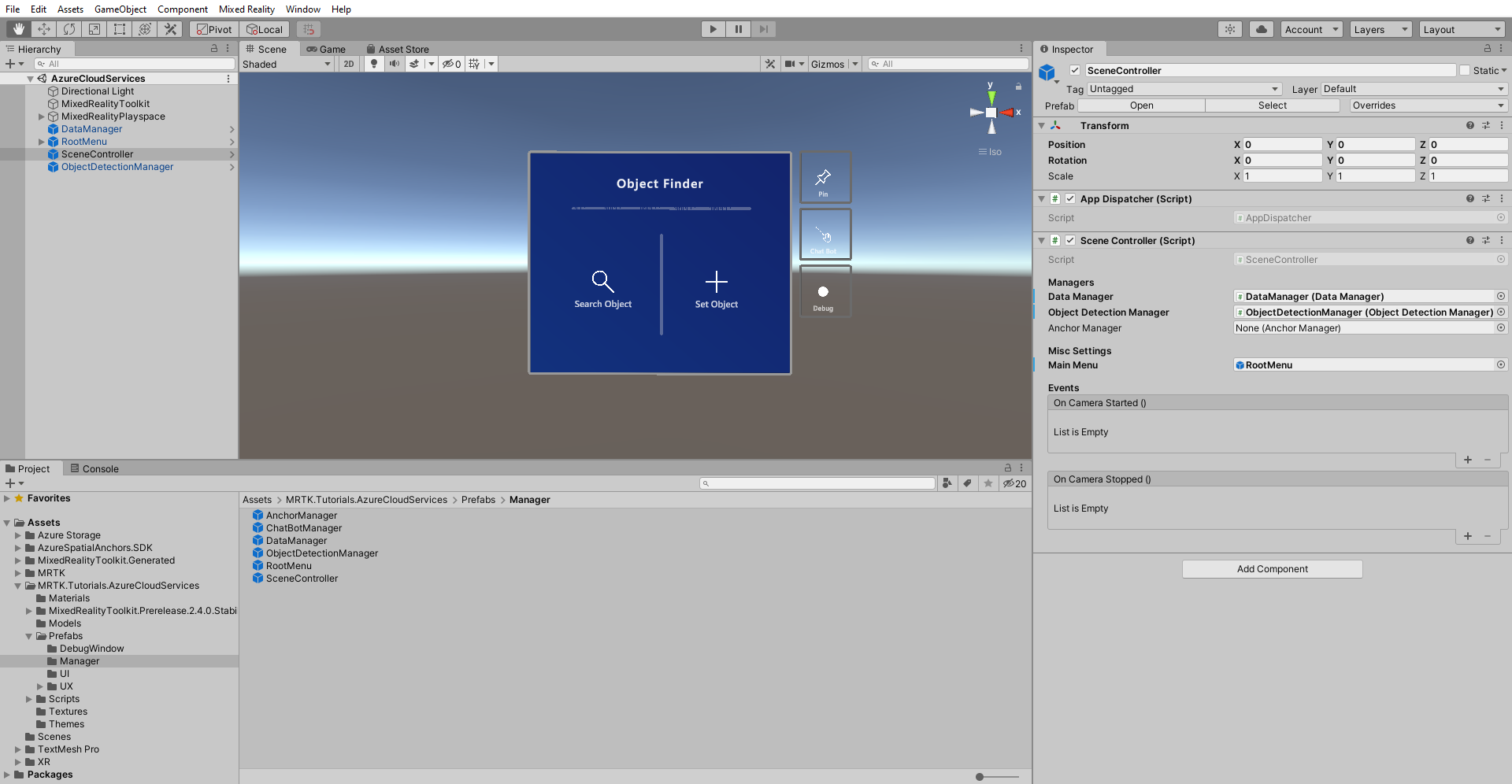

Ora, con objectDetectionManager (script) configurato correttamente, trovare l'oggetto SceneController nella gerarchia della scena e selezionarlo.

Il campo Gestione rilevamento oggetti nel componente SceneController è vuoto. Trascinare ObjectDetectionManager dalla gerarchia nel componente SceneController e salvare la scena.

Acquisire e caricare immagini

Eseguire la scena e selezionare Imposta oggetto. Immettere il nome di uno degli Oggetti tracciati creati nella lezione precedente. Selezionare il pulsante Visione artificiale nella parte inferiore della scheda oggetto.

Verrà aperta una nuova finestra. Si scatteranno sei foto per eseguire il training del modello per il riconoscimento delle immagini. Selezionare il pulsante Fotocamera ed eseguire un AirTap per visualizzare l'oggetto che si vuole tenere traccia. Fai questo sei volte.

Suggerimento

Per migliorare il training del modello, provare a acquisire ogni immagine da diverse angolazioni e condizioni di illuminazione.

Quando le immagini sono sufficienti, fare clic sul pulsante Esegui training per avviare il processo di training del modello nel cloud. In questo modo vengono caricate tutte le immagini e viene avviato il training. Il processo potrebbe richiedere alcuni minuti. Un messaggio all'interno del menu indica lo stato di avanzamento corrente. Al termine del processo, è possibile arrestare l'applicazione.

Suggerimento

ObjectDetectionManager (script) carica direttamente le immagini acquisite nel servizio Visione personalizzata. In alternativa, l'API Visione personalizzata accetta gli URL nelle immagini. Come esercizio, è possibile modificare ObjectDetectionManager (script) per caricare le immagini in un archivio BLOB.

Avviso

Se il training non riesce, controllare il dashboard Visione personalizzata e assicurarsi di avere almeno due tag e che ogni tag abbia almeno cinque immagini.

Rilevare oggetti

È ora possibile passare al test del modello con training. Eseguire l'applicazione. Dal menu Principale selezionare Cerca oggetto e immettere il nome dell'oggetto tracciato in questione. Verrà visualizzata la Scheda oggetto. Selezionare quindi il pulsante Visione personalizzata. *ObjectDetectionManager inizierà a acquisire immagini in background dalla fotocamera. e mostrerà lo stato di avanzamento dell'applicazione. Puntare la fotocamera sull'oggetto usato per il training del modello. Dopo alcuni istanti dovrebbe rilevare l'oggetto.