델타 레이크 형식으로 Dataverse 데이터 내보내기

Azure Synapse Link for Dataverse를 사용하여 Microsoft Dataverse 데이터를 델타 레이크 형식의 Azure Synapse Analytics로 내보냅니다. 그런 다음 데이터를 탐색하고 인사이트를 얻는 시간을 단축하세요. 이 문서에서는 다음 정보를 제공하고 다음 작업을 수행하는 방법을 보여줍니다.

- 델타 레이크 및 Parquet와 이 형식으로 데이터를 내보내야 하는 이유를 설명합니다.

- Dataverse 데이터를 Azure Synapse Link를 사용하여 델타 레이크 형식으로 Azure Synapse Analytics 작업 영역으로 내보냅니다.

- Azure Synapse Link 및 데이터 변환을 모니터링하십시오.

- Azure Data Lake Storage Gen2에서 데이터를 봅니다.

- Synapse 작업 영역에서 데이터를 봅니다.

중요

- 기존 사용자 지정 보기를 사용하여 CSV에서 Delta Lake로 업그레이드하는 경우 모든 partitioned 테이블을 non_partitioned로 바꾸도록 스크립트를 업데이트하는 것이 좋습니다.

_partitioned의 인스턴스를 찾아 빈 문자열로 바꾸면 됩니다. - Dataverse 구성의 경우

appendonly모드에서 CSV 데이터를 내보내려면 추가 전용이 기본적으로 활성화되어 있습니다. 그러나 Delta Lake 변환은 주기적인 병합 프로세스와 함께 제공되기 때문에 Delta Lake 테이블은 인플레이스 업데이트 구조를 갖게 됩니다. - Spark 풀을 만들 때 발생하는 비용은 없습니다. 대상 Spark 풀에서 Spark 작업이 실행되고 요청 시 Spark 인스턴스가 인스턴스화된 경우에만 요금이 발생합니다. 이러한 비용은 Azure Synapse workspace Spark의 사용과 관련이 있으며 매월 청구됩니다. Spark 컴퓨팅을 수행하는 비용은 주로 증분 업데이트의 시간 간격과 데이터 볼륨에 따라 다릅니다. 추가 정보: Azure Synapse Analytics 가격

- 이 템플릿은 선택 사항이 아니며 이 기능을 계속 사용하려면 지불해야 하므로 이 기능을 사용하기로 결정할 때 이러한 추가 비용을 고려하는 것이 중요합니다.

- Azure Synapse Runtime for Apache Spark 3.1의 EOLA(수명 종료 발표)가 2023년 1월 26일에 발표되었습니다. Synapse runtime for Apache Spark 수명 주기 정책에 따라, Azure Synapse runtime for Apache Spark 3.1은 2024년 1월 26일부터 사용이 중지되고 비활성화됩니다. EOL 날짜 이후에는 사용 중지된 런타임을 새 Spark 풀에 사용할 수 없으며 기존 워크플로를 실행할 수 없습니다. 메타데이터는 일시적으로 Synapse 작업 영역에 유지됩니다. 추가 정보: Azure Synapse Runtime for Apache Spark 3.1(EOLA). Delta Lake 형식으로 내보내기가 포함된 Dataverse용 Synapse Link를 Spark 3.3으로 업그레이드하려면 기존 프로필에 대해 전체 업그레이드를 수행하세요. 추가 정보: Delta Lake 2.2를 사용하여 Apache Spark 3.3으로 즉시 업그레이드

- 2024년 1월 4일부터 링크를 처음 생성할 때 Spark Pool 버전 3.3만 지원됩니다.

참고

Power Apps(make.powerapps.com)의 Azure Synapse Link 상태는 Delta Lake 변환 상태를 반영합니다.

Count는 Delta Lake 테이블의 레코드 수를 나타냅니다.Last synchronized on날짜/시간은 마지막으로 성공한 변환 타임스탬프를 나타냅니다.- 데이터 동기화 및 Delta Lake 변환이 완료되면

Sync status가 활성으로 표시되어 데이터를 사용할 준비가 되었음을 나타냅니다.

델타 레이크란?

델타 레이크는 데이터 레이크 위에 레이크하우스 아키텍처를 구축할 수 있는 오픈 소스 프로젝트입니다. 델타 레이크는 ACID(원자성, 일관성, 격리 및 내구성) 트랜잭션, 확장 가능한 메타데이터 처리를 제공하고 기존 데이터 레이크 위에 스트리밍 및 대량 데이터 처리를 통합합니다. Azure Synapse Analytics는 Linux Foundation 델타 레이크와 호환됩니다. Azure Synapse에 포함된 델타 레이크의 현재 버전에는 Scala, PySpark 및 .NET에 대한 언어 지원이 있습니다. 추가 정보: 델타 레이크란? 델타 테이블 소개 동영상에서도 자세히 알아볼 수 있습니다.

Apache Parquet는 델타 레이크의 기본 형식으로, 형식 고유의 효율적인 압축 및 인코딩 체계를 활용할 수 있습니다. Parquet 파일 형식은 열 단위 압축을 사용합니다. 효율적이고 저장 공간을 절약합니다. 특정 열 값을 가져오는 쿼리는 전체 행 데이터를 읽을 필요가 없으므로 성능이 향상됩니다. 따라서 서버리스 SQL 풀은 데이터를 읽는 데 더 적은 시간과 더 적은 스토리지 요청이 필요합니다.

델타 레이크를 사용하는 이유는 무엇인가요?

- 확장성: 델타 레이크는 대규모 데이터 처리 워크로드를 처리하기 위한 업계 표준을 충족하도록 설계된 오픈 소스 Apache 라이선스를 기반으로 구축되었습니다.

- 신뢰성: 델타 레이크는 ACID 트랜잭션을 제공하여 오류 또는 동시 액세스가 발생하더라도 데이터 일관성과 안정성을 보장합니다.

- 성능: 델타 레이크는 Parquet의 열 기반 스토리지 형식을 활용하여 더 나은 압축 및 인코딩 기술을 제공하므로 쿼리 CSV 파일에 비해 쿼리 성능이 향상될 수 있습니다.

- 비용 효율적: 델타 레이크 파일 형식은 고도로 압축된 데이터 저장 기술로 기업에 상당한 저장 공간 절약 효과를 제공합니다. 이 형식은 데이터 처리를 최적화하고 온디맨드 컴퓨팅에 필요한 총 데이터 처리량 또는 실행 시간을 잠재적으로 줄이기 위해 특별히 설계되었습니다.

- 데이터 보호 규정 준수: Azure Synapse Link가 포함된 델타 레이크는 GDPR(일반 데이터 보호 규정)을 비롯한 다양한 데이터 개인 정보 보호 규정을 준수하기 위해 일시 삭제 및 영구 삭제를 포함한 도구와 기능을 제공합니다.

델타 레이크는 Azure Synapse Link for Dataverse와 어떻게 작동하나요?

Azure Synapse Link for Dataverse를 설정할 때 델타 레이크로 내보내기 기능을 활성화하고 Synapse 작업 영역 및 Spark 풀과 연결할 수 있습니다. Azure Synapse Link는 선택한 Dataverse 테이블을 지정된 시간 간격으로 CSV 형식으로 내보내고 델타 레이크 변환 Spark 작업을 통해 처리합니다. 이 변환 프로세스가 완료되면 스토리지 저장을 위해 CSV 데이터가 정리됩니다. 또한 일련의 유지 관리 작업이 매일 실행되도록 예약되어 자동으로 압축 및 제거 프로세스를 수행하여 데이터 파일을 병합 및 정리하여 스토리지를 더욱 최적화하고 쿼리 성능을 향상시킵니다.

전제 조건

- Dataverse: Dataverse 시스템 관리자 보안 역할이 있어야 합니다. 또한 Azure Synapse Link를 통해 내보내려는 테이블에는 변경 사항 추적 속성이 활성화되어 있어야 합니다. 추가 정보: 고급 옵션

- Azure Data Lake Storage Gen2: Azure Data Lake Storage Gen2 계정과 소유자 및 Storage Blob 데이터 기여자 역할 액세스 권한이 있어야 합니다. 스토리지 계정은 초기 설정과 델타 동기화 모두에 대해 계층 구조 네임스페이스 및 공용 네트워크 액세스를 활성화해야 합니다. 스토리지 계정 키 액세스 허용은 초기 설정에만 필요합니다.

- Synapse 작업 영역: Synapse 작업 영역과 액세스 제어(IAM)의 담당자 역할 및 Synapse Studio 내 Synapse 관리자 역할 액세스 권한이 있어야 합니다. Synapse 작업 영역은 사용자의 Azure Data Lake Storage Gen2 계정과 동일한 지역에 있어야 합니다. 스토리지 계정은 Synapse Studio 내에서 연결된 서비스로 추가되어야 합니다. Synapse 작업 영역을 만들려면 Synapse 작업 영역 만들기로 이동하십시오.

- 버전 3.3이 있는 연결된 작업 공간의 풀 Apache Spark 이 Azure Synapse 이 권장하는 Spark 풀 구성을 사용합니다. Apache Spark ... Spark 풀을 만드는 방법에 대한 자세한 내용은 새 Apache Spark 풀 만들기로 이동합니다.

- 이 기능을 사용하기 위한 Microsoft Dynamics 365 최소 버전 요구 사항은 9.2.22082입니다. 추가 정보: 조기 액세스 업데이트 옵트인

권장 Spark 풀 구성

이 구성은 일반적인 사용 사례의 부트스트랩 단계로 간주할 수 있습니다.

- 노드 크기: 소형(vCore 4개/32GB)

- 자동 크기 조정: 사용

- 노드 수: 5~10

- 자동 일시 중지: 사용

- 유휴 시간(분): 5

- Apache Spark: 3.3

- 동적으로 실행자 할당: 활성화됨

- 기본 실행자 수: 1~9

중요

Synapse 연결를 사용하여 Delta Lake 대화 작업에만 Spark 풀을 사용합니다 Dataverse. 최적의 안정성과 성능을 위해 동일한 Spark 풀을 사용하여 다른 Spark 작업을 실행하지 마세요.

Dataverse를 Synapse 작업 영역에 연결하고 델타 레이크 형식으로 데이터 내보내기

Power Apps에 로그인하여 원하는 환경을 선택합니다.

왼쪽 탐색 창에서 Azure Synapse Link를 선택합니다. 항목이 측면 패널 창을 경우 ...자세히를 선택한 다음 원하는 항목을 선택하세요.

명령 모음에서 + 새 링크를 선택합니다

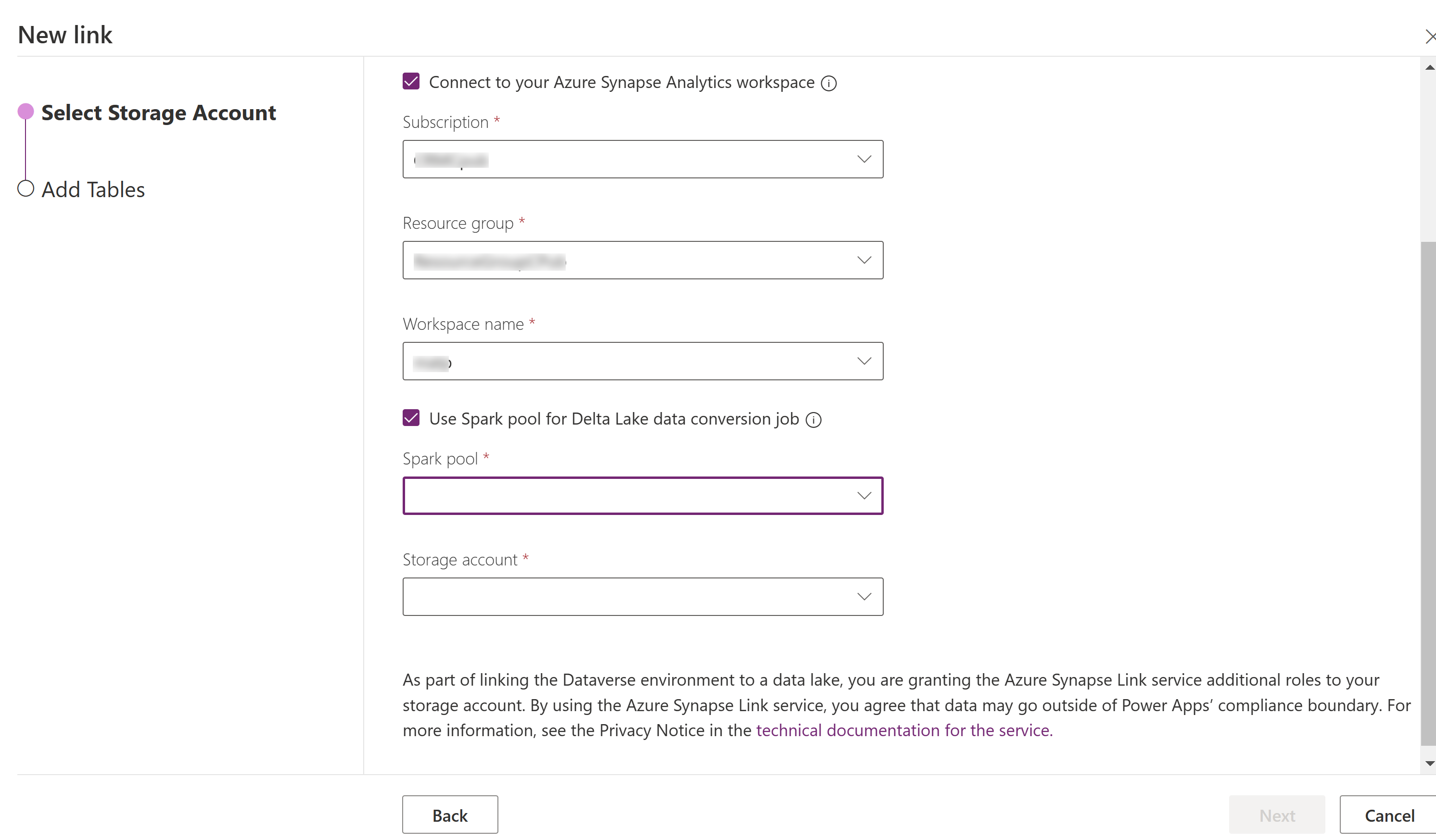

Azure Synapse Analytics 작업 영역에 연결을 선택한 다음 구독, 리소스 그룹 및 작업 영역 이름을 선택합니다.

처리에 Spark 풀 사용을 선택한 다음, 미리 생성된 Spark 풀 및 스토리지 계정을 선택합니다.

다음을 선택합니다.

내보낼 테이블을 추가한 다음 고급을 선택합니다.

필요에 따라 고급 구성 설정 표시를 선택하고 증분 업데이트를 캡처해야 하는 간격을 분 단위로 입력합니다.

저장을 선택합니다.

Azure Synapse Link 및 데이터 변환 모니터링

- 원하는 Azure Synapse Link를 선택한 다음, 명령 모음에서 Azure Synapse Analytics 작업 영역으로 이동을 선택합니다.

- 모니터 > Apache Spark 애플리케이션을 선택합니다. 추가 정보: Synapse Studio를 사용하여 Apache Spark 애플리케이션 모니터링

Synapse 작업 영역에서 데이터 보기

- 원하는 Azure Synapse Link를 선택한 다음, 명령 모음에서 Azure Synapse Analytics 작업 영역으로 이동을 선택합니다.

- 왼쪽 창에서 레이크 데이터베이스를 확장하고 dataverse-environmentNameorganizationUniqueName을 선택한 다음 테이블을 확장합니다. 모든 Parquet 테이블이 나열되고 명명 규칙 DataverseTableName을 사용하여 분석에 사용할 수 있습니다. (분할되지 않은 테이블).

참고

명명 규칙 _partitioned가 있는 테이블을 사용하지 마세요. 형식으로 Delta parquet를 선택하면 _partition 명명 규칙이 있는 테이블이 스테이징 테이블로 사용되고 시스템에서 사용된 후 제거됩니다.

Azure Data Lake Storage Gen2에서 데이터 보기

- 원하는 Azure Synapse Link를 선택한 다음 명령 모음에서 Azure 데이터 레이크로 이동을 선택합니다.

- 데이터 저장소에서 컨테이너를 선택합니다.

- dataverse- **environmentName-organizationUniqueName을 선택합니다. 모든 Parquet 파일은 deltalake 폴더에 저장됩니다.

Delta Lake 2.2를 사용하여 Apache Spark 3.3으로 즉시 업그레이드

전제 조건

- Synapse Spark 버전 3.1을 사용하여 실행되는 기존 Azure Synapse Link for Dataverse Delta Lake 프로필이 있어야 합니다.

- 동일한 Synapse 작업 영역 내에서 동일하거나 더 높은 노드 하드웨어 구성을 사용하여 Spark 버전 3.3으로 새 Synapse Spark 풀을 만들어야 합니다. Spark 풀을 만드는 방법에 대한 자세한 내용은 새 Apache Spark 풀 만들기로 이동합니다. 이 Spark 풀은 현재 3.1 풀과 독립적으로 생성되어야 합니다.

Spark 3.3로 즉시 업그레이드:

- Power Apps에 로그인하고 원하는 환경을 선택합니다.

- 왼쪽 탐색 창에서 Azure Synapse Link를 선택합니다. 항목이 왼쪽 탐색 창을 경우 ...자세히를 선택한 다음 원하는 항목을 선택하세요.

- Azure Synapse Link 프로필을 연 다음 Delta Lake 2.2를 사용하여 Apache Spark 3.3으로 업그레이드를 선택합니다.

- 목록에서 사용 가능한 Spark 풀을 선택한 다음 업데이트를 선택합니다.

참고

Spark 풀 업그레이드는 새 Delta Lake 변환 Spark 작업이 트리거되는 경우에만 발생합니다. 업데이트를 선택한 후 데이터 변경이 하나 이상 있는지 확인하세요.