Como configurar os filtros de conteúdo com o Serviço OpenAI do Azure

O sistema de filtragem de conteúdo integrado ao Serviço OpenAI do Azure é executado junto com os modelos principais, incluindo os modelos de geração de imagem DALL-E. Ele usa um conjunto de modelos de classificação de várias classes para detectar quatro categorias de conteúdo nocivo (violência, ódio, sexual e automutilação) em quatro níveis de gravidade, respectivamente (seguro, baixo, médio e alto), e classificadores binários opcionais para detectar o risco de violação de cadeias, texto existente e código nos repositórios públicos. A configuração de filtragem de conteúdo padrão é definida para filtrar no limite de gravidade médio para todas as quatro categorias de danos de conteúdo para prompts e conclusões. Isso significa que o conteúdo detectado no nível de gravidade médio ou alto é filtrado, enquanto o conteúdo detectado no nível de gravidade baixo ou seguro não é filtrado pelos filtros de conteúdo. Saiba mais sobre as categorias de conteúdo, os níveis de gravidade e o comportamento do sistema de filtragem de conteúdo aqui. A detecção de risco de jailbreak e os modelos de texto e código protegidos são opcionais e desativados por padrão. Para modelos de código e texto de material protegido e jailbreak, o recurso de configurabilidade permite que todos os clientes ativem e desativem os modelos. Os modelos estão desativados por padrão e podem ser ativados de acordo com seu cenário. Alguns modelos devem estar ativados para determinados cenários manterem a cobertura no Compromisso de Direitos Autorais do Cliente.

Observação

Todos os clientes têm a capacidade de modificar os filtros de conteúdo e configurar os limites de gravidade (baixo, médio, alto). A aprovação é necessária para desativar parcial ou totalmente os filtros de conteúdo. Os clientes gerenciados só podem solicitar o controle total da filtragem de conteúdo por meio deste formulário: Revisão de acesso limitado do OpenAI do Azure: Filtros de Conteúdo Modificados. No momento, não é possível se tornar um cliente gerenciado.

Os filtros de conteúdo podem ser configurados no nível do recurso. Uma vez que uma nova configuração é criada, ela pode ser associada a uma ou mais implantações. Para obter mais informações sobre a implantação do modelo, consulte o Guia de implantação de recursos.

Pré-requisitos

- Você precisa ter um recurso de OpenAI do Azure e uma implantação de LLM (modelo de linguagem grande) para configurar filtros de conteúdo. Siga nosso início rápido para começar.

Entender a configurabilidade do filtro de conteúdo

O Serviço OpenAI do Azure inclui configurações de segurança padrão aplicadas a todos os modelos, excluindo o Whisper do OpenAI do Azure. Essas configurações fornecem uma experiência responsável por padrão, incluindo modelos de filtragem de conteúdo, listas de bloqueio, transformação de prompt, credenciais de conteúdo e outros. Leia mais sobre isso aqui.

Todos os clientes também podem configurar filtros de conteúdo e criar políticas de segurança personalizadas adaptadas aos requisitos de caso de uso. O recurso de configurabilidade permite que os clientes ajustem as configurações, separadamente para prompts e conclusões, para filtrar o conteúdo de cada categoria de conteúdo em diferentes níveis de gravidade, conforme descrito na tabela abaixo. O conteúdo detectado no nível de gravidade "seguro" é rotulado em anotações, mas não está sujeito a filtragem e não é configurável.

| Gravidade filtrada | Configurável para prompts | Configurável para conclusões | Descrições |

|---|---|---|---|

| Baixo, médio ou alto | Sim | Sim | Configuração de filtragem mais rigorosa. O conteúdo detectado nos níveis de gravidade baixo, médio e alto é filtrado. |

| Médio, alto | Sim | Yes | O conteúdo detectado no nível de severidade baixo não é filtrado, enquanto o conteúdo nos níveis médio e alto é filtrado. |

| Alto | Sim | Yes | O conteúdo detectado nos níveis de gravidade baixo e médio não será filtrado. Somente o conteúdos com nível de gravidade alto serão filtrados. |

| Nenhum filtro | Se aprovado1 | Se aprovado1 | nenhum conteúdo será filtrado, independentemente do nível de gravidade detectado. Exige aprovação1. |

| Anotar somente | Se aprovado1 | Se aprovado1 | Desabilita a funcionalidade de filtro para que o conteúdo não seja bloqueado, mas as anotações são retornadas por meio da resposta à API. Exige aprovação1. |

1 Para modelos de OpenAI do Azure, somente os clientes aprovados para filtragem de conteúdo modificado têm o controle completo de filtragem de conteúdo e podem desativar os filtros de conteúdo. Aplique filtros de conteúdo modificados por meio deste formulário: Revisão de acesso limitado do OpenAI do Azure: filtros de conteúdo modificados. Para clientes do Azure Governamental, solicite filtros de conteúdo modificados por meio deste formulário: Azure Governamental – Solicitar filtragem de conteúdo modificada para o Serviço OpenAI do Azure.

Filtros de conteúdo configuráveis para entradas (prompts) e saídas (conclusões) estão disponíveis para os seguintes modelos do Azure OpenAI:

- Série de modelos GPT

- GPT-4 Turbo com Visão GA* (

turbo-2024-04-09) - GPT-4o

- GPT-4o mini

- DALL-E 2 e 3

Os filtros de conteúdo configuráveis não estão disponíveis para

- o1-preview

- o1-mini

*Disponível apenas para o GPT-4 Turbo Vision em disponibilidade geral, não se aplica à versão prévia do GPT-4 Turbo Vision

As configurações de filtragem de conteúdo são criadas em um Recurso no Estúdio de IA do Azure e podem ser associadas a Implantações. Saiba mais sobre configurabilidade aqui.

Os clientes são responsáveis por garantir que os aplicativos que integram o OpenAI do Azure estejam em conformidade com o Código de conduta.

Entender outros filtros

Você pode configurar as categorias de filtro a seguir, além dos filtros de categoria de danos padrão.

| Categoria de filtro | Status | Configuração padrão | Aplicado ao prompt ou à conclusão? | Descrição |

|---|---|---|---|---|

| Prompt Shields para ataques diretos (jailbreak) | GA | Ativado | Prompt de usuário | Filtra/anota os prompts do usuário que podem apresentar um risco de jailbreak. Para obter mais informações sobre anotações, acesse Filtragem de conteúdo do Serviço OpenAI do Azure. |

| Prompt Shields para ataques indiretos | GA | Ativado | Prompt de usuário | Filtre/anote ataques indiretos, também conhecidos como ataques de prompt indireto ou ataques de injeção de prompt entre domínios, uma vulnerabilidade potencial onde terceiros colocam instruções maliciosas dentro de documentos que o sistema de IA generativa pode acessar e processar. Obrigatório: Formatação de documento. |

| Material protegido – código | GA | Ativado | Completion | Filtra o código protegido ou obtém as informações de citação e licença de exemplo em anotações para snippets de código que correspondem a quaisquer fontes de código público, alimentadas pelo GitHub Copilot. Para obter mais informações sobre como consumir anotações, confira oguia de conceitos de filtragem de conteúdo |

| Material protegido – texto | GA | Ativado | Completion | Identifica e impede que o conteúdo de texto conhecido seja exibido na saída do modelo (por exemplo, letras de música, receitas e conteúdo da Web selecionado). |

Configurar filtros de conteúdo por meio do Estúdio de OpenAI do Azure

As seguintes etapas mostram como definir uma configuração de filtragem de conteúdo personalizada para seu recurso.

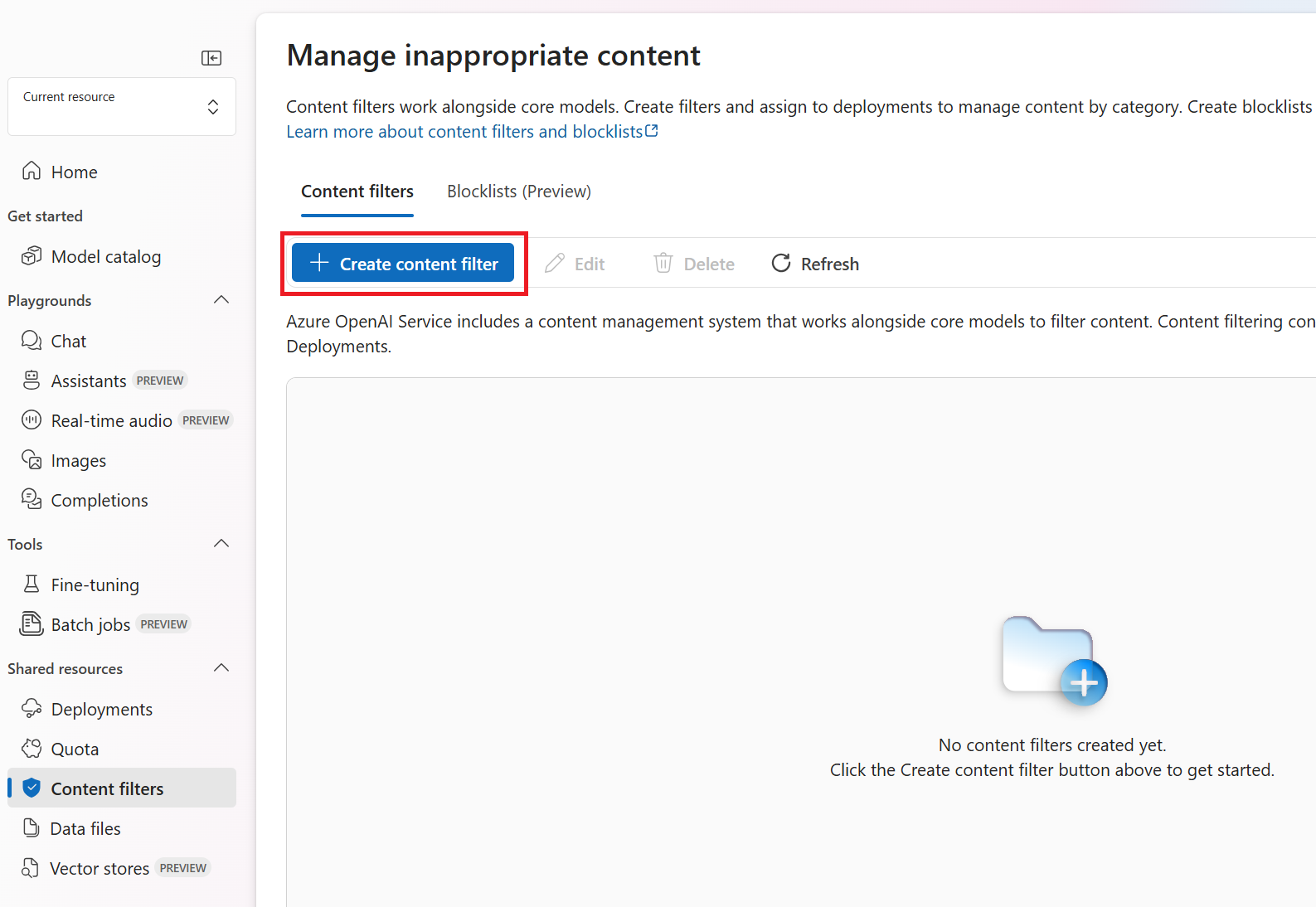

Acesse o Estúdio de OpenAI do Azure e navegue até a guia Filtros de Conteúdo (na navegação inferior esquerda, conforme indicado pela caixa vermelha abaixo).

Criar uma nova configuração personalizada de filtragem de conteúdo.

Isso leva à seguinte exibição de configuração, na qual você pode escolher um nome para a configuração da filtragem de conteúdo personalizada. Depois de inserir um nome, você pode configurar os filtros de entrada (prompts do usuário) e os filtros de saída (resposta do modelo). Para as quatro primeiras categorias de conteúdo, há três níveis de gravidade configuráveis: baixo, médio e alto. Você pode usar os controles deslizantes para definir o limite de severidade se determinar que o seu aplicativo ou cenário de uso exigem uma filtragem diferente dos valores padrão. Alguns filtros permitem determinar se o modelo deve anotar e/ou bloquear. Selecionar Anotar executa o respectivo modelo e retorna anotações por meio da resposta à API, mas não filtrará o conteúdo. Além das anotações, você também pode optar por filtrar o conteúdo alternando a alternância filtro para ativada.

Se seu caso de uso foi aprovado para filtros de conteúdo modificados conforme descrito acima, você receberá controle total sobre as configurações de filtragem de conteúdo e você pode escolher desativar a filtragem parcial ou completamente.

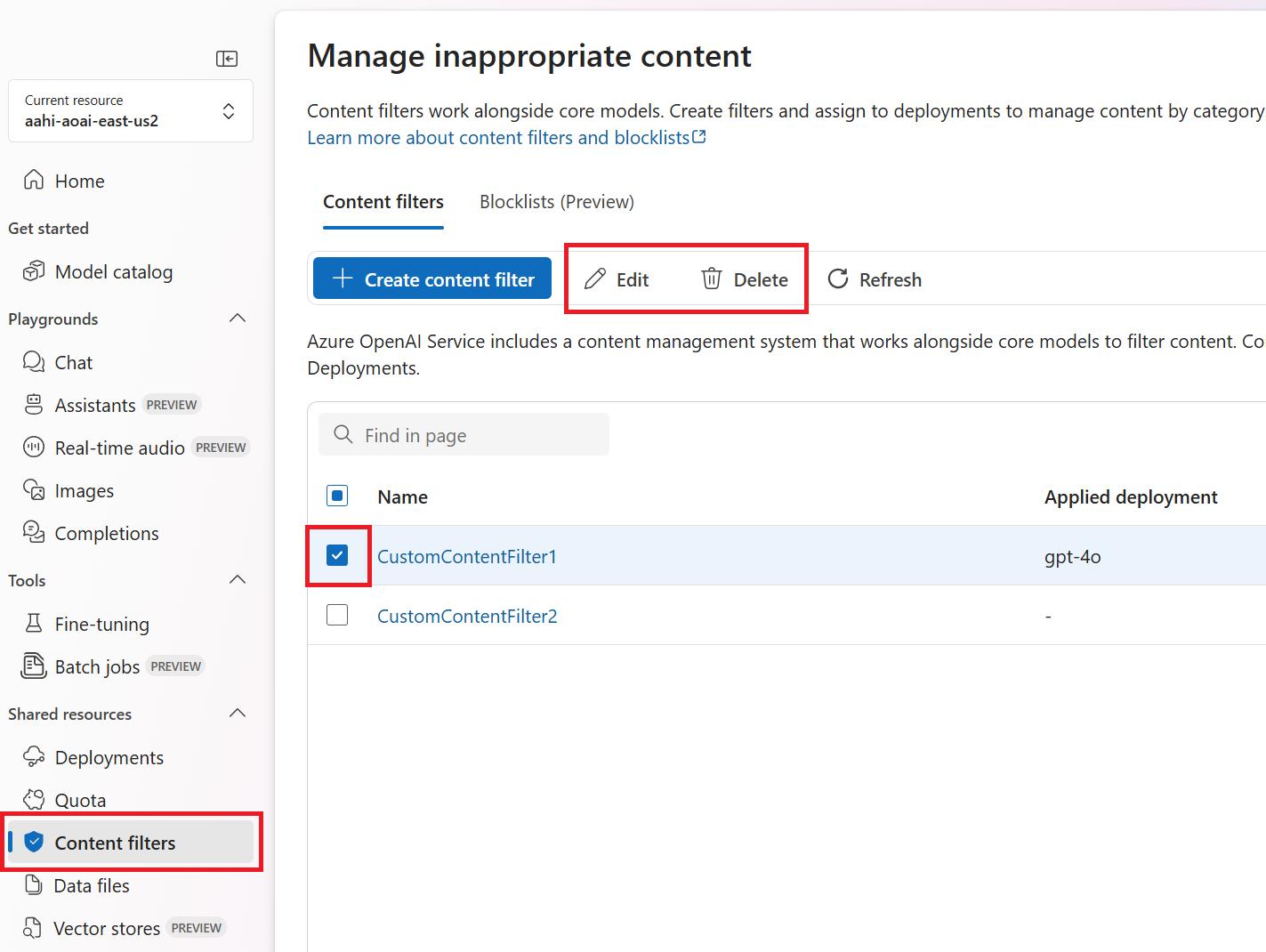

Você pode criar várias configurações de filtragem de conteúdo de acordo com suas necessidades.

Em seguida, para tornar operacional uma configuração de filtragem de conteúdo personalizada, atribua uma configuração a uma ou mais implantações no seu recurso. Para fazer isso, vá para a guia Implantações e selecione a sua implantação. Em seguida, selecione Editar.

Na janela Atualizar implantação exibida, selecione o seu filtro personalizado no menu suspenso Filtro de conteúdo. Em seguida, selecione Salvar e fechar para aplicar a configuração selecionada à implantação.

Você também pode editar e excluir uma configuração de filtro de conteúdo, se necessário. Para fazer isso, navegue até a guia filtros de conteúdo e selecione uma configuração. Em seguida, selecione a ação desejada. Você só pode editar uma configuração de filtragem por vez.

Observação

Antes de excluir uma configuração de filtragem de conteúdo, será necessário desatribuí-la de qualquer implantação na guia Implantações.

Seguir as práticas recomendadas

Recomendamos que você informe suas decisões de configuração de filtragem de conteúdo por meio de um processo iterativo de identificação (por exemplo, teste de agrupamento vermelho, teste de estresse e análise) e medição para abordar os possíveis danos que são relevantes para um modelo, aplicativo e cenário de implantação específicos. Após a implementação de mitigações, como a filtragem de conteúdo, repita a medição para testar a eficácia. Recomendações e práticas recomendadas para IA Responsável para o OpenAI do Azure, com base no IA Responsável da Microsoft Standard, podem ser encontradas na Visão Geral de IA Responsável para o OpenAI do Azure.

Conteúdo relacionado

- Saiba mais sobre as práticas de IA Responsável para o OpenAI do Azure: Visão geral das práticas de IA Responsável para os modelos do OpenAI do Azure.

- Leia mais sobre as categorias de filtragem de conteúdo e níveis de gravidade com o Serviço OpenAI do Azure.

- Saiba mais sobre a formação de agrupamentos vermelhos em nosso artigo: Introdução aos modelos de linguagem grande (LLMs) do agrupamento vermelho.