O que é IA responsável?

APLICA-SE A: Azure CLI ml extension v2 (current)

Azure CLI ml extension v2 (current) Python SDK azure-ai-ml v2 (current)

Python SDK azure-ai-ml v2 (current)

A Inteligência Artificial Responsável (IA Responsável) é uma abordagem para desenvolver, avaliar e implantar sistemas de IA de forma segura, confiável e ética. Os sistemas de IA são o produto de muitas decisões tomadas por aqueles que os desenvolvem e implantam. Do propósito do sistema à forma como as pessoas interagem com os sistemas de IA, a IA Responsável pode ajudar a orientar proativamente essas decisões para resultados mais benéficos e equitativos. Isso significa manter as pessoas e seus objetivos no centro das decisões de design de sistemas e respeitar valores duradouros como justiça, confiabilidade e transparência.

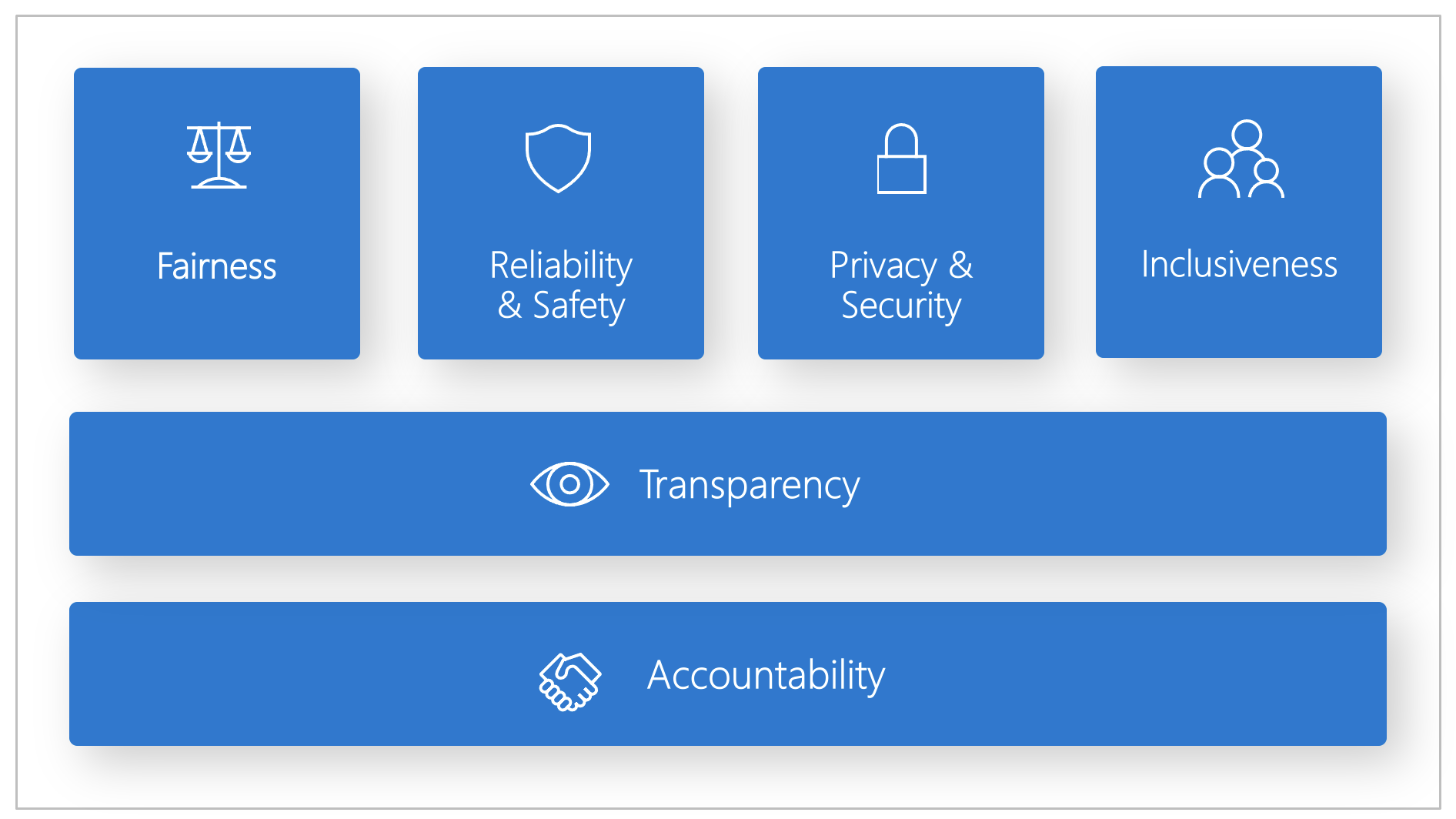

A Microsoft desenvolveu um Padrão de IA Responsável. É uma estrutura para construir sistemas de IA de acordo com seis princípios: justiça, confiabilidade e segurança, privacidade e segurança, inclusão, transparência e responsabilidade. Para a Microsoft, esses princípios são a pedra angular de uma abordagem responsável e confiável à IA, especialmente à medida que a tecnologia inteligente se torna mais prevalente em produtos e serviços que as pessoas usam todos os dias.

Este artigo demonstra como o Azure Machine Learning dá suporte a ferramentas para permitir que desenvolvedores e cientistas de dados implementem e operacionalizem os seis princípios.

Equidade e inclusão

Os sistemas de IA devem tratar todos de forma justa e evitar afetar grupos de pessoas com situação semelhante de maneiras diferentes. Por exemplo, quando os sistemas de IA fornecem orientação sobre tratamento médico, pedidos de empréstimo ou emprego, eles devem fazer as mesmas recomendações para todos que têm sintomas, circunstâncias financeiras ou qualificações profissionais semelhantes.

Equidade e inclusão no Azure Machine Learning: o componente de avaliação de equidade do painel de IA responsável permite que cientistas de dados e desenvolvedores avaliem a equidade do modelo em grupos sensíveis definidos em termos de gênero, etnia, idade e outras características.

Fiabilidade e segurança

Para construir confiança, é fundamental que os sistemas de IA operem de forma confiável, segura e consistente. Estes sistemas devem ser capazes de funcionar como foram originalmente concebidos, responder com segurança a condições imprevistas e resistir a manipulações prejudiciais. Como eles se comportam e a variedade de condições que podem lidar refletem a variedade de situações e circunstâncias que os desenvolvedores anteciparam durante o projeto e os testes.

Confiabilidade e segurança no Azure Machine Learning: o componente de análise de erros do painel de IA responsável permite que cientistas de dados e desenvolvedores:

- Obtenha uma compreensão profunda de como a falha é distribuída para um modelo.

- Identificar coortes (subconjuntos) de dados com uma taxa de erro mais elevada do que o valor de referência global.

Essas discrepâncias podem ocorrer quando o sistema ou modelo tem um desempenho inferior para grupos demográficos específicos ou para condições de entrada raramente observadas nos dados de treinamento.

Transparency

Quando os sistemas de IA ajudam a informar decisões que têm impactos tremendos na vida das pessoas, é fundamental que as pessoas entendam como essas decisões foram tomadas. Por exemplo, um banco pode usar um sistema de IA para decidir se uma pessoa é digna de crédito. Uma empresa pode usar um sistema de IA para determinar os candidatos mais qualificados para contratar.

Uma parte crucial da transparência é a interpretabilidade: a explicação útil do comportamento dos sistemas de IA e seus componentes. Melhorar a interpretabilidade exige que as partes interessadas compreendam como e por que os sistemas de IA funcionam da maneira que funcionam. As partes interessadas podem então identificar potenciais problemas de desempenho, problemas de equidade, práticas excludentes ou resultados não intencionais.

Transparência no Azure Machine Learning: A interpretabilidade do modelo e os componentes hipotéticos contrafactuais do painel de IA responsável permitem que cientistas de dados e desenvolvedores gerem descrições compreensíveis por humanos das previsões de um modelo.

O componente de interpretabilidade do modelo fornece várias visualizações do comportamento de um modelo:

- Explicações globais. Por exemplo, quais recursos afetam o comportamento geral de um modelo de alocação de empréstimos?

- Explicações locais. Por exemplo, por que o pedido de empréstimo de um cliente foi aprovado ou rejeitado?

- Explicações do modelo para uma coorte selecionada de pontos de dados. Por exemplo, quais características afetam o comportamento geral de um modelo de alocação de empréstimos para candidatos de baixa renda?

O componente hipotético contrafactual permite entender e depurar um modelo de aprendizado de máquina em termos de como ele reage a alterações e perturbações de recursos.

O Azure Machine Learning também suporta um scorecard de IA Responsável. O scorecard é um relatório PDF personalizável que os desenvolvedores podem facilmente configurar, gerar, baixar e compartilhar com suas partes interessadas técnicas e não técnicas para educá-los sobre a integridade de seus conjuntos de dados e modelos, alcançar a conformidade e criar confiança. Esse scorecard também pode ser usado em revisões de auditoria para descobrir as características dos modelos de aprendizado de máquina.

Privacidade e segurança

À medida que a IA se torna mais prevalente, proteger a privacidade e proteger informações pessoais e empresariais estão se tornando mais importantes e complexos. Com a IA, a privacidade e a segurança dos dados exigem muita atenção, porque o acesso aos dados é essencial para que os sistemas de IA façam previsões e decisões precisas e informadas sobre as pessoas. Os sistemas de IA devem estar em conformidade com as leis de privacidade que:

- Exigir transparência sobre a coleta, uso e armazenamento de dados.

- Exigir que os consumidores disponham de controlos adequados para escolher a forma como os seus dados são utilizados.

Privacidade e segurança no Azure Machine Learning: o Azure Machine Learning permite que administradores e desenvolvedores criem uma configuração segura que esteja em conformidade com as políticas de suas empresas. Com o Azure Machine Learning e a plataforma Azure, os utilizadores podem:

- Restrinja o acesso a recursos e operações por conta de usuário ou grupo.

- Restrinja as comunicações de rede de entrada e saída.

- Criptografe dados em trânsito e em repouso.

- Analise vulnerabilidades.

- Aplicar e auditar políticas de configuração.

A Microsoft também criou dois pacotes de código aberto que podem permitir uma maior implementação dos princípios de privacidade e segurança:

SmartNoise: Privacidade diferencial é um conjunto de sistemas e práticas que ajudam a manter os dados dos indivíduos seguros e privados. Em soluções de aprendizado de máquina, a privacidade diferencial pode ser necessária para a conformidade regulamentar. SmartNoise é um projeto de código aberto (codesenvolvido pela Microsoft) que contém componentes para a construção de sistemas diferencialmente privados que são globais.

Counterfit: Counterfit é um projeto de código aberto que compreende uma ferramenta de linha de comando e camada de automação genérica para permitir que os desenvolvedores simulem ataques cibernéticos contra sistemas de IA. Qualquer pessoa pode baixar a ferramenta e implantá-la por meio do Azure Cloud Shell para ser executada em um navegador ou implantá-la localmente em um ambiente Anaconda Python. Ele pode avaliar modelos de IA hospedados em vários ambientes de nuvem, no local ou na borda. A ferramenta é agnóstica aos modelos de IA e suporta vários tipos de dados, incluindo texto, imagens ou entrada genérica.

Responsabilidade

As pessoas que projetam e implantam sistemas de IA devem ser responsáveis por como seus sistemas operam. As organizações devem basear-se nos padrões da indústria para desenvolver normas de responsabilização. Essas normas podem garantir que os sistemas de IA não sejam a autoridade final em qualquer decisão que afete a vida das pessoas. Eles também podem garantir que os seres humanos mantenham um controle significativo sobre sistemas de IA altamente autônomos.

Responsabilidade no Azure Machine Learning: as operações de aprendizado de máquina (MLOps) são baseadas em princípios e práticas de DevOps que aumentam a eficiência dos fluxos de trabalho de IA. O Azure Machine Learning fornece os seguintes recursos de MLOps para uma melhor prestação de contas de seus sistemas de IA:

- Registre, empacote e implante modelos de qualquer lugar. Você também pode rastrear os metadados associados necessários para usar o modelo.

- Capture os dados de governança para o ciclo de vida completo do aprendizado de máquina. As informações de linhagem registradas podem incluir quem está publicando modelos, por que as alterações foram feitas e quando os modelos foram implantados ou usados na produção.

- Notifique e alerte sobre eventos no ciclo de vida do aprendizado de máquina. Os exemplos incluem conclusão de experimento, registro de modelo, implantação de modelo e deteção de desvio de dados.

- Monitore aplicativos para problemas operacionais e problemas relacionados ao aprendizado de máquina. Compare entradas de modelo entre treinamento e inferência, explore métricas específicas do modelo e forneça monitoramento e alertas em sua infraestrutura de aprendizado de máquina.

Além dos recursos de MLOps, o scorecard de IA Responsável no Azure Machine Learning cria responsabilidade ao permitir comunicações entre partes interessadas. O scorecard também cria responsabilidade, capacitando os desenvolvedores a configurar, baixar e compartilhar suas perceções de integridade do modelo com suas partes interessadas técnicas e não técnicas sobre dados de IA e integridade do modelo. Compartilhar esses insights pode ajudar a construir confiança.

A plataforma de aprendizado de máquina também permite a tomada de decisões, informando as decisões de negócios através de:

- Insights orientados por dados, para ajudar as partes interessadas a entender os efeitos do tratamento causal em um resultado, usando apenas dados históricos. Por exemplo, "Como um medicamento afetaria a pressão arterial de um paciente?" Esses insights são fornecidos por meio do componente de inferência causal do painel de IA responsável.

- Insights orientados por modelos, para responder às perguntas dos usuários (como "O que posso fazer para obter um resultado diferente da sua IA da próxima vez?") para que eles possam agir. Esses insights são fornecidos aos cientistas de dados por meio do componente hipotético contrafactual do painel de IA responsável.

Próximos passos

- Para obter mais informações sobre como implementar a IA Responsável no Azure Machine Learning, consulte Painel de IA Responsável.

- Saiba como gerar o painel de IA Responsável por meio de CLI e SDK ou da interface do usuário do estúdio Azure Machine Learning.

- Saiba como gerar um scorecard de IA Responsável com base nos insights observados no seu painel de IA Responsável.

- Saiba mais sobre o Padrão de IA Responsável para a construção de sistemas de IA de acordo com seis princípios-chave.