Configurar o treinamento de ML automatizado sem código para dados tabulares com a interface do usuário do estúdio

Neste artigo, você configura trabalhos de treinamento de aprendizado de máquina automatizado usando o ML automatizado do Azure Machine Learning no estúdio do Azure Machine Learning. Essa abordagem permite configurar o trabalho sem escrever uma única linha de código. O ML automatizado é um processo em que o Azure Machine Learning seleciona o melhor algoritmo de aprendizado de máquina para seus dados específicos. O processo permite gerar modelos de aprendizado de máquina rapidamente. Para obter mais informações, consulte Visão geral do processo de ML automatizado.

Este tutorial fornece uma visão geral de alto nível para trabalhar com ML automatizado no estúdio. Os artigos a seguir fornecem instruções detalhadas para trabalhar com modelos específicos de aprendizado de máquina:

- Classificação: Tutorial: Treinar um modelo de classificação com ML automatizado no estúdio

- Previsão de séries temporais: Tutorial: Previsão de demanda com ML automatizado no estúdio

- Processamento de Linguagem Natural (NLP): configurar o ML automatizado para treinar um modelo de PNL (CLI do Azure ou SDK do Python)

- Visão computacional: configure o AutoML para treinar modelos de visão computacional (CLI do Azure ou SDK do Python)

- Regressão: Treine um modelo de regressão com ML automatizado (Python SDK)

Pré-requisitos

Uma subscrição do Azure. Você pode criar uma conta gratuita ou paga para o Azure Machine Learning.

Um espaço de trabalho ou instância de computação do Azure Machine Learning. Para preparar esses recursos, consulte Guia de início rápido: introdução ao Azure Machine Learning.

O ativo de dados a ser usado para o trabalho de treinamento de ML automatizado. Este tutorial descreve como selecionar um ativo de dados existente ou criar um ativo de dados a partir de uma fonte de dados, como um arquivo local, URL da Web ou armazenamento de dados. Para obter mais informações, consulte Criar e gerenciar ativos de dados.

Importante

Há dois requisitos para os dados de treinamento:

- Os dados devem estar em forma de tabela.

- O valor a ser previsto (a coluna de destino ) deve estar presente nos dados.

Criar a experimentação

Crie e execute um experimento seguindo estas etapas:

Entre no estúdio do Azure Machine Learning e selecione sua assinatura e espaço de trabalho.

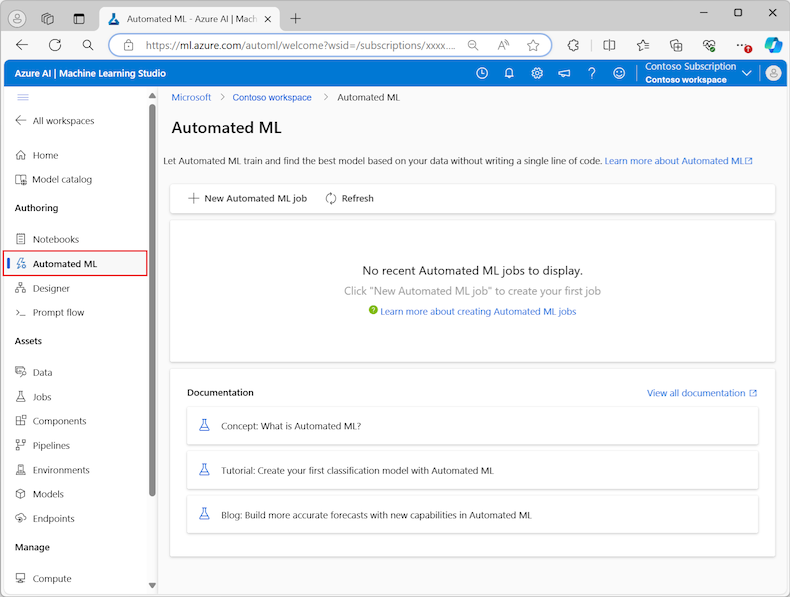

No menu à esquerda, selecione ML automatizado na seção Criação :

A primeira vez que você trabalha com experimentos no estúdio, você vê uma lista vazia e links para a documentação. Caso contrário, você verá uma lista de seus experimentos recentes de ML automatizado, incluindo itens criados com o SDK do Azure Machine Learning.

Selecione Novo trabalho de ML automatizado para iniciar o processo de trabalho Enviar um ML automatizado.

Por padrão, o processo seleciona a opção Train automaticamente na guia Método de treinamento e continua para as definições de configuração.

Na guia Configurações básicas, insira valores para as configurações necessárias, incluindo o Nome do trabalho e o Nome do experimento. Você também pode fornecer valores para as configurações opcionais, conforme desejado.

Selecione Seguinte para continuar.

Identificar ativos de dados

Na guia Tipo de tarefa & dados, especifique o ativo de dados para o experimento e o modelo de aprendizado de máquina a ser usado para treinar os dados.

Neste tutorial, você pode usar um ativo de dados existente ou criar um novo ativo de dados a partir de um arquivo no computador local. As páginas da interface do usuário do estúdio mudam com base na sua seleção para a fonte de dados e o tipo de modelo de treinamento.

Se você optar por usar um ativo de dados existente, poderá continuar na seção Configurar modelo de treinamento.

Para criar um novo ativo de dados, siga estas etapas:

Para criar um novo ativo de dados a partir de um arquivo no computador local, selecione Criar.

Na página Tipo de dados :

- Insira um nome de ativo de dados.

- Para Tipo, selecione Tabela na lista suspensa.

- Selecione Seguinte.

Na página Fonte de dados, selecione De arquivos locais.

O estúdio de aprendizado de máquina adiciona opções extras ao menu esquerdo para você configurar a fonte de dados.

Selecione Avançar para continuar para a página Tipo de armazenamento de destino, onde você especifica o local do Armazenamento do Azure para carregar seu ativo de dados.

Você pode especificar o contêiner de armazenamento padrão criado automaticamente com seu espaço de trabalho ou escolher um contêiner de armazenamento para usar no experimento.

- Para o tipo Datastore, selecione Armazenamento de Blob do Azure.

- Na lista de armazenamentos de dados, selecione workspaceblobstore.

- Selecione Seguinte.

Na página Seleção de arquivos e pastas, use o menu suspenso Carregar arquivos ou pastas e selecione a opção Carregar arquivos ou Carregar pasta.

- Navegue até o local dos dados a serem carregados e selecione Abrir.

- Após o carregamento dos ficheiros, selecione Seguinte.

O estúdio de Machine Learning valida e carrega seus dados.

Nota

Se seus dados estiverem atrás de uma rede virtual, você precisará habilitar a função Ignorar a validação para garantir que o espaço de trabalho possa acessar seus dados. Para obter mais informações, consulte Usar o estúdio do Azure Machine Learning em uma rede virtual do Azure.

Verifique a precisão dos dados carregados na página Configurações . Os campos na página são pré-preenchidos com base no tipo de ficheiro dos seus dados:

Campo Descrição Formato do ficheiro Define o layout e o tipo de dados armazenados em um arquivo. Delimitador Identifica um ou mais caracteres para especificar o limite entre regiões separadas e independentes em texto sem formatação ou outros fluxos de dados. Encoding (Codificação) Identifica qual tabela de esquema de bit a caractere usar para ler seu conjunto de dados. Cabeçalhos de coluna Indica como os cabeçalhos do conjunto de dados, se houver, são tratados. Saltar filas Indica quantas linhas, se houver, são ignoradas no conjunto de dados. Selecione Avançar para continuar na página Esquema . Esta página também é pré-preenchida com base nas suas seleções de Configurações . Você pode configurar o tipo de dados para cada coluna, revisar os nomes das colunas e gerenciar colunas:

- Para alterar o tipo de dados de uma coluna, use o menu suspenso Tipo para selecionar uma opção.

- Para excluir uma coluna do ativo de dados, alterne a opção Incluir para a coluna.

Selecione Avançar para continuar na página Revisão. Reveja o resumo das definições de configuração para a tarefa e, em seguida, selecione Criar.

Configurar modelo de treinamento

Quando o ativo de dados estiver pronto, o estúdio de Aprendizado de Máquina retornará à guia Tipo de tarefa & dados para o processo de trabalho Enviar um ML automatizado. O novo ativo de dados está listado na página.

Siga estas etapas para concluir a configuração do trabalho:

Expanda o menu suspenso Selecionar tipo de tarefa e escolha o modelo de treinamento a ser usado para o experimento. As opções incluem classificação, regressão, previsão de séries temporais, processamento de linguagem natural (PNL) ou visão computacional. Para obter mais informações sobre essas opções, consulte as descrições dos tipos de tarefas suportados.

Depois de especificar o modelo de treinamento, selecione seu conjunto de dados na lista.

Selecione Avançar para continuar na guia Configurações da tarefa .

Na lista suspensa Coluna de destino, selecione a coluna a ser usada para as previsões do modelo.

Dependendo do seu modelo de treinamento, defina as seguintes configurações necessárias:

Classificação: escolha se deseja Habilitar o deep learning.

Previsão de séries temporais: escolha se deseja Ativar o aprendizado profundo e confirme suas preferências para as configurações necessárias:

Use a coluna Tempo para especificar os dados de tempo a serem usados no modelo.

Escolha se deseja ativar uma ou mais opções de Deteção Automática. Ao desmarcar uma opção de deteção automática, como horizonte de previsão de deteção automática, você pode especificar um valor específico. O valor do horizonte de previsão indica quantas unidades de tempo (minutos/horas/dias/semanas/meses/anos) o modelo pode prever para o futuro. Quanto mais para o futuro o modelo é obrigado a prever, menos preciso o modelo se torna.

Para obter mais informações sobre como definir essas configurações, consulte Usar ML automatizado para treinar um modelo de previsão de séries temporais.

Processamento de linguagem natural: confirme suas preferências para as configurações necessárias:

Use a opção Selecionar subtipo para configurar o tipo de subclassificação para o modelo de PNL. Você pode escolher entre Classificação multiclasse, Classificação multirótulo e Reconhecimento de entidade nomeada (NER).

Na seção Configurações de varredura, forneça valores para o fator de folga e o algoritmo de amostragem.

Na seção Espaço de pesquisa, configure o conjunto de opções do algoritmo Modelo.

Para obter mais informações sobre como definir essas configurações, consulte Configurar ML automatizado para treinar um modelo de NLP (CLI DO Azure ou SDK do Python).

Visão computacional: escolha se deseja ativar a varredura manual e confirme suas preferências para as configurações necessárias:

- Use a opção Selecionar subtipo para configurar o tipo de subclassificação para o modelo de visão computacional. Você pode escolher entre Classificação de imagem (Multiclasse) ou (Multirótulo), Deteção de objeto e Polígono (segmentação de instância).

Para obter mais informações sobre como definir essas configurações, consulte Configurar o AutoML para treinar modelos de visão computacional (CLI do Azure ou SDK do Python).

Especificar configurações opcionais

O estúdio de Aprendizado de Máquina fornece configurações opcionais que você pode configurar com base na sua seleção de modelo de aprendizado de máquina. As seções a seguir descrevem as configurações extras.

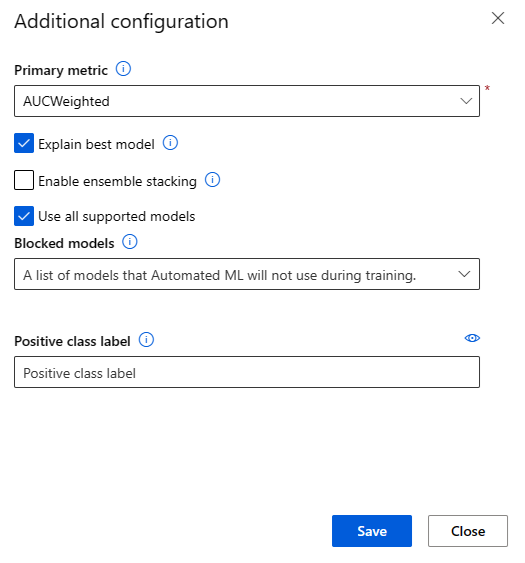

Configurar definições adicionais

Você pode selecionar a opção Exibir definições de configuração adicionais para ver as ações a serem executadas nos dados em preparação para o treinamento.

A página Configuração adicional mostra os valores padrão com base na seleção e nos dados do experimento. Você pode usar os valores padrão ou definir as seguintes configurações:

| Definição | Descrição |

|---|---|

| Métrica primária | Identifique a métrica principal para pontuar seu modelo. Para obter mais informações, consulte métricas de modelo. |

| Ativar empilhamento de conjunto | Permita o aprendizado de conjunto e melhore os resultados do aprendizado de máquina e o desempenho preditivo combinando vários modelos em vez de usar modelos únicos. Para obter mais informações, consulte modelos de conjunto. |

| Utilize todos os modelos suportados | Use esta opção para instruir o ML automatizado se deve usar todos os modelos suportados no experimento. Para obter mais informações, consulte os algoritmos suportados para cada tipo de tarefa. - Selecione esta opção para configurar a configuração Modelos bloqueados. - Desmarque esta opção para definir a configuração Modelos permitidos. |

| Modelos bloqueados | (Disponível quando Usar todos os modelos suportados está selecionado) Use a lista suspensa e selecione os modelos a serem excluídos do trabalho de treinamento. |

| Modelos permitidos | (Disponível quando Usar todos os modelos suportados não está selecionado) Use a lista suspensa e selecione os modelos a serem usados para o trabalho de treinamento. Importante: Disponível apenas para experimentos SDK. |

| Explicar o melhor modelo | Escolha esta opção para mostrar automaticamente a explicabilidade no melhor modelo criado pelo ML automatizado. |

| Rótulo de classe positiva | Insira o rótulo para ML automatizado a ser usado para calcular métricas binárias. |

Definir configurações de featurização

Você pode selecionar a opção Exibir configurações de featurização para ver as ações a serem executadas nos dados em preparação para o treinamento.

A página Featurization mostra técnicas de featurização padrão para suas colunas de dados. Você pode ativar/desativar a featurização automática e personalizar as configurações de featurização automática para seu experimento.

Selecione a opção Ativar featurização para permitir a configuração.

Importante

Quando os dados contêm colunas não numéricas, a featurização está sempre ativada.

Configure cada coluna disponível, conforme desejado. A tabela a seguir resume as personalizações atualmente disponíveis através do estúdio.

Column Personalização Tipo de recurso Altere o tipo de valor da coluna selecionada. Imputar com Selecione o valor com o qual imputar valores ausentes em seus dados.

As configurações de featurização não afetam os dados de entrada necessários para inferência. Se você excluir colunas do treinamento, as colunas excluídas ainda serão necessárias como entrada para inferência no modelo.

Configurar limites para o trabalho

A seção Limites fornece opções de configuração para as seguintes configurações:

| Definição | Descrição | valor |

|---|---|---|

| Máximo de ensaios | Especifique o número máximo de testes a serem tentados durante o trabalho de ML automatizado, onde cada teste tem uma combinação diferente de algoritmo e hiperparâmetros. | Inteiro entre 1 e 1.000 |

| Ensaios simultâneos máximos | Especifique o número máximo de trabalhos de avaliação que podem ser executados em paralelo. | Inteiro entre 1 e 1.000 |

| Nós máximos | Especifique o número máximo de nós que esse trabalho pode usar a partir do destino de computação selecionado. | 1 ou mais, dependendo da configuração de computação |

| Limiar de pontuação métrica | Insira o valor do limite da métrica de iteração. Quando a iteração atinge o limite, o trabalho de treinamento é encerrado. Tenha em mente que os modelos significativos têm uma correlação maior que zero. Caso contrário, o resultado é o mesmo que adivinhar. | Limiar métrico médio, entre limites [0, 10] |

| Tempo limite da experiência (minutos) | Especifique o tempo máximo que todo o experimento pode ser executado. Depois que o experimento atinge o limite, o sistema cancela o trabalho de ML automatizado, incluindo todos os seus testes (trabalhos infantis). | Número de minutos |

| Tempo limite de iteração (minutos) | Especifique o tempo máximo que cada trabalho de avaliação pode ser executado. Depois que o trabalho de avaliação atingir esse limite, o sistema cancelará a avaliação. | Número de minutos |

| Ativar rescisão antecipada | Use esta opção para terminar o trabalho quando a pontuação não estiver melhorando no curto prazo. | Selecione a opção para ativar o fim antecipado do trabalho |

Validar e testar

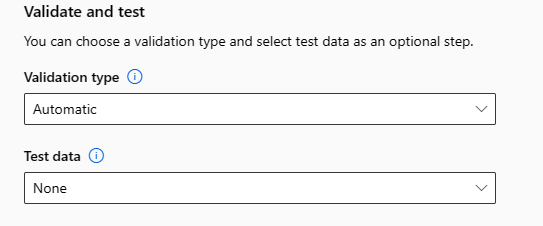

A seção Validar e testar fornece as seguintes opções de configuração:

Especifique o tipo de Validação a ser usado para seu trabalho de treinamento. Se você não especificar explicitamente um

validation_dataoun_cross_validationsparâmetro, o ML automatizado aplicará técnicas padrão dependendo do número de linhas fornecidas no único conjuntotraining_datade dados.Tamanho dos dados de treinamento Técnica de validação Maior que 20.000 linhas É aplicada a divisão de dados de comboio/validação. O padrão é tomar 10% do conjunto de dados de treinamento inicial como o conjunto de validação. Por sua vez, esse conjunto de validação é usado para o cálculo de métricas. Linhas menores que 20.000& É aplicada a abordagem de validação cruzada. O número padrão de dobras depende do número de linhas.

- Conjunto de dados com menos de 1.000 linhas: 10 dobras são usadas

- Conjunto de dados com 1.000 a 20.000 linhas: três dobras são usadasForneça os dados de teste (visualização) para avaliar o modelo recomendado que o ML automatizado gera no final do experimento. Quando você fornece um conjunto de dados de teste, um trabalho de teste é acionado automaticamente no final do experimento. Este trabalho de teste é o único trabalho no melhor modelo recomendado pelo ML automatizado. Para obter mais informações, consulte Exibir resultados do trabalho de teste remoto (visualização).

Importante

Fornecer um conjunto de dados de teste para avaliar os modelos gerados é um recurso de visualização. Esse recurso é um recurso de visualização experimental e pode ser alterado a qualquer momento.

Os dados de teste são considerados separados do treinamento e da validação, e não devem enviesar os resultados do trabalho de teste do modelo recomendado. Para obter mais informações, consulte Treinamento, validação e dados de teste.

Você pode fornecer seu próprio conjunto de dados de teste ou optar por usar uma porcentagem do conjunto de dados de treinamento. Os dados de teste devem estar na forma de um conjunto de dados de tabela do Azure Machine Learning.

O esquema do conjunto de dados de teste deve corresponder ao conjunto de dados de treinamento. A coluna de destino é opcional, mas se nenhuma coluna de destino for indicada, nenhuma métrica de teste será calculada.

O conjunto de dados de teste não deve ser o mesmo que o conjunto de dados de treinamento ou o conjunto de dados de validação.

Os trabalhos de previsão não suportam a divisão de treino/teste.

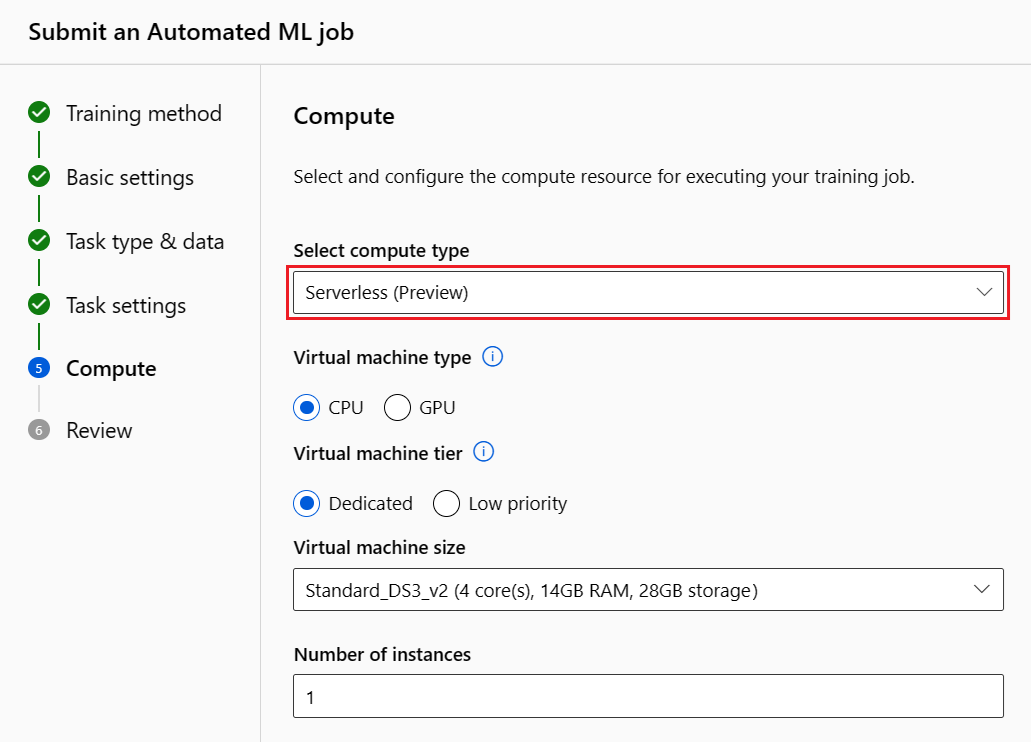

Configurar a computação

Siga estas etapas e configure a computação:

Selecione Avançar para continuar na guia Computação .

Use a lista suspensa Selecionar tipo de computação para escolher uma opção para o trabalho de treinamento e criação de perfil de dados. As opções incluem cluster de computação, instância de computação ou sem servidor.

Depois de selecionar o tipo de computação, a outra interface do usuário na página muda com base na sua seleção:

Sem servidor: as definições de configuração são exibidas na página atual. Continue para a próxima etapa para obter descrições das configurações a serem definidas.

Cluster de computação ou instância de computação: escolha uma das seguintes opções:

Use a lista suspensa Selecionar computação de ML automatizada para selecionar uma computação existente para seu espaço de trabalho e, em seguida, selecione Avançar. Continue para a seção Executar experimento e exibir resultados .

Selecione Novo para criar uma nova instância de computação ou cluster. Esta opção abre a página Criar computação . Continue para a próxima etapa para obter descrições das configurações a serem definidas.

Para uma computação sem servidor ou uma nova computação, defina as configurações necessárias (*):

As definições de configuração diferem dependendo do seu tipo de computação. A tabela a seguir resume as várias configurações que você pode precisar definir:

Campo Descrição Nome do computador Insira um nome exclusivo que identifique seu contexto de computação. Location Especifique a região da máquina. Prioridade da máquina virtual As máquinas virtuais de baixa prioridade são mais baratas, mas não garantem os nós de computação. Tipo de máquina virtual Selecione CPU ou GPU para o tipo de máquina virtual. Camada de máquina virtual Selecione a prioridade para seu experimento. Tamanho da máquina virtual Selecione o tamanho da máquina virtual para sua computação. Nós Min / Max Para criar um perfil, você deve especificar um ou mais nós. Insira o número máximo de nós para sua computação. O padrão é seis nós para uma computação do Azure Machine Learning. Segundos ociosos antes de reduzir a escala Especifique o tempo ocioso antes que o cluster seja automaticamente reduzido para a contagem mínima de nós. Definições avançadas Essas configurações permitem que você configure uma conta de usuário e uma rede virtual existente para seu experimento. Depois de definir as configurações necessárias, selecione Avançar ou Criar, conforme apropriado.

A criação de um novo cálculo pode levar alguns minutos. Quando a criação for concluída, selecione Avançar.

Executar experiências e ver resultados

Selecione Concluir para executar seu experimento. O processo de preparação da experimentação pode demorar até 10 minutos. As tarefas de preparação podem demorar mais 2 ou 3 minutos para cada pipeline concluir a execução. Se você especificou para gerar o painel RAI para o melhor modelo recomendado, pode levar até 40 minutos.

Nota

Os algoritmos que o ML automatizado emprega têm aleatoriedade inerente que pode causar uma pequena variação na pontuação final das métricas de um modelo recomendado, como a precisão. O ML automatizado também realiza operações em dados como divisão comboio-ensaio, divisão comboio-validação ou validação cruzada, conforme necessário. Se você executar um experimento com as mesmas definições de configuração e métrica primária várias vezes, provavelmente verá variação na pontuação final de cada experimento devido a esses fatores.

Ver detalhes da experimentação

A tela Detalhes do Trabalho é aberta na guia Detalhes . Esta tela mostra um resumo do trabalho de experimento, incluindo uma barra de status na parte superior ao lado do número do trabalho.

O separadorModelos contém uma lista dos modelos criados encomendados pela pontuação de métrica. Por predefinição, o modelo com a classificação mais alta com base na métrica escolhida está no topo da lista. À medida que o trabalho de treinamento tenta mais modelos, os modelos exercitados são adicionados à lista. Use essa abordagem para obter uma comparação rápida das métricas dos modelos produzidos até agora.

Ver detalhes do trabalho de formação

Analise detalhadamente qualquer um dos modelos concluídos para obter os detalhes do trabalho de treinamento. Você pode ver gráficos de métricas de desempenho para modelos específicos na guia Métricas . Para obter mais informações, consulte Avaliar resultados de experimentos de aprendizado de máquina automatizados. Nesta página, você também pode encontrar detalhes sobre todas as propriedades do modelo, juntamente com o código associado, trabalhos filhos e imagens.

Exibir resultados de trabalhos de teste remotos (visualização)

Se você especificou um conjunto de dados de teste ou optou por uma divisão de trem/teste durante a configuração do experimento no formulário Validar e testar, o ML automatizado testa automaticamente o modelo recomendado por padrão. Como resultado, o ML automatizado calcula métricas de teste para determinar a qualidade do modelo recomendado e suas previsões.

Importante

Testar seus modelos com um conjunto de dados de teste para avaliar os modelos gerados é um recurso de visualização. Esse recurso é um recurso de visualização experimental e pode ser alterado a qualquer momento.

Esse recurso não está disponível para os seguintes cenários de ML automatizado:

Siga estas etapas para exibir as métricas do trabalho de teste do modelo recomendado:

No estúdio, navegue até a página Modelos e selecione o melhor modelo.

Selecione a guia Resultados do teste (visualização).

Selecione o trabalho desejado e visualize a guia Métricas :

Exiba as previsões de teste usadas para calcular as métricas de teste seguindo estas etapas:

Na parte inferior da página, selecione o link em Conjunto de dados de saídas para abrir o conjunto de dados.

Na página Conjuntos de Dados, selecione a guia Explorar para exibir as previsões do trabalho de teste.

O arquivo de previsão também pode ser visualizado e baixado da guia Saídas + logs . Expanda a pasta Previsões para localizar o arquivo prediction.csv .

O trabalho de teste de modelo gera o arquivo de predictions.csv armazenado no armazenamento de dados padrão criado com o espaço de trabalho. Esse armazenamento de dados é visível para todos os usuários com a mesma assinatura. Os trabalhos de teste não são recomendados para cenários se alguma das informações usadas ou criadas pelo trabalho de teste precisar permanecer privada.

Testar o modelo de ML automatizado existente (visualização)

Após a conclusão do experimento, você pode testar os modelos que o ML automatizado gera para você.

Importante

Testar seus modelos com um conjunto de dados de teste para avaliar os modelos gerados é um recurso de visualização. Esse recurso é um recurso de visualização experimental e pode ser alterado a qualquer momento.

Esse recurso não está disponível para os seguintes cenários de ML automatizado:

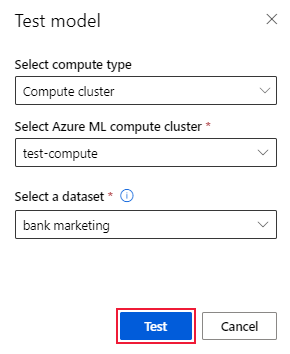

Se você quiser testar um modelo diferente gerado por ML automatizado, e não o modelo recomendado, siga estas etapas:

Selecione um trabalho de experimento de ML automatizado existente.

Navegue até a guia Modelos do trabalho e selecione o modelo concluído que deseja testar.

Na página Detalhes do modelo, selecione a opção Modelo de teste (visualização) para abrir o painel Modelo de teste.

No painel Modelo de teste, selecione o cluster de computação e um conjunto de dados de teste que você deseja usar para seu trabalho de teste.

Selecione a opção Testar . O esquema do conjunto de dados de teste deve corresponder ao conjunto de dados de treinamento, mas a coluna Destino é opcional.

Após a criação bem-sucedida do trabalho de teste do modelo, a página Detalhes exibe uma mensagem de sucesso. Selecione a guia Resultados do teste para ver o progresso do trabalho.

Para exibir os resultados do trabalho de teste, abra a página Detalhes e siga as etapas na seção Exibir resultados do trabalho de teste remoto (visualização).

Painel de IA responsável (visualização)

Para entender melhor seu modelo, você pode ver vários insights sobre seu modelo usando o painel de IA responsável. Essa interface do usuário permite que você avalie e depure seu melhor modelo de ML automatizado. O painel de IA responsável avalia erros de modelo e problemas de equidade, diagnostica por que os erros estão acontecendo avaliando seus dados de trem e/ou teste e observando as explicações do modelo. Juntos, esses insights podem ajudá-lo a construir confiança com seu modelo e passar nos processos de auditoria. Não é possível gerar painéis de IA responsáveis para um modelo de ML automatizado existente. O painel é criado apenas para o melhor modelo recomendado quando um novo trabalho de ML automatizado é criado. Os usuários devem continuar a usar as Explicações do modelo (visualização) até que o suporte seja fornecido para os modelos existentes.

Gere um painel de IA responsável para um modelo específico seguindo estas etapas:

Ao enviar um trabalho de ML automatizado, vá para a seção Configurações de tarefa no menu à esquerda e selecione a opção Exibir definições de configuração adicionais.

Na página Configuração adicional, selecione a opção Explicar melhor modelo:

Alterne para a guia Computação e selecione a opção Sem servidor para sua computação:

Após a conclusão da operação, navegue até a página Modelos do seu trabalho de ML automatizado, que contém uma lista de seus modelos treinados. Selecione o link Exibir painel de IA responsável:

O painel de IA responsável aparece para o modelo selecionado:

No painel, você vê quatro componentes ativados para o seu melhor modelo de ML automatizado:

Componente O que mostra o componente? Como ler o gráfico? Análise de erros Use a análise de erros quando precisar:

- Obter uma compreensão profunda de como as falhas do modelo são distribuídas em um conjunto de dados e em várias dimensões de entrada e recurso.

- Divida as métricas de desempenho agregadas para descobrir automaticamente coortes errôneas, a fim de informar suas etapas de mitigação direcionadas.Gráficos de análise de erros Visão geral do modelo e equidade Use este componente para:

- Obtenha uma compreensão profunda do desempenho do seu modelo em diferentes coortes de dados.

- Compreenda os problemas de equidade do seu modelo observando as métricas de disparidade. Essas métricas podem avaliar e comparar o comportamento do modelo entre subgrupos identificados em termos de recursos confidenciais (ou não confidenciais).Visão geral do modelo e gráficos de equidade Explicações do modelo Use o componente de explicação do modelo para gerar descrições compreensíveis por humanos das previsões de um modelo de aprendizado de máquina observando:

- Explicações globais: Por exemplo, quais características afetam o comportamento geral de um modelo de alocação de empréstimos?

- Explicações locais: Por exemplo, por que o pedido de empréstimo de um cliente foi aprovado ou rejeitado?Gráficos de explicabilidade do modelo Análise de Dados Use a análise de dados quando precisar:

- Explore suas estatísticas de conjunto de dados selecionando diferentes filtros para fatiar seus dados em diferentes dimensões (também conhecidas como coortes).

- Compreender a distribuição do seu conjunto de dados em diferentes coortes e grupos de recursos.

- Determine se suas descobertas relacionadas à equidade, análise de erros e causalidade (derivadas de outros componentes do painel) são resultado da distribuição do seu conjunto de dados.

- Decidir em quais áreas coletar mais dados para mitigar erros que vêm de problemas de representação, ruído de rótulo, ruído de recurso, viés de rótulo e fatores semelhantes.Gráficos do Data Explorer Você pode ainda criar coortes (subgrupos de pontos de dados que compartilham características especificadas) para concentrar sua análise de cada componente em coortes diferentes. O nome da coorte atualmente aplicada ao painel é sempre mostrado no canto superior esquerdo do painel. A visualização padrão em seu painel é todo o seu conjunto de dados, intitulado Todos os dados por padrão. Para obter mais informações, consulte Controles globais para seu painel.

Editar e enviar trabalhos (visualização)

Em cenários em que você deseja criar um novo experimento com base nas configurações de um experimento existente, o ML automatizado fornece a opção Editar e enviar na interface do usuário do estúdio. Essa funcionalidade é limitada a experimentos iniciados a partir da interface do usuário do estúdio e requer que o esquema de dados para o novo experimento corresponda ao do experimento original.

Importante

A capacidade de copiar, editar e enviar um novo experimento com base em um experimento existente é um recurso de visualização. Esse recurso é um recurso de visualização experimental e pode ser alterado a qualquer momento.

A opção Editar e enviar abre o assistente Criar um novo trabalho de ML automatizado com as configurações de dados, computação e experimento pré-preenchidas. Você pode configurar as opções em cada guia do assistente e editar seleções conforme necessário para seu novo experimento.

Implementar o modelo

Depois de ter o melhor modelo, você pode implantá-lo como um serviço Web para prever novos dados.

Nota

Para implantar um modelo gerado por meio do automl pacote com o Python SDK, você deve registrar seu modelo) no espaço de trabalho.

Depois de registrar o modelo, você pode localizá-lo no estúdio selecionando Modelos no menu à esquerda. Na página de visão geral do modelo, você pode selecionar a opção Implantar e continuar para a Etapa 2 nesta seção.

O ML automatizado ajuda a implantar o modelo sem escrever código.

Inicie a implantação usando um dos seguintes métodos:

Implante o melhor modelo com os critérios de métrica definidos:

Após a conclusão do experimento, selecione Trabalho 1 e navegue até a página do trabalho pai.

Selecione o modelo listado na seção Resumo do melhor modelo e, em seguida, selecione Implantar.

Implante uma iteração de modelo específica a partir deste experimento:

- Selecione o modelo desejado na guia Modelos e, em seguida, selecione Implantar.

Povoe o painel Implementar modelo:

Campo Valor Nome Insira um nome exclusivo para sua implantação. Descrição Insira uma descrição para identificar melhor a finalidade da implantação. Tipo de computação Selecione o tipo de ponto de extremidade que deseja implantar: Serviço Kubernetes do Azure (AKS) ou Instância de Contêiner do Azure (ACI). Nome do computador (Aplica-se apenas ao AKS) Selecione o nome do cluster AKS no qual deseja implantar. Ativar autenticação Selecione esta opção para permitir a autenticação baseada em token ou em chave. Usar ativos de implantação personalizados Habilite ativos personalizados se quiser carregar seu próprio script de pontuação e arquivo de ambiente. Caso contrário, o ML automatizado fornece esses ativos para você por padrão. Para obter mais informações, consulte Implantar e pontuar um modelo de aprendizado de máquina usando um ponto de extremidade online. Importante

Os nomes dos ficheiros devem ter entre 1 e 32 caracteres. O nome deve começar e terminar com alfanuméricos e pode incluir traços, sublinhados, pontos e alfanuméricos entre eles. Não são permitidos espaços.

O menu Avançado oferece recursos de implantação padrão, como coleta de dados e configurações de utilização de recursos. Você pode usar as opções neste menu para substituir esses padrões. Para obter mais informações, consulte Monitorar pontos de extremidade online.

Selecione Implementar. A conclusão da implementação pode demorar cerca de 20 minutos.

Após o início da implantação, a guia Resumo do modelo é aberta. Você pode monitorar o progresso da implantação na seção Status da implantação .

Agora, tem um serviço Web operacional para gerar predições! Você pode testar as previsões consultando o serviço a partir dos exemplos de IA de ponta a ponta no Microsoft Fabric.