Como criar uma definição de trabalho do Apache Spark na malha

Neste tutorial, saiba como criar uma definição de trabalho do Spark no Microsoft Fabric.

Pré-requisitos

Antes de começar, vai precisar do:

- Uma conta de locatário do Fabric com uma assinatura ativa. Crie uma conta gratuitamente.

Gorjeta

Para executar o item de definição de trabalho do Spark, você deve ter um arquivo de definição principal e um contexto de lakehouse padrão. Se você não tem uma casa de lago, você pode criar uma seguindo as etapas em Criar uma casa de lago.

Criar uma definição de trabalho do Spark

O processo de criação de definição de emprego do Spark é rápido e simples; Há várias maneiras de começar.

Opções para criar uma definição de trabalho do Spark

Há algumas maneiras de começar com o processo de criação:

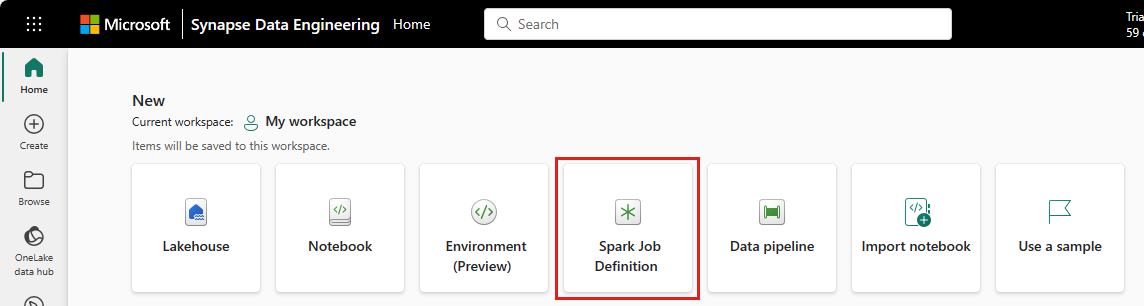

Página inicial de engenharia de dados: você pode criar facilmente uma definição de trabalho do Spark por meio do cartão Definição de trabalho do Spark na seção Novo na página inicial.

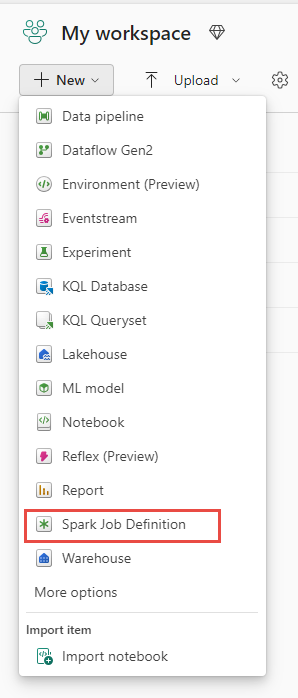

Modo de exibição Espaço de trabalho: você também pode criar uma definição de trabalho do Spark por meio do Espaço de trabalho em Engenharia de Dados usando o menu suspenso Novo .

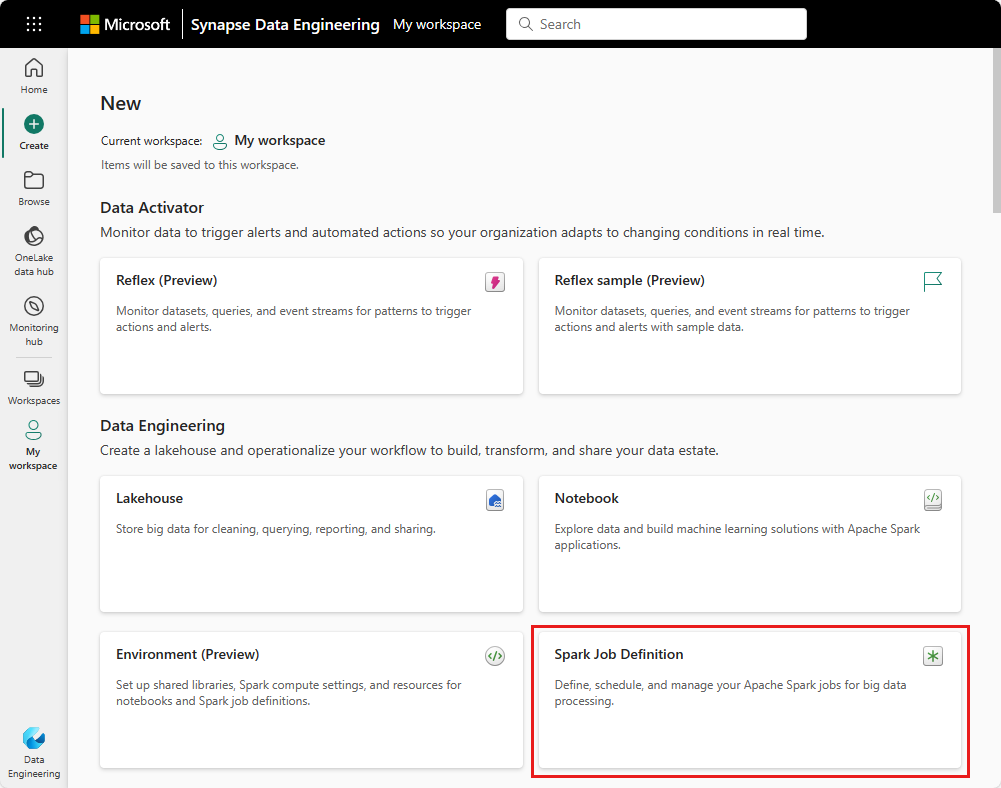

Criar modo de exibição: outro ponto de entrada para criar uma definição de trabalho do Spark é a página Criar em Engenharia de Dados.

Você precisa dar um nome à sua definição de trabalho do Spark ao criá-la. O nome deve ser exclusivo dentro do espaço de trabalho atual. A nova definição de trabalho do Spark é criada no seu espaço de trabalho atual.

Criar uma definição de trabalho do Spark para o PySpark (Python)

Para criar uma definição de trabalho do Spark para o PySpark:

Baixe o arquivo Parquet de exemplo yellow_tripdata_2022-01.parquet e carregue-o para a seção de arquivos da casa do lago.

Crie uma nova definição de trabalho do Spark.

Selecione PySpark (Python) na lista suspensa Linguagem .

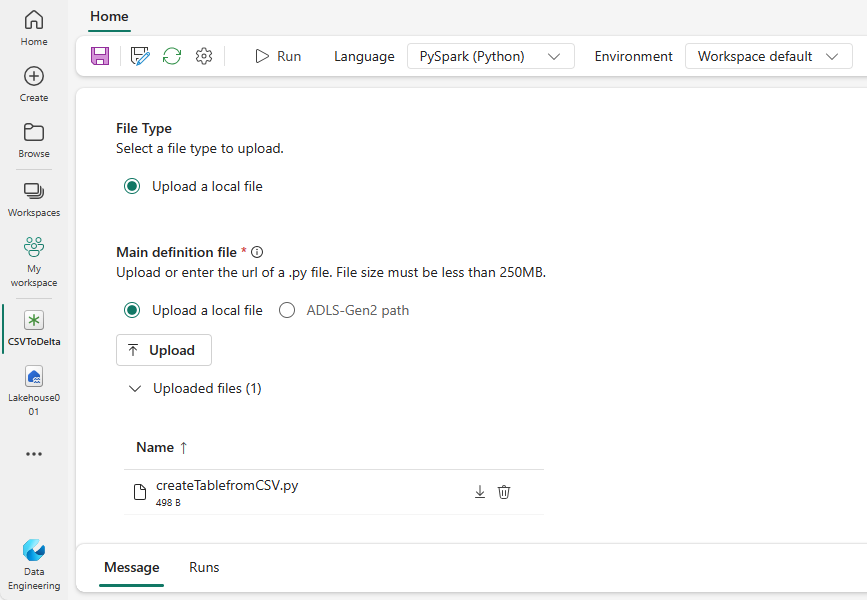

Faça o download do exemplo de createTablefromParquet.py e carregue-o como o arquivo de definição principal. O arquivo de definição principal (job. Main) é o arquivo que contém a lógica do aplicativo e é obrigatório para executar um trabalho do Spark. Para cada definição de trabalho do Spark, você só pode carregar um arquivo de definição principal.

Você pode carregar o arquivo de definição principal de sua área de trabalho local ou pode carregar de um Azure Data Lake Storage (ADLS) Gen2 existente fornecendo o caminho ABFSS completo do arquivo. Por exemplo,

abfss://your-storage-account-name.dfs.core.windows.net/your-file-path.Carregue arquivos de referência como arquivos .py . Os arquivos de referência são os módulos python que são importados pelo arquivo de definição principal. Assim como o arquivo de definição principal, você pode fazer upload de sua área de trabalho ou de um ADLS Gen2 existente. Vários arquivos de referência são suportados.

Gorjeta

Se você usar um caminho ADLS Gen2, para garantir que o arquivo esteja acessível, deverá conceder à conta de usuário que executa o trabalho a permissão adequada para a conta de armazenamento. Sugerimos duas maneiras diferentes de fazer isso:

- Atribua à conta de usuário uma função de Colaborador para a conta de armazenamento.

- Conceda permissão de Leitura e Execução à conta de usuário do arquivo por meio da Lista de Controle de Acesso (ACL) ADLS Gen2.

Para uma execução manual, a conta do usuário de login atual é usada para executar o trabalho.

Forneça argumentos de linha de comando para o trabalho, se necessário. Use um espaço como um divisor para separar os argumentos.

Adicione a referência lakehouse ao trabalho. Você deve ter pelo menos uma referência de lakehouse adicionada ao trabalho. Esta casa do lago é o contexto padrão da casa do lago para o trabalho.

Várias referências lakehouse são suportadas. Encontre o nome não padrão da casa do lago e o URL completo do OneLake na página Configurações do Spark.

Criar uma definição de trabalho do Spark para Scala/Java

Para criar uma definição de trabalho do Spark para Scala/Java:

Crie uma nova definição de trabalho do Spark.

Selecione Spark(Scala/Java) na lista suspensa Idioma .

Carregue o arquivo de definição principal como um arquivo .jar . O arquivo de definição principal é o arquivo que contém a lógica do aplicativo desse trabalho e é obrigatório para executar um trabalho do Spark. Para cada definição de trabalho do Spark, você só pode carregar um arquivo de definição principal. Forneça o nome da classe Principal.

Carregue arquivos de referência como arquivos .jar . Os arquivos de referência são os arquivos que são referenciados/importados pelo arquivo de definição principal.

Forneça argumentos de linha de comando para o trabalho, se necessário.

Adicione a referência lakehouse ao trabalho. Você deve ter pelo menos uma referência de lakehouse adicionada ao trabalho. Esta casa do lago é o contexto padrão da casa do lago para o trabalho.

Criar uma definição de trabalho do Spark para R

Para criar uma definição de trabalho do Spark para o SparkR(R):

Crie uma nova definição de trabalho do Spark.

Selecione SparkR(R) na lista suspensa Idioma .

Carregue o arquivo de definição principal como um arquivo . Arquivo R . O arquivo de definição principal é o arquivo que contém a lógica do aplicativo desse trabalho e é obrigatório para executar um trabalho do Spark. Para cada definição de trabalho do Spark, você só pode carregar um arquivo de definição principal.

Carregue arquivos de referência como . Arquivos R . Os arquivos de referência são os arquivos que são referenciados/importados pelo arquivo de definição principal.

Forneça argumentos de linha de comando para o trabalho, se necessário.

Adicione a referência lakehouse ao trabalho. Você deve ter pelo menos uma referência de lakehouse adicionada ao trabalho. Esta casa do lago é o contexto padrão da casa do lago para o trabalho.

Nota

A definição de trabalho do Spark será criada no seu espaço de trabalho atual.

Opções para personalizar as definições de trabalho do Spark

Existem algumas opções para personalizar ainda mais a execução das definições de trabalho do Spark.

- Computação do Spark: Na guia Computação do Spark , você pode ver a Versão do Tempo de Execução, que é a versão do Spark que será usada para executar o trabalho. Você também pode ver as definições de configuração do Spark que serão usadas para executar o trabalho. Você pode personalizar as definições de configuração do Spark clicando no botão Adicionar .

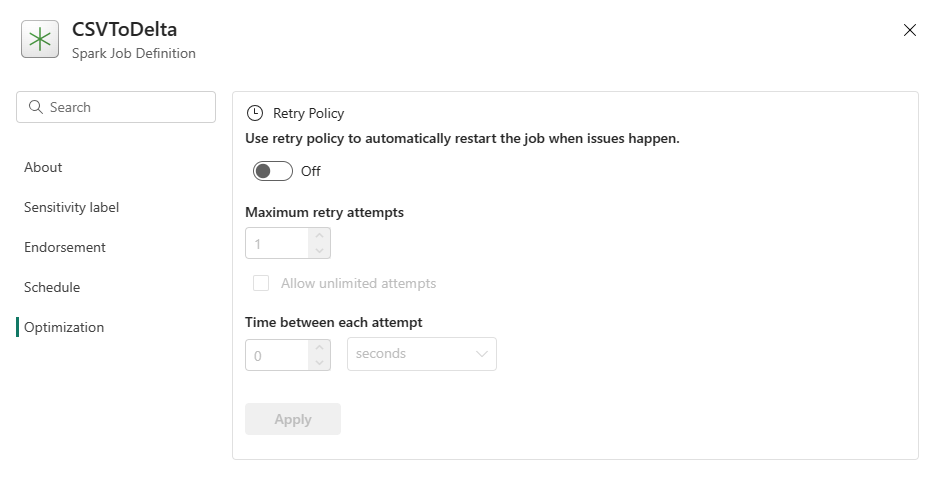

Otimização: na guia Otimização , você pode habilitar e configurar a Política de Repetição para o trabalho. Quando habilitado, o trabalho é repetido se falhar. Você também pode definir o número máximo de novas tentativas e o intervalo entre as tentativas. Para cada tentativa de repetição, o trabalho é reiniciado. Certifique-se de que o trabalho é idempotente.