Мониторинг действия копирования

ОБЛАСТЬ ПРИМЕНЕНИЯ:  Фабрика данных Azure

Фабрика данных Azure  Azure Synapse Analytics

Azure Synapse Analytics

Совет

Попробуйте использовать фабрику данных в Microsoft Fabric, решение для аналитики с одним интерфейсом для предприятий. Microsoft Fabric охватывает все, от перемещения данных до обработки и анализа данных в режиме реального времени, бизнес-аналитики и отчетности. Узнайте, как бесплатно запустить новую пробную версию !

В этой статье описано, как контролировать выполнение операций копирования в конвейеры Фабрики данных Azure и Synapse. Это продолжение статьи об обзоре действия копирования, в которой представлены общие сведения о действии копирования. Вы также можете отслеживать действия копирования, созданные с помощью Средство копирования данных, а также Удалять действия, используя тот же подход.

Визуальный мониторинг

Создав и опубликовав конвейер, можно связать его с триггером или вручную запустить прямое выполнение. В пользовательском интерфейсе по умолчанию можно отслеживать все выполнения конвейера. Сведения о мониторинге Фабрики данных Azure в целом см. в статье Визуальный мониторинг конвейеров Фабрики данных Azure и Azure Synapse.

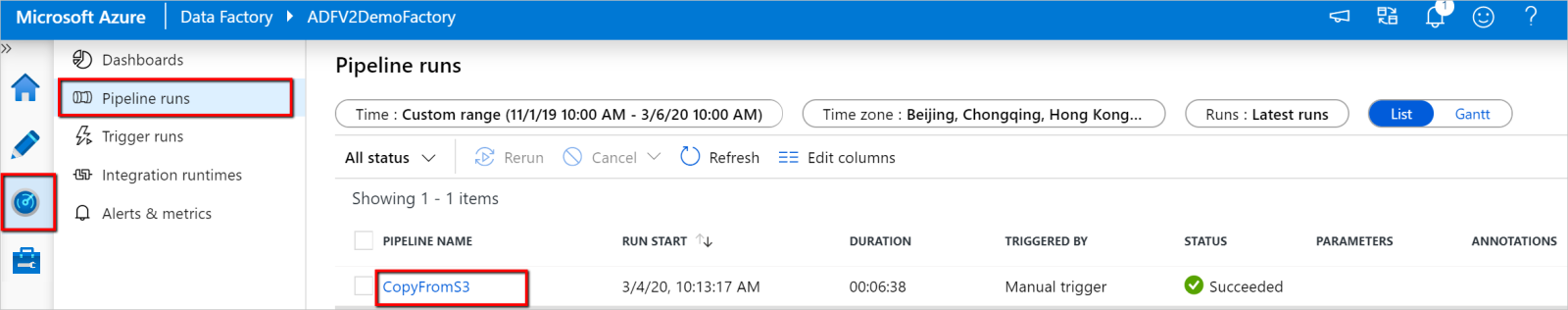

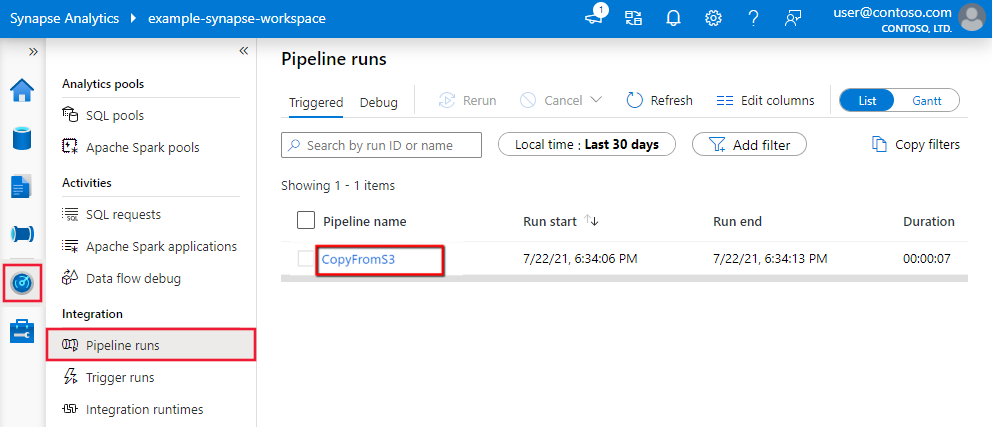

Чтобы отслеживать выполнение действия Copy, перейдите в раздел Data Factory Studio или пользовательский интерфейс Azure Synapse Studio для своего экземпляра службы. На вкладке Монитор, где отображается список выполнений конвейера, щелкните ссылку с именем конвейера, чтобы получить доступ к списку выполнения действий в рамках выполнения конвейера.

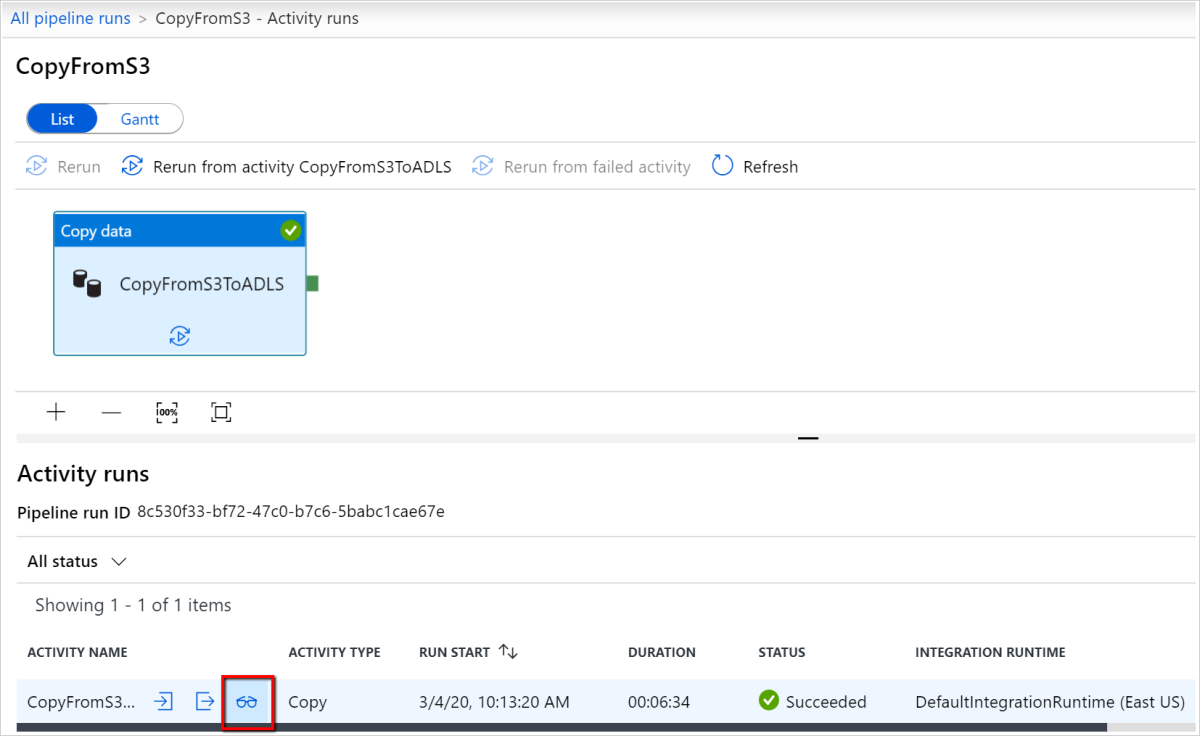

На этом уровне можно просмотреть ссылки на входные данные, выходные данные и ошибки действия Copy (если не удается выполнить действие Copy), а также статистику, например длительность или состояние. Если нажать кнопку Сведения (в виде очков) рядом с именем действия Copy, вы получите подробные сведения о выполнении действия копирования.

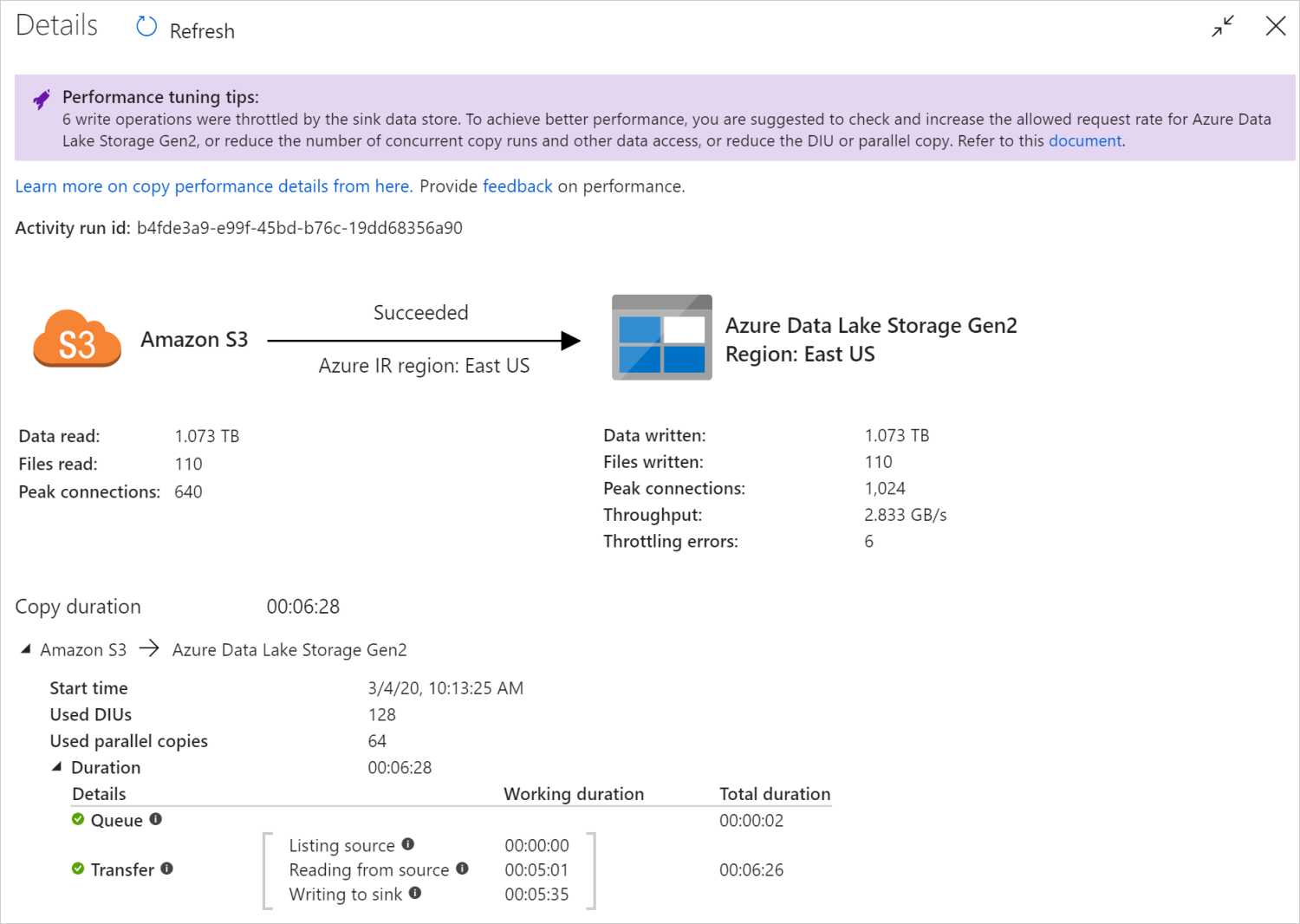

В этом графическом представлении мониторинга служба предоставляет сведения о выполнении действия копирования, включая объем чтения и записи данных, число файлов и строк данных, скопированных из источника в приемник, пропускную способность, конфигурации, применяемые для сценария копирования, этапы, выполняемые действием копирования, с учетом соответствующих длительностей и сведений и т. д. Возможные метрики и их подробное описание см. в этой таблице.

В некоторых сценариях при выполнении действия Copy вы увидите Советы по настройке производительности в верхней части окна мониторинга действия Copy, как показано в примере. Советы указывают на узкие места, выявленные службой для конкретного выполнения операции Copy, а также дают рекомендации по внесению изменений для увеличения пропускной способности копирования. Дополнительные сведения об автоматической настройке производительности.

В нижней части окна сведений о выполнении и длительности описываются основные этапы, которые выполняются в ходе действия Copy, что особенно полезно для устранения неполадок с производительностью копирования. Узким местом при выполнении копирования является операция с самой большой длительностью. Дополнительные сведения см. в статье Устранение неполадок с производительностью действий копирования, где подробно описан каждый этап и приведено руководство по устранению неполадок.

Пример. Копирование из Amazon S3 в Azure Data Lake Storage 2-го поколения

Мониторинг при помощи программных средств

Сведения о выполнении действия Copy и характеристики производительности также возвращаются в раздел Результат выполнения действия Copy>Выходные данные, который используется для визуализации окна мониторинга пользовательского интерфейса. Ниже приведен полный список свойств, которые могут быть возвращены. Вы увидите только те свойства, которые применимы к сценарию копирования. Сведения о программном мониторинге выполнения действий в целом см. в разделе Программный мониторинг конвейеров Фабрики данных Azure и Azure Synapse.

| Имя свойства | Description | Единица в выходных данных |

|---|---|---|

| dataRead | Фактический объем данных, прочитанных из источника. | Значение Int64 в байтах |

| dataWritten | Фактический объем данных, записанных или зафиксированных в приемнике. Размер может отличаться от размера dataRead, так как он связан с процессом хранения данных в каждом хранилище. |

Значение Int64 в байтах |

| filesRead | Количество файлов, считанных из файлового источника. | Значение Int64 (не единица измерения) |

| filesWritten | Число файлов, записываемых в файловый приемник/фиксируемых в нем. | Значение Int64 (не единица измерения) |

| filesSkipped | Количество файлов, пропущенных в файловом источнике. | Значение Int64 (не единица измерения) |

| dataConsistencyVerification | Сведения о проверке согласованности данных, которые позволяют узнать, была ли проведена проверка согласованности скопированных данных между исходным и целевым хранилищами. Дополнительные сведения см. в этой статье. | Массив |

| sourcePeakConnections | Пиковое число одновременных подключений к хранилищу данных источника при выполнении действия Copy. | Значение Int64 (не единица измерения) |

| sinkPeakConnections | Пиковое число одновременных подключений к хранилищу данных приемника при выполнении действия Copy. | Значение Int64 (не единица измерения) |

| rowsRead | Число строк, считанных из источника. Эта метрика не применяется при копировании файлов как есть без анализа, например, если наборы данных источника и приемника имеют двоичный тип или иной формат с идентичными параметрами. | Значение Int64 (не единица измерения) |

| rowsCopied | Число строк, скопированных в приемник. Эта метрика не применяется при копировании файлов как есть без анализа, например, если наборы данных источника и приемника имеют двоичный тип или иной формат с идентичными параметрами. | Значение Int64 (не единица измерения) |

| rowsSkipped | Число пропущенных несовместимых строк. Можно включить пропуск несовместимых строк, задав для enableSkipIncompatibleRow значение true. |

Значение Int64 (не единица измерения) |

| copyDuration | Длительность выполнения копирования. | Значение Int32 в секундах |

| throughput | Скорость передачи данных, вычисленная делением dataRead на copyDuration. |

Число с плавающей запятой, КБ/с |

| sourcePeakConnections | Пиковое число одновременных подключений к хранилищу данных источника при выполнении действия Copy. | Значение Int32 (без единицы измерения) |

| sinkPeakConnections | Пиковое число одновременных подключений к хранилищу данных приемника при выполнении действия Copy. | Значение Int32 (без единицы измерения) |

| sqlDwPolyBase | Используется ли PolyBase при копировании данных в Azure Synapse Analytics. | Логический |

| redshiftUnload | Используется ли UNLOAD при копировании данных из Redshift. | Логический |

| hdfsDistcp | Используется ли DistCp при копировании данных из HDFS. | Логический |

| effectiveIntegrationRuntime | Среда выполнения интеграции (IR) или среды выполнения, используемые для выполнения действия, в формате <IR name> (<region if it's Azure IR>). |

Текст (string) |

| usedDataIntegrationUnits | Единицы интеграции актуальных данных во время копирования. | Значение Int32 |

| usedParallelCopies | Использованное количество параллельных процессов копирования. | Значение Int32 |

| logPath | Путь к журналу сессий пропущенных данных в хранилище больших двоичных объектов. См. Отказоустойчивость. | Текст (string) |

| executionDetails | Дополнительные сведения о стадиях, которые проходит действие Copy, с указанием всех шагов, длительности, конфигураций и т. п. Мы не рекомендуем анализировать этот раздел, так как он может измениться. Чтобы лучше разобраться, как он помогает понимать и устранять проблемы с производительностью копирования, см. раздел Визуальный мониторинг. | Массив |

| perfRecommendation | Советы по настройке производительности копирования. Дополнительные сведения см. в разделе Советы по настройке производительности. | Массив |

| billingReference | Потребление платных ресурсов за конкретное выполнение. Дополнительные сведения см. в статье Мониторинг потребления на уровне выполнения действий. | Object |

| durationInQueue | Длительность пребывания в очереди в секундах перед началом выполнения действия Copy. | Object |

Пример:

"output": {

"dataRead": 1180089300500,

"dataWritten": 1180089300500,

"filesRead": 110,

"filesWritten": 110,

"filesSkipped": 0,

"sourcePeakConnections": 640,

"sinkPeakConnections": 1024,

"copyDuration": 388,

"throughput": 2970183,

"errors": [],

"effectiveIntegrationRuntime": "DefaultIntegrationRuntime (East US)",

"usedDataIntegrationUnits": 128,

"billingReference": "{\"activityType\":\"DataMovement\",\"billableDuration\":[{\"Managed\":11.733333333333336}]}",

"usedParallelCopies": 64,

"dataConsistencyVerification":

{

"VerificationResult": "Verified",

"InconsistentData": "None"

},

"executionDetails": [

{

"source": {

"type": "AmazonS3"

},

"sink": {

"type": "AzureBlobFS",

"region": "East US",

"throttlingErrors": 6

},

"status": "Succeeded",

"start": "2020-03-04T02:13:25.1454206Z",

"duration": 388,

"usedDataIntegrationUnits": 128,

"usedParallelCopies": 64,

"profile": {

"queue": {

"status": "Completed",

"duration": 2

},

"transfer": {

"status": "Completed",

"duration": 386,

"details": {

"listingSource": {

"type": "AmazonS3",

"workingDuration": 0

},

"readingFromSource": {

"type": "AmazonS3",

"workingDuration": 301

},

"writingToSink": {

"type": "AzureBlobFS",

"workingDuration": 335

}

}

}

},

"detailedDurations": {

"queuingDuration": 2,

"transferDuration": 386

}

}

],

"perfRecommendation": [

{

"Tip": "6 write operations were throttled by the sink data store. To achieve better performance, you are suggested to check and increase the allowed request rate for Azure Data Lake Storage Gen2, or reduce the number of concurrent copy runs and other data access, or reduce the DIU or parallel copy.",

"ReferUrl": "https://go.microsoft.com/fwlink/?linkid=2102534 ",

"RuleName": "ReduceThrottlingErrorPerfRecommendationRule"

}

],

"durationInQueue": {

"integrationRuntimeQueue": 0

}

}

Связанный контент

См. другие статьи о действиях копирования: