Комплексный сценарий Lakehouse: обзор и архитектура

Microsoft Fabric — это единое решение для аналитики для предприятий, охватывающих все, от перемещения данных до обработки и анализа данных, аналитики в режиме реального времени и бизнес-аналитики. Он предлагает полный набор служб, включая озера данных, инженерию данных и интеграцию данных, все в одном месте. Дополнительные сведения см. в статье "Что такое Microsoft Fabric?"

В этом руководстве описывается комплексный сценарий получения данных до потребления данных. Это поможет вам создать базовое представление о Fabric, включая различные интерфейсы и их интеграцию, а также профессиональный и гражданский опыт разработчиков, которые приходят с работой на этой платформе. Это руководство не предназначено для эталонной архитектуры, исчерпывающего списка функций и функций или рекомендаций по конкретным рекомендациям.

Комплексный сценарий Lakehouse

Традиционно организации строят современные хранилища данных для своих транзакционных и структурированных потребностей в аналитике данных. И озера данных для аналитики больших данных (полуструктурированных) данных. Эти две системы работали параллельно, создавая силосы, дублирование данных и увеличивая общую стоимость владения.

Структура с объединением хранилища данных и стандартизации в формате Delta Lake позволяет исключить силосы, удалить дублирование данных и резко сократить общую стоимость владения.

Благодаря гибкости, предоставляемой Fabric, вы можете реализовать архитектуры lakehouse или хранилища данных или объединить их вместе, чтобы получить лучшие возможности как с простой реализацией. В этом руководстве вы собираетесь взять пример розничной организации и создать его lakehouse с начала до конца. В нем используется архитектура медальона, в которой бронзовый слой содержит необработанные данные, серебряный слой имеет проверенные и дедупликированные данные, а золотой слой имеет высокоуровневые данные. Вы можете использовать тот же подход, чтобы реализовать lakehouse для любой организации из любой отрасли.

В этом руководстве объясняется, как разработчик в вымышленной компании Wide World Importers из розничного домена выполняет следующие действия:

Войдите в свою учетную запись Power BI и зарегистрируйтесь на бесплатную пробную версию Microsoft Fabric. Если у вас нет лицензии Power BI, зарегистрируйтесь на бесплатную лицензию Fabric, чтобы затем запустить пробную версию Fabric.

Создайте и реализуйте комплексный lakehouse для вашей организации:

- Создайте рабочую область Fabric.

- Создайте лейкхаус.

- Прием данных, преобразование данных и его загрузка в lakehouse. Вы также можете изучить OneLake, одну копию данных в режиме озера и режиме конечной точки аналитики SQL.

- Подключитесь к lakehouse с помощью конечной точки аналитики SQL и создайте отчет Power BI с помощью DirectLake для анализа данных о продажах в разных измерениях.

- При необходимости можно оркестрировать и запланировать прием данных и поток преобразования с помощью конвейера.

Очистка ресурсов путем удаления рабочей области и других элементов.

Архитектура

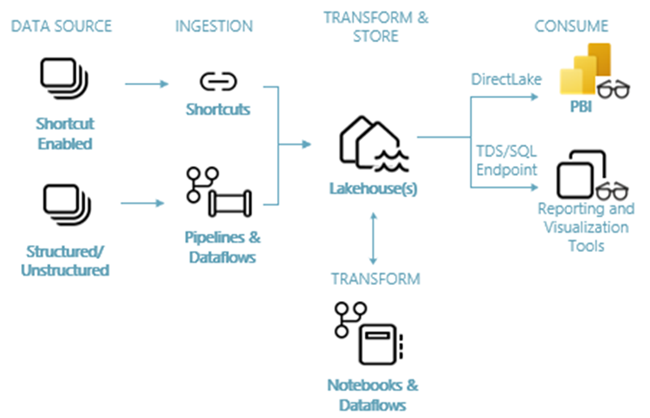

На следующем рисунке показана сквозная архитектура Lakehouse. Компоненты, участвующие в этом разделе, описаны в следующем списке.

Источники данных: Структура позволяет быстро и легко подключаться к службам данных Azure, а также другим облачным платформам и локальным источникам данных для упрощения приема данных.

Прием. Вы можете быстро создавать аналитические сведения для организации с помощью более чем 200 собственных соединителей. Эти соединители интегрируются в конвейер Fabric и используют пользовательское преобразование перетаскивания данных с потоком данных. Кроме того, с помощью функции ярлыка в Fabric можно подключиться к существующим данным, не скопировав или переместив ее.

Преобразование и хранение: Структура стандартизирует формат Delta Lake. Это означает, что все подсистемы Fabric могут получать доступ к одному и тому же набору данных, хранящимся в OneLake, без дублирования данных. Эта система хранения обеспечивает гибкость для создания lakehouse с помощью архитектуры медальона или сетки данных в зависимости от требований организации. Вы можете выбрать один из низкокодовых или безкодовых интерфейсов для преобразования данных, используя конвейеры, потоки данных или записную книжку или Spark для взаимодействия с кодом.

Использование: Power BI может использовать данные из Lakehouse для создания отчетов и визуализации. Каждый Lakehouse имеет встроенную конечную точку TDS, называемую конечной точкой аналитики SQL для простого подключения и запроса данных в таблицах Lakehouse из других средств отчетности. Конечная точка аналитики SQL предоставляет пользователям функциональные возможности подключения к SQL.

Пример набора данных

В этом руководстве используется пример базы данных WWI, которая будет импортирована в lakehouse в следующем руководстве. Для комплексного сценария Lakehouse мы создали достаточные данные для изучения возможностей масштабирования и производительности платформы Fabric.

Wide World Importers (WWI) является оптовым импортером товаров и распространителем товаров, работающих из района Сан-Франциско Бей. Как оптовик, клиенты WWI в основном включают компании, которые перепродают отдельным лицам. WWI продает розничным клиентам через США включая специализированные магазины, супермаркеты, вычислительные магазины, туристические магазины достопримечательность и некоторые лица. WWI также продает другим оптовикам через сеть агентов, которые способствуют продуктам от имени WWI. Дополнительные сведения о профиле и работе компании см . в примерах баз данных Wide World Importers для Microsoft SQL.

Как правило, данные переносятся из транзакционных систем или бизнес-приложений в lakehouse. Однако для простоты в этом руководстве мы используем мерную модель, предоставляемую WWI в качестве исходного источника данных. Мы используем его в качестве источника для приема данных в озеро и преобразуем его с помощью различных этапов (Бронза, Silver и Gold) архитектуры медальона.

Модель данных

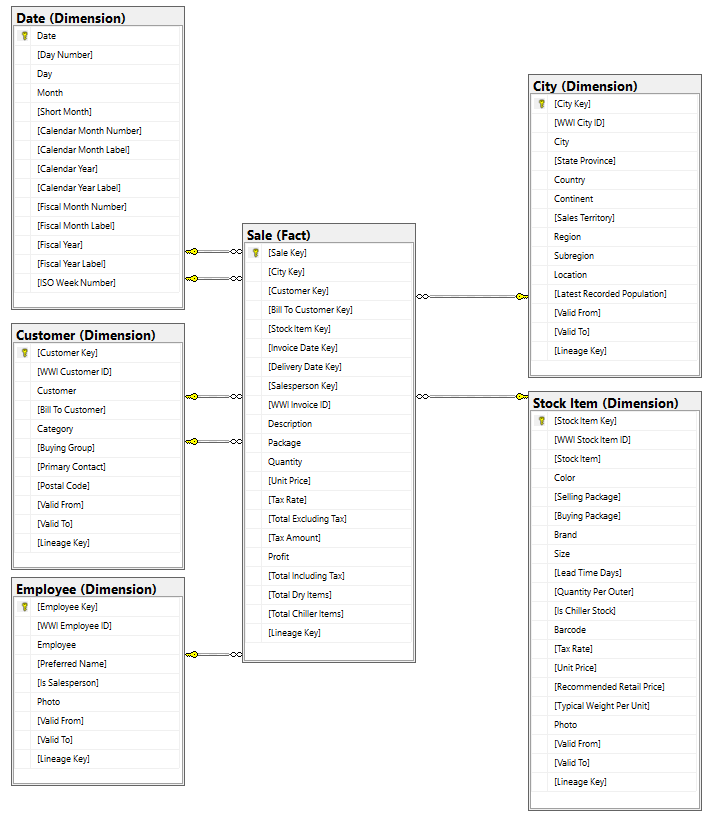

Хотя модель WWI-измерений содержит многочисленные таблицы фактов, в этом руководстве мы используем таблицу фактов продажи и ее коррелированные измерения. В следующем примере показана модель данных WWI:

Поток данных и преобразования

Как описано ранее, мы используем примеры данных из примеров данных WWI для создания этого комплексного озера. В этой реализации образец данных хранится в учетной записи хранения данных Azure в формате файла Parquet для всех таблиц. Однако в реальных сценариях данные обычно исходят из различных источников и в различных форматах.

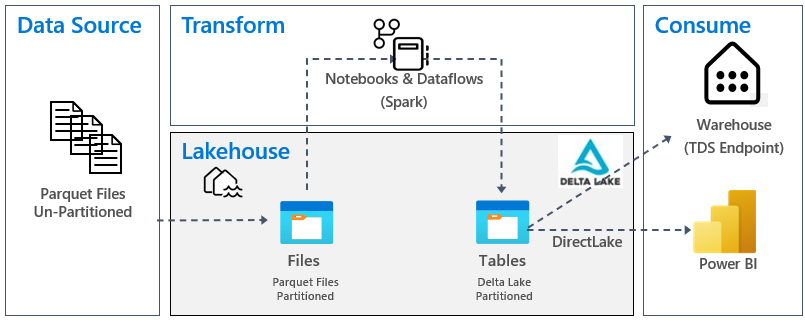

На следующем рисунке показано преобразование источника, назначения и данных:

Источник данных: исходные данные отображаются в формате файла Parquet и в непараментируемой структуре. Он хранится в папке для каждой таблицы. В этом руководстве мы настроим конвейер для приема полных исторических или однократных данных в lakehouse.

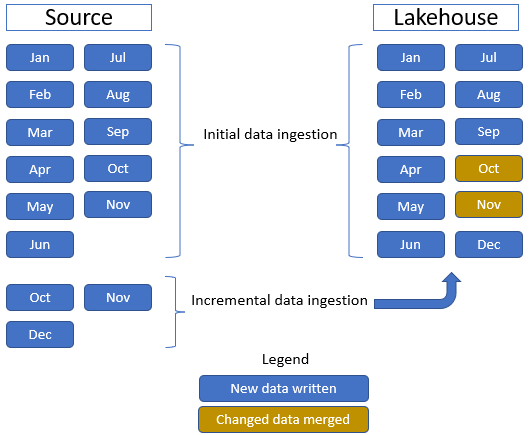

В этом руководстве мы используем таблицу фактов продажи , которая содержит одну родительскую папку с историческими данными в течение 11 месяцев (с одной вложенной папкой для каждого месяца) и другой папкой, содержащей добавочные данные в течение трех месяцев (один вложенный каталог для каждого месяца). Во время приема исходных данных 11 месяцев данных отправляются в таблицу Lakehouse. Однако при поступлении добавочных данных он включает обновленные данные для октября и ноября, а новые данные для декабря и ноября объединяются с существующими данными, а новые данные декабря записываются в таблицу Lakehouse, как показано на следующем рисунке:

Lakehouse. В этом руководстве вы создадите lakehouse, введите данные в раздел файлов озера, а затем создадите разностные таблицы озера в разделе "Таблицы" в озерном доме.

Преобразование: для подготовки и преобразования данных вы увидите два различных подхода. Мы демонстрируем использование записных книжек или Spark для пользователей, которые предпочитают интерфейс для кода и используют конвейеры или поток данных для пользователей, которые предпочитают низкокод или без кода.

Использование. Чтобы продемонстрировать потребление данных, вы увидите, как использовать функцию DirectLake Power BI для создания отчетов, панелей мониторинга и непосредственного запроса данных из lakehouse. Кроме того, мы покажем, как сделать данные доступными для сторонних средств отчетности с помощью конечной точки аналитики TDS/SQL. Эта конечная точка позволяет подключаться к хранилищу и запускать sql-запросы для аналитики.