Kör ditt Azure Databricks-jobb med serverlös beräkning för arbetsflöden

Viktigt!

Eftersom serverlös beräkning för arbetsflöden inte stöder kontroll av utgående trafik har dina jobb fullständig åtkomst till Internet.

Med serverlös beräkning för arbetsflöden kan du köra ditt Azure Databricks-jobb utan att konfigurera och distribuera infrastruktur. Med serverlös beräkning fokuserar du på att implementera dina databearbetnings- och analyspipelines, och Azure Databricks hanterar effektivt beräkningsresurser, inklusive optimering och skalning av beräkning för dina arbetsbelastningar. Automatisk skalning och foton aktiveras automatiskt för de beräkningsresurser som kör jobbet.

Serverlös beräkning för automatisk optimering av arbetsflöden optimerar automatiskt beräkning genom att välja lämpliga resurser, till exempel instanstyper, minne och bearbetningsmotorer baserat på din arbetsbelastning. Automatisk optimering försöker också automatiskt utföra misslyckade uppgifter igen.

Databricks uppgraderar automatiskt Databricks Runtime-versionen för att stödja förbättringar och uppgraderingar till plattformen samtidigt som du säkerställer stabiliteten för dina Azure Databricks-jobb. Information om hur du ser den aktuella Databricks Runtime-versionen som används av serverlös beräkning för arbetsflöden finns i Viktig information om serverlös beräkning.

Eftersom behörighet att skapa kluster inte krävs kan alla arbetsyteanvändare använda serverlös beräkning för att köra sina arbetsflöden.

Den här artikeln beskriver hur du använder användargränssnittet för Azure Databricks-jobb för att skapa och köra jobb som använder serverlös beräkning. Du kan också automatisera skapandet och körningen av jobb som använder serverlös beräkning med Jobb-API:et, Databricks Asset Bundles och Databricks SDK för Python.

- Mer information om hur du använder JOBB-API:et för att skapa och köra jobb som använder serverlös beräkning finns i Jobb i REST API-referensen.

- Mer information om hur du använder Databricks-tillgångspaket för att skapa och köra jobb som använder serverlös beräkning finns i Utveckla ett jobb på Azure Databricks med databricks-tillgångspaket.

- Mer information om hur du använder Databricks SDK för Python för att skapa och köra jobb som använder serverlös beräkning finns i Databricks SDK för Python.

Krav

Din Azure Databricks-arbetsyta måste ha Unity Catalog aktiverat.

Eftersom serverlös beräkning för arbetsflöden använder läget för delad åtkomst måste dina arbetsbelastningar ha stöd för det här åtkomstläget.

Din Azure Databricks-arbetsyta måste finnas i en region som stöds. Se Funktionstillgänglighet.

Ditt Azure Databricks-konto måste ha serverlös beräkning aktiverad. Se Aktivera serverlös beräkning.

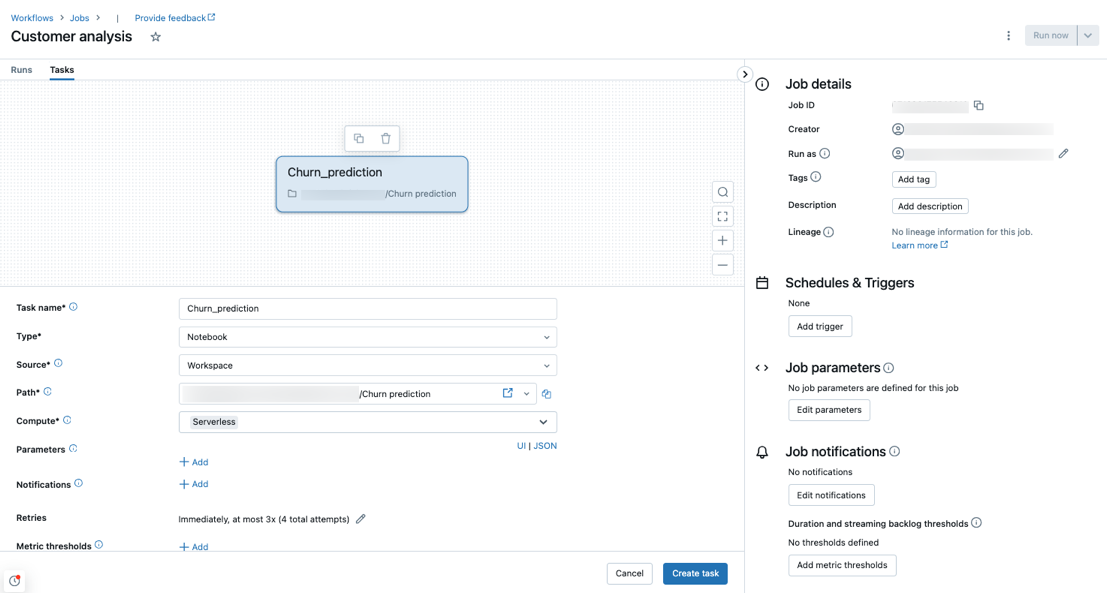

Skapa ett jobb med serverlös beräkning

Kommentar

Eftersom serverlös beräkning för arbetsflöden säkerställer att tillräckligt med resurser etableras för att köra dina arbetsbelastningar kan det uppstå ökade starttider när du kör ett Azure Databricks-jobb som kräver stora mängder minne eller innehåller många uppgifter.

Serverlös beräkning stöds med uppgiftstyperna notebook, Python-skript, dbt och Python-hjul. Som standard väljs serverlös beräkning som beräkningstyp när du skapar ett nytt jobb och lägger till någon av de här aktivitetstyperna som stöds.

Databricks rekommenderar att du använder serverlös beräkning för alla jobbaktiviteter. Du kan också ange olika beräkningstyper för aktiviteter i ett jobb, vilket kan krävas om en aktivitetstyp inte stöds av serverlös beräkning för arbetsflöden.

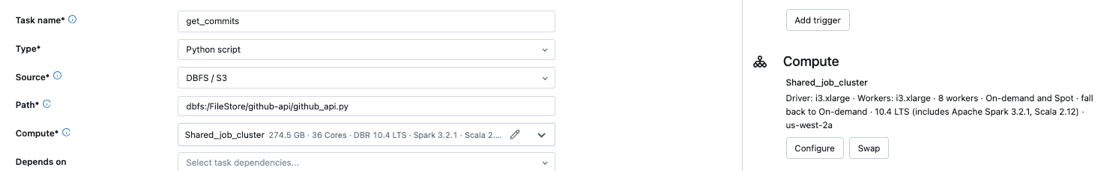

Konfigurera ett befintligt jobb för att använda serverlös beräkning

Du kan växla ett befintligt jobb till att använda serverlös beräkning för aktivitetstyper som stöds när du redigerar jobbet. Växla till serverlös beräkning genom att antingen:

- På sidan Jobbinformation klickar du på Växla under Beräkning, klickar på Nytt, anger eller uppdaterar inställningar och klickar på Uppdatera.

- Klicka

på den nedrullningsbara menyn Beräkning och välj Serverlös.

på den nedrullningsbara menyn Beräkning och välj Serverlös.

Schemalägga en notebook-fil med hjälp av serverlös beräkning

Förutom att använda användargränssnittet jobb för att skapa och schemalägga ett jobb med serverlös beräkning kan du skapa och köra ett jobb som använder serverlös beräkning direkt från en Databricks-notebook-fil. Se Skapa och hantera schemalagda notebook-jobb.

Ange Spark-konfigurationsparametrar

För att automatisera konfigurationen av Spark på serverlös beräkning tillåter Databricks endast inställning av specifika Spark-konfigurationsparametrar. En lista över tillåtna parametrar finns i Spark-konfigurationsparametrar som stöds.

Du kan endast ange Spark-konfigurationsparametrar på sessionsnivå. Det gör du genom att ange dem i en notebook-fil och lägga till anteckningsboken i en uppgift som ingår i samma jobb som använder parametrarna. Se Hämta och ange Apache Spark-konfigurationsegenskaper i en notebook-fil.

Konfigurera miljöer och beroenden

Information om hur du installerar libaries och beroenden med serverlös beräkning finns i Installera notebook-beroenden.

Konfigurera automatisk optimering av serverlös beräkning så att återförsök inte tillåts

Serverlös beräkning för automatisk optimering av arbetsflöden optimerar automatiskt den beräkning som används för att köra dina jobb och återförsök misslyckade uppgifter. Automatisk optimering är aktiverat som standard och Databricks rekommenderar att du låter det vara aktiverat för att säkerställa att kritiska arbetsbelastningar körs minst en gång. Men om du har arbetsbelastningar som måste köras högst en gång, till exempel jobb som inte är idempotenter, kan du inaktivera automatisk optimering när du lägger till eller redigerar en uppgift:

- Bredvid Försök igen klickar du på Lägg till (eller

om det redan finns en återförsöksprincip).

om det redan finns en återförsöksprincip). - I dialogrutan Återförsöksprincip avmarkerar du Aktivera serverlös automatisk optimering (kan innehålla ytterligare återförsök).

- Klicka på Bekräfta.

- Om du lägger till en aktivitet klickar du på Skapa aktivitet. Om du redigerar en uppgift klickar du på Spara uppgift.

Övervaka kostnaden för jobb som använder serverlös beräkning för arbetsflöden

Du kan övervaka kostnaden för jobb som använder serverlös beräkning för arbetsflöden genom att fråga den fakturerbara användningssystemtabellen. Den här tabellen uppdateras så att den innehåller användar- och arbetsbelastningsattribut om serverlösa kostnader. Se Tabellreferens för fakturerbart användningssystem.

Visa information om dina Spark-frågor

Serverlös beräkning för arbetsflöden har ett nytt gränssnitt för att visa detaljerad körningsinformation för dina Spark-instruktioner, till exempel mått och frågeplaner. Så här visar du frågeinsikter för Spark-instruktioner som ingår i dina jobb som körs på serverlös beräkning:

- Klicka på

Arbetsflöden i sidofältet.

Arbetsflöden i sidofältet. - I kolumnen Namn klickar du på det jobbnamn som du vill visa insikter för.

- Klicka på den specifika körning som du vill visa insikter för.

- I avsnittet Beräkning i panelen Aktivitetskörning klickar du på Frågehistorik.

- Du omdirigeras till frågehistoriken, förfiltrerad baserat på aktivitetskörnings-ID:t för den aktivitet som du befann dig i.

Information om hur du använder frågehistorik finns i Frågehistorik.

Begränsningar

En lista över serverlös beräkning för arbetsflödesbegränsningar finns i Serverlösa beräkningsbegränsningar i viktig information om serverlös beräkning.