Red Hat Enterprise Linux Server üzerinde Azure VM’lerindeki IBM Db2 LUW’a yönelik yüksek kullanılabilirlik

Yüksek kullanılabilirlik ve olağanüstü durum kurtarma (HADR) yapılandırmasında Linux, UNIX ve Windows (LUW) için IBM Db2, birincil veritabanı örneğini çalıştıran bir düğümden ve ikincil veritabanı örneğini çalıştıran en az bir düğümden oluşur. Birincil veritabanı örneğindeki değişiklikler, yapılandırmanıza bağlı olarak zaman uyumlu veya zaman uyumsuz olarak ikincil bir veritabanı örneğine çoğaltılır.

Not

Bu makale, Microsoft'un artık kullanmadığını ifade eden başvurular içerir. Bu terimler yazılımdan kaldırıldığında, bunları bu makaleden kaldıracağız.

Bu makalede Azure sanal makinelerini (VM) dağıtma ve yapılandırma, küme çerçevesini yükleme ve HADR yapılandırmasıyla IBM Db2 LUW yükleme işlemleri açıklanmaktadır.

Makale, HADR veya SAP yazılım yüklemesi ile IBM Db2 LUW yükleme ve yapılandırma konularını kapsamaz. Bu görevleri gerçekleştirmenize yardımcı olmak için SAP ve IBM yükleme kılavuzlarına başvurular sunuyoruz. Bu makale, Azure ortamına özgü bölümlere odaklanır.

DESTEKLENEN IBM Db2 sürümleri, SAP not 1928533 belgelendiği gibi 10.5 ve üzeri sürümlerdir.

Yüklemeye başlamadan önce aşağıdaki SAP notlarına ve belgelerine bakın:

| SAP notu | Açıklama |

|---|---|

| 1928533 | Azure'da SAP uygulamaları: Desteklenen ürünler ve Azure VM türleri |

| 2015553 | Azure'da SAP: Destek önkoşulları |

| 2178632 | Azure'da SAP için önemli izleme ölçümleri |

| 2191498 | Azure ile Linux üzerinde SAP: Gelişmiş izleme |

| 2243692 | Azure üzerinde Linux (IaaS) VM: SAP lisans sorunları |

| 2002167 | Red Hat Enterprise Linux 7.x: Yükleme ve Yükseltme |

| 2694118 | Azure'da Red Hat Enterprise Linux HA Eklentisi |

| 1999351 | SAP için gelişmiş Azure izleme sorunlarını giderme |

| 2233094 | DB6: Azure'da Linux, UNIX ve Windows için IBM Db2 kullanan SAP uygulamaları - ek bilgiler |

| 1612105 | DB6: HADR ile Db2 hakkında SSS |

| Belgeler |

|---|

| SAP Community Wiki: Linux için tüm gerekli SAP Notlarına sahiptir |

| Linux üzerinde SAP için Azure Sanal Makineler planlama ve uygulama kılavuzu |

| Linux üzerinde SAP için Azure Sanal Makineler dağıtımı (bu makale) |

| Linux üzerinde SAP için Azure Sanal Makineler veritabanı yönetim sistemi (DBMS) dağıtımı kılavuzu |

| Azure'da SAP iş yükü planlama ve dağıtım denetim listesi |

| Red Hat Enterprise Linux 7 için Yüksek Kullanılabilirlik Eklentisine Genel Bakış |

| Yüksek Kullanılabilirlik Eklentisi Yönetimi |

| Yüksek Kullanılabilirlik Eklentisi Başvurusu |

| RHEL Yüksek Kullanılabilirlik Kümeleri için Destek İlkeleri - Küme Üyeleri Olarak Microsoft Azure Sanal Makineler |

| Microsoft Azure'da Red Hat Enterprise Linux 7.4 (ve üzeri) Yüksek Kullanılabilirlik Kümesi Yükleme ve Yapılandırma |

| SAP iş yükü için IBM Db2 Azure Sanal Makineler DBMS dağıtımı |

| IBM Db2 HADR 11.1 |

| IBM Db2 HADR 10.5 |

| RHEL Yüksek Kullanılabilirlik Kümeleri için Destek İlkesi - Kümede Linux, Unix ve Windows için IBM Db2 Yönetimi |

Genel bakış

Yüksek kullanılabilirlik elde etmek için HADR ile IBM Db2 LUW, kullanılabilirlik alanları arasında veya kullanılabilirlik kümesinde esnek düzenleme ile bir sanal makine ölçek kümesinde dağıtılan en az iki Azure sanal makinesine yüklenir.

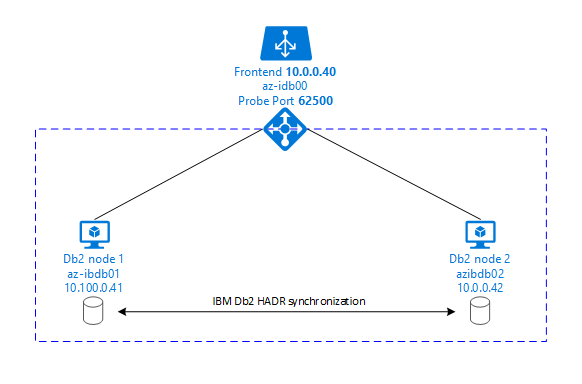

Aşağıdaki grafiklerde iki veritabanı sunucusu Azure VM'sinin kurulumu gösterilir. Her iki veritabanı sunucusu Azure VM'lerinin de kendi depolama alanı vardır ve çalışır durumdadır. HADR'de, Azure VM'lerinden birinde yer alan bir veritabanı örneği birincil örneğin rolüne sahiptir. Tüm istemciler birincil örneğe bağlıdır. Veritabanı işlemlerindeki tüm değişiklikler Db2 işlem günlüğünde yerel olarak kalıcı hale uygulanır. İşlem günlüğü kayıtları yerel olarak kalıcı hale gelince, kayıtlar TCP/IP aracılığıyla ikinci veritabanı sunucusundaki veritabanı örneğine, hazır bekleyen sunucuya veya bekleme örneğine aktarılır. Bekleyen örnek, aktarılan işlem günlüğü kayıtlarını ileterek yerel veritabanını güncelleştirir. Bu şekilde, hazır bekleyen sunucu birincil sunucuyla eşitlenmiş olarak tutulur.

HADR yalnızca bir çoğaltma işlevidir. Hata algılaması ve otomatik devralma veya yük devretme olanakları yoktur. Devralma veya bekleme sunucusuna aktarım, veritabanı yöneticisi tarafından el ile başlatılmalıdır. Otomatik devralma ve hata algılama gerçekleştirmek için Linux Pacemaker kümeleme özelliğini kullanabilirsiniz. Pacemaker iki veritabanı sunucusu örneğini izler. Birincil veritabanı sunucusu örneği kilitlendiğinde Pacemaker, hazır bekleyen sunucu tarafından otomatik hadr devralma işlemi başlatır. Pacemaker ayrıca sanal IP adresinin yeni birincil sunucuya atanmasını sağlar.

SAP uygulama sunucularının birincil veritabanına bağlanması için bir sanal ana bilgisayar adı ve bir sanal IP adresi gerekir. Yük devretme sonrasında SAP uygulama sunucuları yeni birincil veritabanı örneğine bağlanır. Azure ortamında, SANAL IP adresini IBM Db2 HADR için gereken şekilde kullanmak için bir Azure yük dengeleyici gerekir.

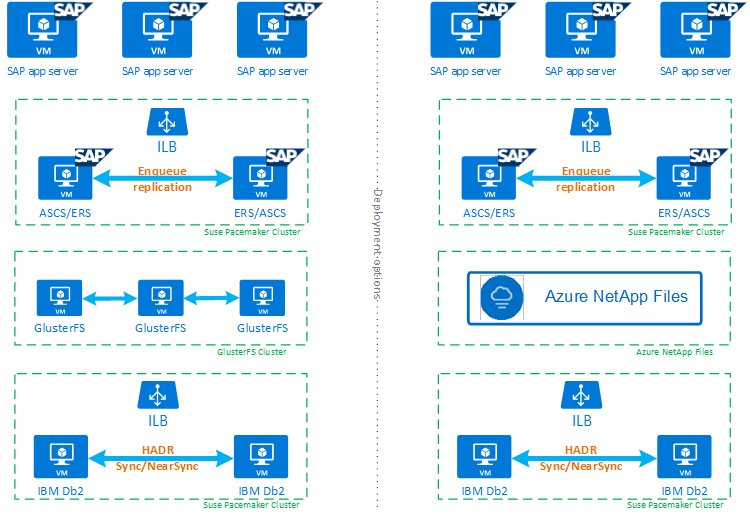

HADR ve Pacemaker ile IBM Db2 LUW'un yüksek oranda kullanılabilir bir SAP sistemi kurulumuna nasıl uyum sağladığını tam olarak anlamanıza yardımcı olmak için aşağıdaki görüntüde, IBM Db2 veritabanını temel alan bir SAP sisteminin yüksek oranda kullanılabilir kurulumuna genel bir bakış sunulmaktadır. Bu makale yalnızca IBM Db2'yi kapsar, ancak sap sisteminin diğer bileşenlerini ayarlama hakkında diğer makalelere başvurular sağlar.

Gerekli adımlara üst düzey genel bakış

IBM Db2 yapılandırmasını dağıtmak için şu adımları izlemeniz gerekir:

- Ortamınızı planlayın.

- VM'leri dağıtın.

- RHEL Linux'ı güncelleştirin ve dosya sistemlerini yapılandırın.

- Pacemaker'ı yükleyin ve yapılandırın.

- Glusterfs kümesini veya Azure NetApp Files'i ayarlama

- ASCS/ERS'i ayrı bir kümeye yükleyin.

- Dağıtılmış/Yüksek Kullanılabilirlik seçeneği (SWPM) ile IBM Db2 veritabanını yükleyin.

- İkincil bir veritabanı düğümü ve örneği yükleyip oluşturun ve HADR'yi yapılandırın.

- HADR'nin çalıştığını onaylayın.

- IBM Db2'yi denetlemek için Pacemaker yapılandırmasını uygulayın.

- Azure Load Balancer'ı yapılandırın.

- Birincil ve iletişim kutusu uygulama sunucularını yükleyin.

- SAP uygulama sunucularının yapılandırmasını denetleyin ve uyarlar.

- Yük devretme ve devralma testleri gerçekleştirin.

HADR ile IBM Db2 LUW barındırmak için Azure altyapısını planlama

Dağıtımı yürütmeden önce planlama işlemini tamamlayın. Planlama, Azure'da HADR ile Db2 yapılandırması dağıtmanın temelini oluşturur. IMB Db2 LUW (SAP ortamının veritabanı bölümü) planlamasının parçası olması gereken temel öğeler aşağıdaki tabloda listelenmiştir:

| Konu | Kısa açıklama |

|---|---|

| Azure kaynak gruplarını tanımlama | VM, sanal ağ, Azure Load Balancer ve diğer kaynakları dağıttığınız kaynak grupları. Mevcut veya yeni olabilir. |

| Sanal ağ / Alt ağ tanımı | IBM Db2 ve Azure Load Balancer vm'lerinin dağıtıldığı yer. Mevcut veya yeni oluşturulmuş olabilir. |

| IBM Db2 LUW barındıran sanal makineler | VM boyutu, depolama, ağ, IP adresi. |

| IBM Db2 veritabanı için sanal ana bilgisayar adı ve sanal IP | Sanal IP veya ana bilgisayar adı, SAP uygulama sunucularının bağlantısı için kullanılır. db-virt-hostname, db-virt-ip. |

| Azure eskrim | Bölünmüş beyin durumlarından kaçınma yöntemi engellenir. |

| Azure Load Balancer | Standart kullanımı (önerilen), Db2 veritabanı için yoklama bağlantı noktası (önerimiz 62500) yoklama bağlantı noktası. |

| Ad çözümlemesi | Ad çözümlemenin ortamda nasıl çalıştığı. DNS hizmeti kesinlikle önerilir. Yerel konaklar dosyası kullanılabilir. |

Azure'da Linux Pacemaker hakkında daha fazla bilgi için bkz . Azure'da Red Hat Enterprise Linux üzerinde Pacemaker'ı ayarlama.

Önemli

Db2 sürüm 11.5.6 ve üzeri sürümler için IBM'den Pacemaker kullanan Tümleşik çözümü kesinlikle öneririz.

Red Hat Enterprise Linux'ta dağıtım

IBM Db2 LUW için kaynak aracısı Red Hat Enterprise Linux Server HA Addon'a dahildir. Bu belgede açıklanan kurulum için SAP için Red Hat Enterprise Linux kullanmalısınız. Azure Market, yeni Azure sanal makinelerini dağıtmak için kullanabileceğiniz, SAP için Red Hat Enterprise Linux 7.4 veya üzeri bir görüntü içerir. Azure VM Market'te bir VM görüntüsü seçtiğinizde Azure Market aracılığıyla Red Hat tarafından sunulan çeşitli destek veya hizmet modellerine dikkat edin.

Konaklar: DNS güncelleştirmeleri

Sanal konak adları da dahil olmak üzere tüm konak adlarının listesini yapın ve DNS sunucularınızı, konak adı çözümlemesine uygun IP adresini etkinleştirmek üzere güncelleştirin. DNS sunucusu yoksa veya DNS girdilerini güncelleştiremiyor ve oluşturamıyorsanız, bu senaryoya katılan tek tek VM'lerin yerel konak dosyalarını kullanmanız gerekir. Konak dosyaları girdileri kullanıyorsanız, girdilerin SAP sistem ortamındaki tüm VM'lere uygulandığından emin olun. Ancak, ideal olarak Azure'a genişleten DNS'nizi kullanmanızı öneririz

El ile dağıtım

Seçili işletim sisteminin IBM Db2 LUW için IBM/SAP tarafından desteklendiğinden emin olun. Azure VM'leri ve Db2 sürümleri için desteklenen işletim sistemi sürümlerinin listesi SAP not 1928533... Tek tek Db2 sürümüne göre işletim sistemi sürümlerinin listesi SAP Ürün Kullanılabilirlik Matrisi'nde bulunur. Bu veya sonraki Red Hat Enterprise Linux sürümlerinde Azure ile ilgili performans geliştirmeleri nedeniyle SAP için en az Red Hat Enterprise Linux 7.4'ün kullanılmasını kesinlikle öneririz.

- Bir kaynak grubu oluşturun veya seçin.

- Bir sanal ağ ve alt ağ oluşturun veya seçin.

- SAP sanal makineleri için uygun bir dağıtım türü seçin. Genellikle esnek düzenlemeye sahip bir sanal makine ölçek kümesidir.

- Sanal Makine 1'i oluşturun.

- Azure Market SAP için Red Hat Enterprise Linux görüntüsünü kullanın.

- 3. adımda oluşturulan ölçek kümesini, kullanılabilirlik bölgesini veya kullanılabilirlik kümesini seçin.

- Sanal Makine 2 oluşturun.

- Azure Market SAP için Red Hat Enterprise Linux görüntüsünü kullanın.

- 3. adımda oluşturulan ölçek kümesini, kullanılabilirlik bölgesini veya kullanılabilirlik kümesini seçin (4. adımda olduğu gibi değil).

- VM'lere veri diskleri ekleyin ve ardından IBM Db2 Azure Sanal Makineler SAP iş yükü için DBMS dağıtımı makalesindeki dosya sistemi kurulumu önerisini gözden geçirin.

IBM Db2 LUW ve SAP ortamını yükleme

IBM Db2 LUW tabanlı bir SAP ortamını yüklemeye başlamadan önce aşağıdaki belgeleri gözden geçirin:

- Azure belgeleri.

- SAP belgeleri.

- IBM belgeleri.

Bu belgelerin bağlantıları bu makalenin giriş bölümünde verilmiştir.

NETWeaver tabanlı uygulamaları IBM Db2 LUW'a yükleme hakkında SAP yükleme kılavuzlarını gözden geçirin. SAP Yükleme Kılavuzu Bulucu'nu kullanarak kılavuzları SAP Yardım portalında bulabilirsiniz.

Aşağıdaki filtreleri ayarlayarak portalda görüntülenen kılavuz sayısını azaltabilirsiniz:

- Yeni bir sistem yüklemek istiyorum.

- Veritabanım: Linux, Unix ve Windows için IBM Db2.

- SAP NetWeaver sürümleri, yığın yapılandırması veya işletim sistemi için ek filtreler.

Red Hat güvenlik duvarı kuralları

Red Hat Enterprise Linux'ta güvenlik duvarı varsayılan olarak etkindir.

#Allow access to SWPM tool. Rule is not permanent.

sudo firewall-cmd --add-port=4237/tcp

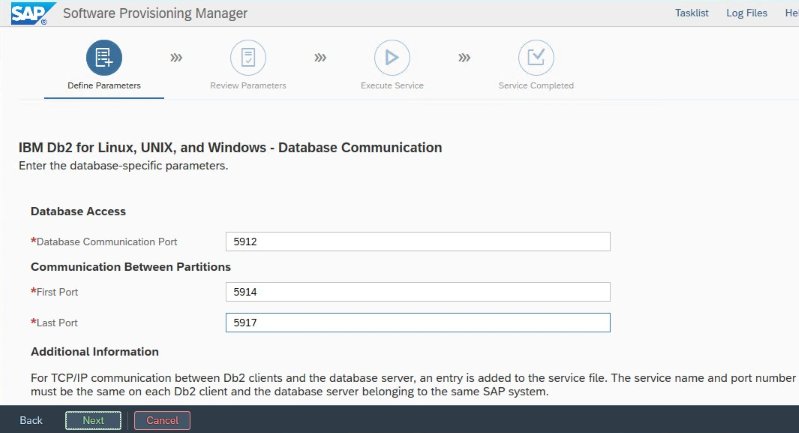

HADR ile IBM Db2 LUW kurulumu için yükleme ipuçları

Birincil IBM Db2 LUW veritabanı örneğini ayarlamak için:

- Yüksek kullanılabilirlik veya dağıtılmış seçeneğini kullanın.

- SAP ASCS/ERS ve Veritabanı örneğini yükleyin.

- Yeni yüklenen veritabanının yedeğini alın.

Önemli

Yükleme sırasında ayarlanan "Veritabanı İletişimi bağlantı noktasını" not edin. Her iki veritabanı örneği için de aynı bağlantı noktası numarası olmalıdır.

Azure için IBM Db2 HADR ayarları

Azure Pacemaker eskrim aracısını kullanırken aşağıdaki parametreleri ayarlayın:

- HADR eş penceresi süresi (saniye) (HADR_PEER_WINDOW) = 240

- HADR zaman aşımı değeri (HADR_TIMEOUT) = 45

İlk yük devretme/devralma testini temel alan önceki parametreleri öneririz. Bu parametre ayarlarıyla yük devretme ve devralma işlevlerinin düzgün olup olmadığını test edin. Tek tek yapılandırmalar farklılık gösterebileceğinden, parametreler ayarlama gerektirebilir.

Not

Normal başlangıçlı HADR yapılandırmasına sahip IBM Db2'ye özgü: Birincil veritabanı örneğini başlatabilmeniz için önce ikincil veya bekleyen veritabanı örneğinin çalışır durumda olması gerekir.

Not

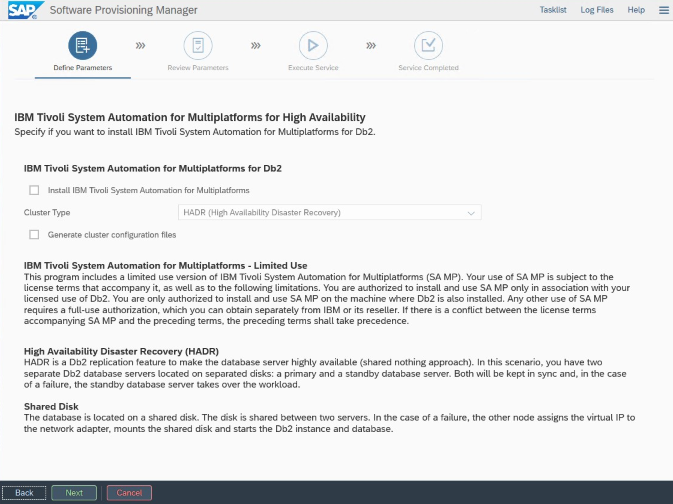

Azure ve Pacemaker'a özgü yükleme ve yapılandırma için: SAP Yazılım Sağlama Yöneticisi aracılığıyla yükleme yordamı sırasında IBM Db2 LUW için yüksek kullanılabilirlik hakkında açık bir soru vardır:

- IBM Db2 pureScale'i seçmeyin.

- Çok Platformlu Formlar için IBM Tivoli Sistem Otomasyonu Yükle'yi seçmeyin.

- Küme yapılandırma dosyaları oluştur'ı seçmeyin.

SAP homojen sistem kopyalama yordamını kullanarak Bekleme veritabanı sunucusunu ayarlamak için şu adımları yürütebilirsiniz:

- Sistem kopyalama seçeneğini Hedef sistemler>Dağıtılmış>Veritabanı örneği'ni >seçin.

- Kopyalama yöntemi olarak, hazır bekleyen sunucu örneğinde yedeklemeyi geri yüklemek için yedeklemeyi kullanabilmek için Homojen Sistem'i seçin.

- Veritabanını homojen sistem kopyası için geri yüklemek için çıkış adımına ulaştığınızda yükleyiciden çıkın. Veritabanını birincil konağın yedeğinden geri yükleyin. Sonraki tüm yükleme aşamaları birincil veritabanı sunucusunda zaten yürütüldü.

DB2 HADR için Red Hat güvenlik duvarı kuralları

HADR'nin çalışması için DB2'ye ve DB2 arasında trafiğe izin vermek için güvenlik duvarı kuralları ekleyin:

- Veritabanı iletişim bağlantı noktası. Bölümleri kullanıyorsanız, bu bağlantı noktalarını da ekleyin.

- HADR bağlantı noktası (DB2 parametresi HADR_LOCAL_SVC değeri).

- Azure yoklama bağlantı noktası.

sudo firewall-cmd --add-port=<port>/tcp --permanent

sudo firewall-cmd --reload

IBM Db2 HADR denetimi

Tanıtım amacıyla ve bu makalede açıklanan yordamlar için veritabanı SID'si ID2'dir.

HADR'yi yapılandırdıktan ve birincil ve bekleme düğümlerinde PEER ve CONNECTED durumu olduktan sonra aşağıdaki denetimi gerçekleştirin:

Execute command as db2<sid> db2pd -hadr -db <SID>

#Primary output:

Database Member 0 -- Database ID2 -- Active -- Up 1 days 15:45:23 -- Date 2019-06-25-10.55.25.349375

HADR_ROLE = PRIMARY

REPLAY_TYPE = PHYSICAL

HADR_SYNCMODE = NEARSYNC

STANDBY_ID = 1

LOG_STREAM_ID = 0

HADR_STATE = PEER

HADR_FLAGS =

PRIMARY_MEMBER_HOST = az-idb01

PRIMARY_INSTANCE = db2id2

PRIMARY_MEMBER = 0

STANDBY_MEMBER_HOST = az-idb02

STANDBY_INSTANCE = db2id2

STANDBY_MEMBER = 0

HADR_CONNECT_STATUS = CONNECTED

HADR_CONNECT_STATUS_TIME = 06/25/2019 10:55:05.076494 (1561460105)

HEARTBEAT_INTERVAL(seconds) = 7

HEARTBEAT_MISSED = 5

HEARTBEAT_EXPECTED = 52

HADR_TIMEOUT(seconds) = 30

TIME_SINCE_LAST_RECV(seconds) = 5

PEER_WAIT_LIMIT(seconds) = 0

LOG_HADR_WAIT_CUR(seconds) = 0.000

LOG_HADR_WAIT_RECENT_AVG(seconds) = 598.000027

LOG_HADR_WAIT_ACCUMULATED(seconds) = 598.000

LOG_HADR_WAIT_COUNT = 1

SOCK_SEND_BUF_REQUESTED,ACTUAL(bytes) = 0, 46080

SOCK_RECV_BUF_REQUESTED,ACTUAL(bytes) = 0, 369280

PRIMARY_LOG_FILE,PAGE,POS = S0000012.LOG, 14151, 3685322855

STANDBY_LOG_FILE,PAGE,POS = S0000012.LOG, 14151, 3685322855

HADR_LOG_GAP(bytes) = 132242668

STANDBY_REPLAY_LOG_FILE,PAGE,POS = S0000012.LOG, 14151, 3685322855

STANDBY_RECV_REPLAY_GAP(bytes) = 0

PRIMARY_LOG_TIME = 06/25/2019 10:45:42.000000 (1561459542)

STANDBY_LOG_TIME = 06/25/2019 10:45:42.000000 (1561459542)

STANDBY_REPLAY_LOG_TIME = 06/25/2019 10:45:42.000000 (1561459542)

STANDBY_RECV_BUF_SIZE(pages) = 2048

STANDBY_RECV_BUF_PERCENT = 0

STANDBY_SPOOL_LIMIT(pages) = 1000

STANDBY_SPOOL_PERCENT = 0

STANDBY_ERROR_TIME = NULL

PEER_WINDOW(seconds) = 300

PEER_WINDOW_END = 06/25/2019 11:12:03.000000 (1561461123)

READS_ON_STANDBY_ENABLED = N

#Secondary output:

Database Member 0 -- Database ID2 -- Standby -- Up 1 days 15:45:18 -- Date 2019-06-25-10.56.19.820474

HADR_ROLE = STANDBY

REPLAY_TYPE = PHYSICAL

HADR_SYNCMODE = NEARSYNC

STANDBY_ID = 0

LOG_STREAM_ID = 0

HADR_STATE = PEER

HADR_FLAGS =

PRIMARY_MEMBER_HOST = az-idb01

PRIMARY_INSTANCE = db2id2

PRIMARY_MEMBER = 0

STANDBY_MEMBER_HOST = az-idb02

STANDBY_INSTANCE = db2id2

STANDBY_MEMBER = 0

HADR_CONNECT_STATUS = CONNECTED

HADR_CONNECT_STATUS_TIME = 06/25/2019 10:55:05.078116 (1561460105)

HEARTBEAT_INTERVAL(seconds) = 7

HEARTBEAT_MISSED = 0

HEARTBEAT_EXPECTED = 10

HADR_TIMEOUT(seconds) = 30

TIME_SINCE_LAST_RECV(seconds) = 1

PEER_WAIT_LIMIT(seconds) = 0

LOG_HADR_WAIT_CUR(seconds) = 0.000

LOG_HADR_WAIT_RECENT_AVG(seconds) = 598.000027

LOG_HADR_WAIT_ACCUMULATED(seconds) = 598.000

LOG_HADR_WAIT_COUNT = 1

SOCK_SEND_BUF_REQUESTED,ACTUAL(bytes) = 0, 46080

SOCK_RECV_BUF_REQUESTED,ACTUAL(bytes) = 0, 367360

PRIMARY_LOG_FILE,PAGE,POS = S0000012.LOG, 14151, 3685322855

STANDBY_LOG_FILE,PAGE,POS = S0000012.LOG, 14151, 3685322855

HADR_LOG_GAP(bytes) = 0

STANDBY_REPLAY_LOG_FILE,PAGE,POS = S0000012.LOG, 14151, 3685322855

STANDBY_RECV_REPLAY_GAP(bytes) = 0

PRIMARY_LOG_TIME = 06/25/2019 10:45:42.000000 (1561459542)

STANDBY_LOG_TIME = 06/25/2019 10:45:42.000000 (1561459542)

STANDBY_REPLAY_LOG_TIME = 06/25/2019 10:45:42.000000 (1561459542)

STANDBY_RECV_BUF_SIZE(pages) = 2048

STANDBY_RECV_BUF_PERCENT = 0

STANDBY_SPOOL_LIMIT(pages) = 1000

STANDBY_SPOOL_PERCENT = 0

STANDBY_ERROR_TIME = NULL

PEER_WINDOW(seconds) = 1000

PEER_WINDOW_END = 06/25/2019 11:12:59.000000 (1561461179)

READS_ON_STANDBY_ENABLED = N

Azure Load Balancer'ı yapılandırma

VM yapılandırması sırasında ağ bölümünde yük dengeleyiciden çıkma seçeneğiniz vardır. DB2 veritabanının yüksek kullanılabilirlik kurulumu için standart yük dengeleyiciyi ayarlamak için aşağıdaki adımları izleyin.

Azure portalını kullanarak yüksek kullanılabilirlikli bir SAP sistemi için standart yük dengeleyici ayarlamak için Yük dengeleyici oluşturma makalesindeki adımları izleyin. Yük dengeleyicinin kurulumu sırasında aşağıdaki noktaları göz önünde bulundurun:

- Ön uç IP Yapılandırması: Ön uç IP'si oluşturun. Veritabanı sanal makinelerinizle aynı sanal ağı ve alt ağ adını seçin.

- Arka Uç Havuzu: Arka uç havuzu oluşturun ve veritabanı VM'leri ekleyin.

- Gelen kuralları: Yük dengeleme kuralı oluşturun. Her iki yük dengeleme kuralı için de aynı adımları izleyin.

- Ön uç IP adresi: Ön uç IP'lerini seçin.

- Arka uç havuzu: Bir arka uç havuzu seçin.

- Yüksek kullanılabilirlik bağlantı noktaları: Bu seçeneği belirleyin.

- Protokol: TCP'yi seçin.

- Sistem Durumu Yoklaması: Aşağıdaki ayrıntıları içeren bir sistem durumu yoklaması oluşturun:

- Protokol: TCP'yi seçin.

- Bağlantı noktası: Örneğin, 625<örnek-no.>.

- Aralık: 5 girin.

- Yoklama Eşiği: 2 girin.

- Boşta kalma zaman aşımı (dakika): 30 girin.

- Kayan IP'yi etkinleştir: Bu seçeneği belirleyin.

Not

Portalda iyi durumda olmayan eşik olarak bilinen durum yoklaması yapılandırma özelliğine numberOfProbesuyulmaz. Başarılı veya başarısız ardışık yoklama sayısını denetlemek için özelliğini probeThreshold olarak 2ayarlayın. Şu anda Azure portalını kullanarak bu özelliği ayarlamak mümkün değildir, bu nedenle Azure CLI veya PowerShell komutunu kullanın.

Not

Genel IP adresleri olmayan VM'ler Standart Azure Load Balancer'ın iç (genel IP adresi yok) örneğinin arka uç havuzuna yerleştirildiğinde, genel uç noktalara yönlendirmeye izin verecek daha fazla yapılandırma yapılmadığı sürece giden İnternet bağlantısı olmaz. Giden bağlantı elde etme hakkında daha fazla bilgi için bkz. SAP yüksek kullanılabilirlik senaryolarında Azure Standart Load Balancer kullanan VM'ler için genel uç nokta bağlantısı.

Önemli

Azure Load Balancer'ın arkasına yerleştirilen Azure VM'lerinde TCP zaman damgalarını etkinleştirmeyin. TCP zaman damgalarının etkinleştirilmesi sistem durumu yoklamalarının başarısız olmasına neden olabilir. parametresini net.ipv4.tcp_timestamps olarak 0ayarlayın. Daha fazla bilgi için bkz . Load Balancer sistem durumu yoklamaları.

[A] Yoklama bağlantı noktası için güvenlik duvarı kuralı ekleyin:

sudo firewall-cmd --add-port=<probe-port>/tcp --permanent

sudo firewall-cmd --reload

Pacemaker kümesini oluşturma

Bu IBM Db2 sunucusu için temel bir Pacemaker kümesi oluşturmak için bkz . Azure'da Red Hat Enterprise Linux üzerinde Pacemaker'ı ayarlama.

Db2 Pacemaker yapılandırması

Düğüm hatası durumunda pacemaker'ı otomatik yük devretme için kullandığınızda Db2 örneklerinizi ve Pacemaker'ı buna göre yapılandırmanız gerekir. Bu bölümde bu tür bir yapılandırma açıklanmaktadır.

Aşağıdaki öğelerden biri ön eklenmiştir:

- [A]: Tüm düğümler için geçerlidir

- [1]: Yalnızca düğüm 1 için geçerlidir

- [2]: Yalnızca düğüm 2 için geçerlidir

[A] Pacemaker yapılandırması için önkoşul:

db2stop ile db2<sid> kullanıcısıyla her iki veritabanı sunucusunu da kapatın.

db2<sid> kullanıcısının kabuk ortamını /bin/ksh olarak değiştirin:

# Install korn shell: sudo yum install ksh # Change users shell: sudo usermod -s /bin/ksh db2<sid>

Pacemaker yapılandırması

[1] IBM Db2 HADR'ye özgü Pacemaker yapılandırması:

# Put Pacemaker into maintenance mode sudo pcs property set maintenance-mode=true[1] IBM Db2 kaynakları oluşturma:

RHEL 7.x üzerinde bir küme oluşturuyorsanız, paket kaynak aracılarını sürüme veya daha yüksek bir sürüme

resource-agents-4.1.1-61.el7_9.15güncelleştirdiğinden emin olun. Küme kaynaklarını oluşturmak için aşağıdaki komutları kullanın:# Replace bold strings with your instance name db2sid, database SID, and virtual IP address/Azure Load Balancer. sudo pcs resource create Db2_HADR_ID2 db2 instance='db2id2' dblist='ID2' master meta notify=true resource-stickiness=5000 #Configure resource stickiness and correct cluster notifications for master resoruce sudo pcs resource update Db2_HADR_ID2-master meta notify=true resource-stickiness=5000 # Configure virtual IP - same as Azure Load Balancer IP sudo pcs resource create vip_db2id2_ID2 IPaddr2 ip='10.100.0.40' # Configure probe port for Azure load Balancer sudo pcs resource create nc_db2id2_ID2 azure-lb port=62500 #Create a group for ip and Azure loadbalancer probe port sudo pcs resource group add g_ipnc_db2id2_ID2 vip_db2id2_ID2 nc_db2id2_ID2 #Create colocation constrain - keep Db2 HADR Master and Group on same node sudo pcs constraint colocation add g_ipnc_db2id2_ID2 with master Db2_HADR_ID2-master #Create start order constrain sudo pcs constraint order promote Db2_HADR_ID2-master then g_ipnc_db2id2_ID2RHEL 8.x üzerinde bir küme oluşturuyorsanız, paket kaynak aracılarını sürüme veya daha yüksek bir sürüme

resource-agents-4.1.1-93.el8güncelleştirdiğinden emin olun. Ayrıntılar için bkz. HADR ile Red Hat KBAdb2kaynağı durumuylaPRIMARY/REMOTE_CATCHUP_PENDING/CONNECTEDyükseltme başarısız oluyor. Küme kaynaklarını oluşturmak için aşağıdaki komutları kullanın:# Replace bold strings with your instance name db2sid, database SID, and virtual IP address/Azure Load Balancer. sudo pcs resource create Db2_HADR_ID2 db2 instance='db2id2' dblist='ID2' promotable meta notify=true resource-stickiness=5000 #Configure resource stickiness and correct cluster notifications for master resoruce sudo pcs resource update Db2_HADR_ID2-clone meta notify=true resource-stickiness=5000 # Configure virtual IP - same as Azure Load Balancer IP sudo pcs resource create vip_db2id2_ID2 IPaddr2 ip='10.100.0.40' # Configure probe port for Azure load Balancer sudo pcs resource create nc_db2id2_ID2 azure-lb port=62500 #Create a group for ip and Azure loadbalancer probe port sudo pcs resource group add g_ipnc_db2id2_ID2 vip_db2id2_ID2 nc_db2id2_ID2 #Create colocation constrain - keep Db2 HADR Master and Group on same node sudo pcs constraint colocation add g_ipnc_db2id2_ID2 with master Db2_HADR_ID2-clone #Create start order constrain sudo pcs constraint order promote Db2_HADR_ID2-clone then g_ipnc_db2id2_ID2[1] IBM Db2 kaynaklarını başlatın:

Pacemaker'ı bakım modundan çıkar.

# Put Pacemaker out of maintenance-mode - that start IBM Db2 sudo pcs property set maintenance-mode=false[1] Küme durumunun tamam olduğundan ve tüm kaynakların başlatıldığından emin olun. Kaynakların hangi düğümde çalıştığı önemli değildir.

sudo pcs status 2 nodes configured 5 resources configured Online: [ az-idb01 az-idb02 ] Full list of resources: rsc_st_azure (stonith:fence_azure_arm): Started az-idb01 Master/Slave Set: Db2_HADR_ID2-master [Db2_HADR_ID2] Masters: [ az-idb01 ] Slaves: [ az-idb02 ] Resource Group: g_ipnc_db2id2_ID2 vip_db2id2_ID2 (ocf::heartbeat:IPaddr2): Started az-idb01 nc_db2id2_ID2 (ocf::heartbeat:azure-lb): Started az-idb01 Daemon Status: corosync: active/disabled pacemaker: active/disabled pcsd: active/enabled

Önemli

Pacemaker kümelenmiş Db2 örneğini Pacemaker araçlarını kullanarak yönetmeniz gerekir. db2stop gibi db2 komutlarını kullanırsanız Pacemaker eylemi kaynak hatası olarak algılar. Bakım gerçekleştiriyorsanız düğümleri veya kaynakları bakım moduna alabilirsiniz. Pacemaker izleme kaynaklarını askıya alır ve ardından normal db2 yönetim komutlarını kullanabilirsiniz.

Bağlantı için sanal IP kullanmak üzere SAP profillerinde değişiklik yapma

HADR yapılandırmasının birincil örneğine bağlanmak için SAP uygulama katmanının Azure Load Balancer için tanımladığınız ve yapılandırdığınız sanal IP adresini kullanması gerekir. Aşağıdaki değişiklikler gereklidir:

/sapmnt/<SID>/profile/DEFAULT. PFL

SAPDBHOST = db-virt-hostname

j2ee/dbhost = db-virt-hostname

/sapmnt/<SID>/global/db6/db2cli.ini

Hostname=db-virt-hostname

Birincil ve iletişim kutusu uygulama sunucularını yükleme

Db2 HADR yapılandırmasına karşı birincil ve iletişim kutusu uygulama sunucularını yüklediğinizde, yapılandırma için seçtiğiniz sanal ana bilgisayar adını kullanın.

Db2 HADR yapılandırmasını oluşturmadan önce yüklemeyi gerçekleştirdiyseniz, önceki bölümde açıklandığı gibi ve SAP Java yığınları için aşağıdaki değişiklikleri yapın.

ABAP+Java veya Java yığın sistemleri JDBC URL denetimi

JDBC URL'sini denetlemek veya güncelleştirmek için J2EE Yapılandırma aracını kullanın. J2EE Yapılandırma aracı bir grafik aracı olduğundan X sunucusunun yüklü olması gerekir:

J2EE örneğinin birincil uygulama sunucusunda oturum açın ve şu komutu yürütür:

sudo /usr/sap/*SID*/*Instance*/j2ee/configtool/configtool.shSol çerçevede güvenlik deposu'na tıklayın.

Sağ çerçevede anahtarını

jdbc/pool/\<SAPSID>/urlseçin.JDBC URL'sindeki ana bilgisayar adını sanal konak adıyla değiştirin.

jdbc:db2://db-virt-hostname:5912/TSP:deferPrepares=0Ekle'yi seçin.

Değişikliklerinizi kaydetmek için sol üst taraftaki disk simgesini seçin.

Yapılandırma aracını kapatın.

Java örneğini yeniden başlatın.

HADR kurulumu için günlük arşivlemeyi yapılandırma

HADR kurulumu için Db2 günlük arşivlemeyi yapılandırmak için hem birincil hem de bekleme veritabanını tüm günlük arşiv konumlarından otomatik günlük alma özelliğine sahip olacak şekilde yapılandırmanızı öneririz. Hem birincil hem de hazır bekleyen veritabanının, veritabanı örneklerinden birinin günlük dosyalarını arşivleyebileceği tüm günlük arşiv konumlarından günlük arşiv dosyalarını alabilmesi gerekir.

Günlük arşivleme yalnızca birincil veritabanı tarafından gerçekleştirilir. Veritabanı sunucularının HADR rollerini değiştirirseniz veya bir hata oluşursa, yeni birincil veritabanı günlük arşivlemeden sorumludur. Birden çok günlük arşiv konumu ayarladıysanız günlükleriniz iki kez arşivlenebilir. Yerel veya uzaktan yakalama durumunda, arşivlenmiş günlükleri eski birincil sunucudan yeni birincil sunucunun etkin günlük konumuna el ile kopyalamanız da gerekebilir.

Günlüklerin her iki düğümden de yazıldığı ortak bir NFS paylaşımı veya GlusterFS yapılandırmanızı öneririz. NFS paylaşımı veya GlusterFS yüksek oranda kullanılabilir olmalıdır.

Aktarımlar veya profil dizini için mevcut yüksek oranda kullanılabilir NFS paylaşımlarını veya GlusterFS'i kullanabilirsiniz. Daha fazla bilgi için bkz.

- SAP NetWeaver için Red Hat Enterprise Linux üzerinde Azure VM'lerinde GlusterFS.

- SAP Uygulamaları için Azure NetApp Files ile Red Hat Enterprise Linux üzerinde Azure VM'lerinde SAP NetWeaver için yüksek kullanılabilirlik.

- Azure NetApp Files (NFS paylaşımları oluşturmak için).

Küme kurulumunu test edin

Bu bölümde Db2 HADR kurulumunuzu nasıl test edebilirsiniz açıklanmaktadır. Her test, IBM Db2 birincil öğesinin az-idb01 sanal makinesinde çalıştığını varsayar. Sudo ayrıcalıklarına veya köküne sahip kullanıcı (önerilmez) kullanılmalıdır.

Tüm test çalışmalarının ilk durumu burada açıklanmıştır: (crm_mon -r veya bilgisayar durumu)

- pcs durumu , yürütme zamanında Pacemaker durumunun anlık görüntüsüdür.

- crm_mon -r , Pacemaker durumunun sürekli çıkışıdır.

2 nodes configured

5 resources configured

Online: [ az-idb01 az-idb02 ]

Full list of resources:

rsc_st_azure (stonith:fence_azure_arm): Started az-idb01

Master/Slave Set: Db2_HADR_ID2-master [Db2_HADR_ID2]

Masters: [ az-idb01 ]

Slaves: [ az-idb02 ]

Resource Group: g_ipnc_db2id2_ID2

vip_db2id2_ID2 (ocf::heartbeat:IPaddr2): Started az-idb01

nc_db2id2_ID2 (ocf::heartbeat:azure-lb): Started az-idb01

Daemon Status:

corosync: active/disabled

pacemaker: active/disabled

pcsd: active/enabled

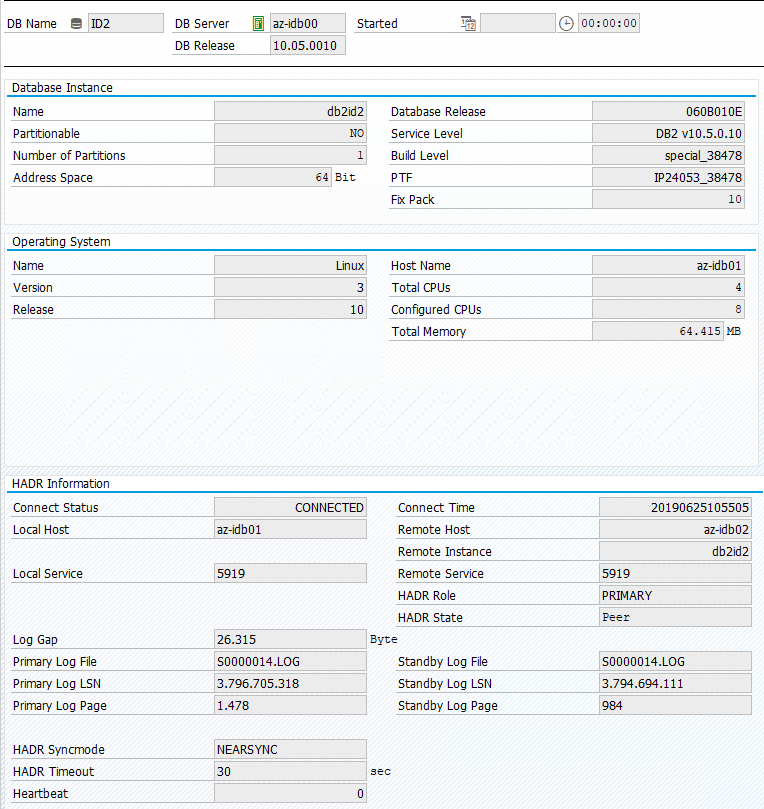

Sap sistemindeki özgün durum, aşağıdaki görüntüde gösterildiği gibi İşlem DBACOCKPIT > Yapılandırmasına > Genel Bakış bölümünde belgelenmiştir:

IBM Db2'nin devralma testi

Önemli

Teste başlamadan önce şunları yaptığınızdan emin olun:

Pacemaker'da başarısız eylemler (bilgisayar durumu) yoktur.

Konum kısıtlaması yoktur (geçiş testinin artıkları).

IBM Db2 HADR eşitlemesi çalışıyor. Kullanıcı db2<sid ile> denetleyin.

db2pd -hadr -db <DBSID>

Aşağıdaki komutu yürüterek birincil Db2 veritabanını çalıştıran düğümü geçirin:

# On RHEL 7.x

sudo pcs resource move Db2_HADR_ID2-master

# On RHEL 8.x

sudo pcs resource move Db2_HADR_ID2-clone --master

Geçiş tamamlandıktan sonra crm durumu çıktısı şöyle görünür:

2 nodes configured

5 resources configured

Online: [ az-idb01 az-idb02 ]

Full list of resources:

rsc_st_azure (stonith:fence_azure_arm): Started az-idb01

Master/Slave Set: Db2_HADR_ID2-master [Db2_HADR_ID2]

Masters: [ az-idb02 ]

Stopped: [ az-idb01 ]

Resource Group: g_ipnc_db2id2_ID2

vip_db2id2_ID2 (ocf::heartbeat:IPaddr2): Started az-idb02

nc_db2id2_ID2 (ocf::heartbeat:azure-lb): Started az-idb02

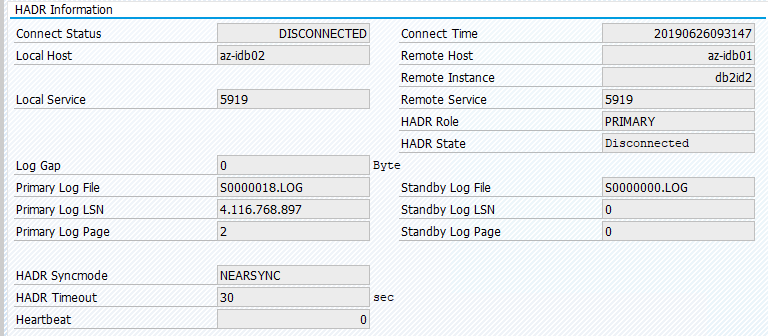

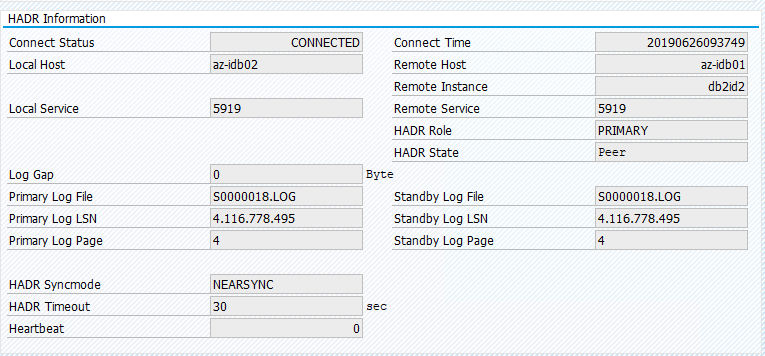

Sap sistemindeki özgün durum, aşağıdaki görüntüde gösterildiği gibi İşlem DBACOCKPIT > Yapılandırmasına > Genel Bakış bölümünde belgelenmiştir:

"Pcs kaynak taşıma" ile kaynak geçişi konum kısıtlamaları oluşturur. Bu durumda konum kısıtlamaları az-idb01 üzerinde IBM Db2 örneğinin çalıştırılmasını engelliyor. Konum kısıtlamaları silinmezse kaynak yeniden çalışmaz.

Konum kısıtlamasını kaldırdığınızda az-idb01 üzerinde bekleme düğümü başlatılır.

# On RHEL 7.x

sudo pcs resource clear Db2_HADR_ID2-master

# On RHEL 8.x

sudo pcs resource clear Db2_HADR_ID2-clone

Küme durumu şu şekilde değişir:

2 nodes configured

5 resources configured

Online: [ az-idb01 az-idb02 ]

Full list of resources:

rsc_st_azure (stonith:fence_azure_arm): Started az-idb01

Master/Slave Set: Db2_HADR_ID2-master [Db2_HADR_ID2]

Masters: [ az-idb02 ]

Slaves: [ az-idb01 ]

Resource Group: g_ipnc_db2id2_ID2

vip_db2id2_ID2 (ocf::heartbeat:IPaddr2): Started az-idb02

nc_db2id2_ID2 (ocf::heartbeat:azure-lb): Started az-idb02

Kaynağı az-idb01'e geri geçirin ve konum kısıtlamalarını temizleyin

# On RHEL 7.x

sudo pcs resource move Db2_HADR_ID2-master az-idb01

sudo pcs resource clear Db2_HADR_ID2-master

# On RHEL 8.x

sudo pcs resource move Db2_HADR_ID2-clone --master

sudo pcs resource clear Db2_HADR_ID2-clone

- RHEL 7.x üzerinde -

pcs resource move <resource_name> <host>: Konum kısıtlamaları oluşturur ve devralmayla ilgili sorunlara neden olabilir - RHEL 8.x üzerinde -

pcs resource move <resource_name> --master: Konum kısıtlamaları oluşturur ve devralmayla ilgili sorunlara neden olabilir pcs resource clear <resource_name>: Konum kısıtlamalarını temizlerpcs resource cleanup <resource_name>: Kaynağın tüm hatalarını temizler

El ile devralma testi

Az-idb01 düğümünde Pacemaker hizmetini durdurarak el ile devralma test edebilirsiniz:

systemctl stop pacemaker

az-ibdb02 üzerinde durum

2 nodes configured

5 resources configured

Node az-idb01: pending

Online: [ az-idb02 ]

Full list of resources:

rsc_st_azure (stonith:fence_azure_arm): Started az-idb02

Master/Slave Set: Db2_HADR_ID2-master [Db2_HADR_ID2]

Masters: [ az-idb02 ]

Stopped: [ az-idb01 ]

Resource Group: g_ipnc_db2id2_ID2

vip_db2id2_ID2 (ocf::heartbeat:IPaddr2): Started az-idb02

nc_db2id2_ID2 (ocf::heartbeat:azure-lb): Started az-idb02

Daemon Status:

corosync: active/disabled

pacemaker: active/disabled

pcsd: active/enabled

Yük devretme işleminden sonra az-idb01 üzerinde hizmeti yeniden başlatabilirsiniz.

systemctl start pacemaker

HADR birincil veritabanını çalıştıran düğümde Db2 işlemini sonlandırma

#Kill main db2 process - db2sysc

[sapadmin@az-idb02 ~]$ sudo ps -ef|grep db2sysc

db2ptr 34598 34596 8 14:21 ? 00:00:07 db2sysc 0

[sapadmin@az-idb02 ~]$ sudo kill -9 34598

Db2 örneği başarısız olacak ve Pacemaker ana düğümü taşır ve aşağıdaki durumu bildirir:

2 nodes configured

5 resources configured

Online: [ az-idb01 az-idb02 ]

Full list of resources:

rsc_st_azure (stonith:fence_azure_arm): Started az-idb02

Master/Slave Set: Db2_HADR_ID2-master [Db2_HADR_ID2]

Masters: [ az-idb02 ]

Stopped: [ az-idb01 ]

Resource Group: g_ipnc_db2id2_ID2

vip_db2id2_ID2 (ocf::heartbeat:IPaddr2): Started az-idb02

nc_db2id2_ID2 (ocf::heartbeat:azure-lb): Started az-idb02

Failed Actions:

* Db2_HADR_ID2_demote_0 on az-idb01 'unknown error' (1): call=49, status=complete, exitreason='none',

last-rc-change='Wed Jun 26 09:57:35 2019', queued=0ms, exec=362ms

Pacemaker aynı düğümde Db2 birincil veritabanı örneğini yeniden başlatır veya ikincil veritabanı örneğini çalıştıran düğüme yük devreder ve bir hata bildirilir.

İkincil veritabanı örneğini çalıştıran düğümde Db2 işlemini sonlandırma

[sapadmin@az-idb02 ~]$ sudo ps -ef|grep db2sysc

db2id2 23144 23142 2 09:53 ? 00:00:13 db2sysc 0

[sapadmin@az-idb02 ~]$ sudo kill -9 23144

Düğüm başarısız duruma geçer ve hata bildirilir.

2 nodes configured

5 resources configured

Online: [ az-idb01 az-idb02 ]

Full list of resources:

rsc_st_azure (stonith:fence_azure_arm): Started az-idb02

Master/Slave Set: Db2_HADR_ID2-master [Db2_HADR_ID2]

Masters: [ az-idb01 ]

Slaves: [ az-idb02 ]

Resource Group: g_ipnc_db2id2_ID2

vip_db2id2_ID2 (ocf::heartbeat:IPaddr2): Started az-idb01

nc_db2id2_ID2 (ocf::heartbeat:azure-lb): Started az-idb01

Failed Actions:

* Db2_HADR_ID2_monitor_20000 on az-idb02 'not running' (7): call=144, status=complete, exitreason='none',

last-rc-change='Wed Jun 26 10:02:09 2019', queued=0ms, exec=0ms

Db2 örneği daha önce atadığı ikincil rolde yeniden başlatılır.

HADR birincil veritabanı örneğini çalıştıran düğümde db2stop force aracılığıyla DB'yi durdurun

kullanıcı db2<sid> execute komutu olarak db2stop force:

az-idb01:db2ptr> db2stop force

Hata algılandı:

2 nodes configured

5 resources configured

Online: [ az-idb01 az-idb02 ]

Full list of resources:

rsc_st_azure (stonith:fence_azure_arm): Started az-idb02

Master/Slave Set: Db2_HADR_ID2-master [Db2_HADR_ID2]

Slaves: [ az-idb02 ]

Stopped: [ az-idb01 ]

Resource Group: g_ipnc_db2id2_ID2

vip_db2id2_ID2 (ocf::heartbeat:IPaddr2): Stopped

nc_db2id2_ID2 (ocf::heartbeat:azure-lb): Stopped

Failed Actions:

* Db2_HADR_ID2_demote_0 on az-idb01 'unknown error' (1): call=110, status=complete, exitreason='none',

last-rc-change='Wed Jun 26 14:03:12 2019', queued=0ms, exec=355ms

Db2 HADR ikincil veritabanı örneği birincil role yükseltildi.

2 nodes configured

5 resources configured

Online: [ az-idb01 az-idb02 ]

Full list of resources:

rsc_st_azure (stonith:fence_azure_arm): Started az-idb02

Master/Slave Set: Db2_HADR_ID2-master [Db2_HADR_ID2]

Masters: [ az-idb02 ]

Slaves: [ az-idb01 ]

Resource Group: g_ipnc_db2id2_ID2

vip_db2id2_ID2 (ocf::heartbeat:IPaddr2): Started az-idb02

nc_db2id2_ID2 (ocf::heartbeat:azure-lb): Started az-idb02

Failed Actions:

* Db2_HADR_ID2_demote_0 on az-idb01 'unknown error' (1): call=110, status=complete, exitreason='none',

last-rc-change='Wed Jun 26 14:03:12 2019', queued=0ms, exec=355ms

HADR birincil veritabanı örneğini çalıştıran VM'yi "durdurma" ile kilitlenme

#Linux kernel panic.

sudo echo b > /proc/sysrq-trigger

Böyle bir durumda Pacemaker, birincil veritabanı örneğini çalıştıran düğümün yanıt vermediğini algılar.

2 nodes configured

5 resources configured

Node az-idb01: UNCLEAN (online)

Online: [ az-idb02 ]

Full list of resources:

rsc_st_azure (stonith:fence_azure_arm): Started az-idb02

Master/Slave Set: Db2_HADR_ID2-master [Db2_HADR_ID2]

Masters: [ az-idb01 ]

Slaves: [ az-idb02 ]

Resource Group: g_ipnc_db2id2_ID2

vip_db2id2_ID2 (ocf::heartbeat:IPaddr2): Started az-idb01

nc_db2id2_ID2 (ocf::heartbeat:azure-lb): Started az-idb01

Bir sonraki adım Bölünmüş beyin durumunu kontrol etmektir. Hayatta kalan düğüm, birincil veritabanı örneğini en son çalıştıran düğümün devre dışı olduğunu belirledikten sonra kaynakların yük devretmesi yürütülür.

2 nodes configured

5 resources configured

Online: [ az-idb02 ]

OFFLINE: [ az-idb01 ]

Full list of resources:

rsc_st_azure (stonith:fence_azure_arm): Started az-idb02

Master/Slave Set: Db2_HADR_ID2-master [Db2_HADR_ID2]

Masters: [ az-idb02 ]

Stopped: [ az-idb01 ]

Resource Group: g_ipnc_db2id2_ID2

vip_db2id2_ID2 (ocf::heartbeat:IPaddr2): Started az-idb02

nc_db2id2_ID2 (ocf::heartbeat:azure-lb): Started az-idb02

Çekirdek paniği durumunda, başarısız düğüm eskrim aracısı tarafından yeniden başlatılır. Başarısız düğüm yeniden çevrimiçi olduktan sonra pacemaker kümesini şu şekilde başlatmanız gerekir:

sudo pcs cluster start

Db2 örneğini ikincil role başlatır.

2 nodes configured

5 resources configured

Online: [ az-idb01 az-idb02 ]

Full list of resources:

rsc_st_azure (stonith:fence_azure_arm): Started az-idb02

Master/Slave Set: Db2_HADR_ID2-master [Db2_HADR_ID2]

Masters: [ az-idb02 ]

Slaves: [ az-idb01 ]

Resource Group: g_ipnc_db2id2_ID2

vip_db2id2_ID2 (ocf::heartbeat:IPaddr2): Started az-idb02

nc_db2id2_ID2 (ocf::heartbeat:azure-lb): Started az-idb02