Büyük veri gereksinimleri için Azure Data Lake Storage 1. Nesil kullanma

Not

Azure Data Lake Storage 1. Nesil artık kullanımdan kaldırıldı. Kullanımdan kaldırma duyurusunu buradan görebilirsiniz.Data Lake Storage 1. Nesil kaynaklara artık erişilemez.

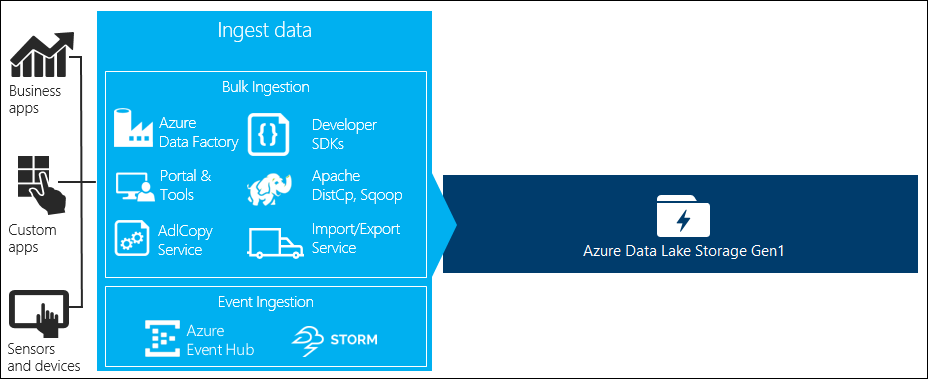

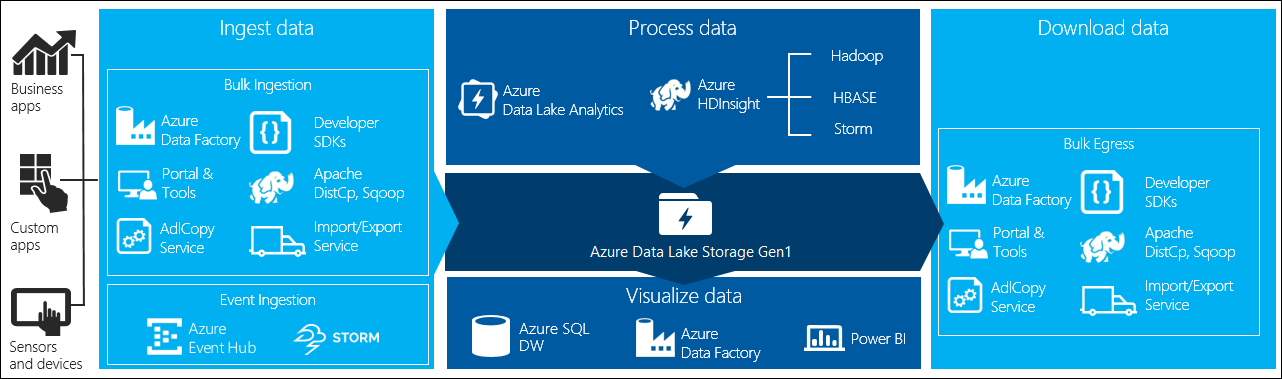

Büyük veri işlemenin dört temel aşaması vardır:

- Büyük miktarda veriyi gerçek zamanlı veya toplu olarak bir veri deposuna alma

- Verileri işleme

- Verileri indirme

- Verileri görselleştirme

Bu makalede, büyük veri gereksinimlerinizi karşılamak için kullanılabilecek seçenekleri ve araçları anlamak için Azure Data Lake Storage 1. Nesil ile ilgili olarak bu aşamalara göz atacağız.

verileri Data Lake Storage 1. Nesil alma

Bu bölümde farklı veri kaynakları ve bu verilerin bir Data Lake Storage 1. Nesil hesabına alınabilmesinin farklı yolları vurgulanır.

Geçici veriler

Bu, büyük bir veri uygulamasının prototiplerini oluşturmak için kullanılan daha küçük veri kümelerini temsil eder. Verilerin kaynağına bağlı olarak geçici verileri almanın farklı yolları vardır.

| Veri Kaynağı | Kullanarak alma |

|---|---|

| Yerel bilgisayar | |

| Azure Depolama Blobu |

Akışa alınan veriler

Bu, uygulamalar, cihazlar, algılayıcılar vb. çeşitli kaynaklar tarafından oluşturulabilen verileri temsil eder. Bu veriler çeşitli araçlarla Data Lake Storage 1. Nesil alınabiliyor. Bu araçlar genellikle verileri gerçek zamanlı olarak olay temelinde yakalayıp işler ve daha sonra daha fazla işlenebilmeleri için olayları toplu olarak Data Lake Storage 1. Nesil olarak yazar.

Kullanabileceğiniz araçlar şunlardır:

- Azure Stream Analytics - Event Hubs'a alınan olaylar, Azure Data Lake Storage 1. Nesil çıkışı kullanılarak Azure Data Lake Storage 1. Nesil yazılabilir.

- EventProcessorHost : Event Hubs'dan olayları alabilir ve ardından Data Lake Storage 1. Nesil .NET SDK'sını kullanarak Data Lake Storage 1. Nesil yazabilirsiniz.

İlişkisel veriler

İlişkisel veritabanlarından da veri kaynağı oluşturabilirsiniz. bir süre boyunca ilişkisel veritabanları, büyük bir veri işlem hattı aracılığıyla işlenirse önemli içgörüler sağlayabilecek çok miktarda veri toplar. Bu tür verileri Data Lake Storage 1. Nesil taşımak için aşağıdaki araçları kullanabilirsiniz.

Web sunucusu günlük verileri (özel uygulamalar kullanarak karşıya yükleme)

Web sunucusu günlük verilerinin analizi büyük veri uygulamaları için yaygın bir kullanım örneği olduğundan ve büyük hacimli günlük dosyalarının Data Lake Storage 1. Nesil yüklenmesi gerektiğinden bu tür bir veri kümesi özellikle vurgulanır. Bu tür verileri karşıya yüklemek için kendi betiklerinizi veya uygulamalarınızı yazmak için aşağıdaki araçlardan herhangi birini kullanabilirsiniz.

Web sunucusu günlük verilerini karşıya yüklemek ve diğer veri türlerini (örneğin sosyal yaklaşım verileri) karşıya yüklemek için, büyük büyük veri uygulamanızın parçası olarak veri yükleme bileşeninizi dahil etme esnekliği sağladığından, kendi özel betiklerinizi/uygulamalarınızı yazmak iyi bir yaklaşımdır. Bazı durumlarda bu kod bir betik veya basit komut satırı yardımcı programı biçiminde olabilir. Diğer durumlarda kod, büyük veri işlemeyi bir iş uygulaması veya çözümüyle tümleştirmek için kullanılabilir.

Azure HDInsight kümeleriyle ilişkili veriler

Çoğu HDInsight küme türü (Hadoop, HBase, Storm) veri depolama deposu olarak Data Lake Storage 1. Nesil destekler. HDInsight kümeleri Azure Depolama Bloblarından (WASB) verilere erişmektedir. Daha iyi performans için WASB'den verileri kümeyle ilişkilendirilmiş bir Data Lake Storage 1. Nesil hesabına kopyalayabilirsiniz. Verileri kopyalamak için aşağıdaki araçları kullanabilirsiniz.

Şirket içi veya IaaS Hadoop kümelerinde depolanan veriler

Büyük miktarda veri mevcut Hadoop kümelerinde, HDFS kullanan makinelerde yerel olarak depolanabilir. Hadoop kümeleri bir şirket içi dağıtımda veya Azure'daki bir IaaS kümesinde olabilir. Tek seferlik bir yaklaşım veya yinelenen bir yaklaşım için bu tür verileri Azure Data Lake Storage 1. Nesil kopyalama gereksinimleri olabilir. Bunu başarmak için kullanabileceğiniz çeşitli seçenekler vardır. Aşağıda alternatiflerin ve ilişkili dengelerin listesi yer almaktadır.

| Yaklaşım | Ayrıntılar | Avantajlar | Dikkat edilmesi gereken noktalar |

|---|---|---|---|

| Azure Data Factory'yi (ADF) kullanarak verileri doğrudan Hadoop kümelerinden Azure Data Lake Storage 1. Nesil | ADF, veri kaynağı olarak HDFS'yi destekler | ADF, HDFS ve birinci sınıf uçtan uca yönetim ve izleme için kullanıma hazır destek sağlar | Veri Yönetimi Ağ Geçidinin şirket içinde veya IaaS kümesinde dağıtılması gerekir |

| Hadoop'tan verileri dosya olarak dışarı aktarın. Ardından uygun mekanizmayı kullanarak dosyaları Azure Data Lake Storage 1. Nesil'a kopyalayın. | Dosyaları Azure Data Lake Storage 1. Nesil'a aşağıdakini kullanarak kopyalayabilirsiniz:

|

Başlamak için hızlı. Özelleştirilmiş karşıya yüklemeler yapabilir | Birden çok teknoloji içeren çok adımlı işlem. Yönetim ve izleme, araçların özelleştirilmiş yapısı göz önünde bulundurulduğunda zaman içinde bir zorluk olarak büyüyecek |

| Hadoop'tan Azure Depolama'ya veri kopyalamak için Distcp kullanın. Ardından uygun mekanizmayı kullanarak Verileri Azure Depolama'dan Data Lake Storage 1. Nesil kopyalayın. | Aşağıdakileri kullanarak Azure Depolama'dan Data Lake Storage 1. Nesil veri kopyalayabilirsiniz: | Açık kaynak araçlarını kullanabilirsiniz. | Birden çok teknoloji içeren çok adımlı işlem |

Gerçekten büyük veri kümeleri

Birkaç terabaytlık veri kümelerini karşıya yüklemek için, yukarıda açıklanan yöntemlerin kullanılması bazen yavaş ve maliyetli olabilir. Böyle durumlarda aşağıdaki seçenekleri kullanabilirsiniz.

Azure ExpressRoute'u kullanma. Azure ExpressRoute, azure veri merkezleriyle şirket içi altyapı arasında özel bağlantılar oluşturmanıza olanak tanır. Bu, büyük miktarlarda veri aktarmak için güvenilir bir seçenek sağlar. Daha fazla bilgi için bkz . Azure ExpressRoute belgeleri.

Verilerin "çevrimdışı" karşıya yüklenmesi. Azure ExpressRoute kullanmak herhangi bir nedenle mümkün değilse, verilerinizle birlikte sabit disk sürücülerini bir Azure veri merkezine göndermek için Azure İçeri/Dışarı Aktarma hizmetini kullanabilirsiniz. Verileriniz ilk olarak Azure Depolama Bloblarına yüklenir. Ardından Azure Depolama Blobları'ndan Data Lake Storage 1. Nesil verileri kopyalamak için Azure Data Factory veya AdlCopy aracını kullanabilirsiniz.

Not

İçeri/Dışarı Aktarma hizmetini kullanırken, Azure veri merkezine gönderdiğiniz disklerdeki dosya boyutları 195 GB'tan büyük olmamalıdır.

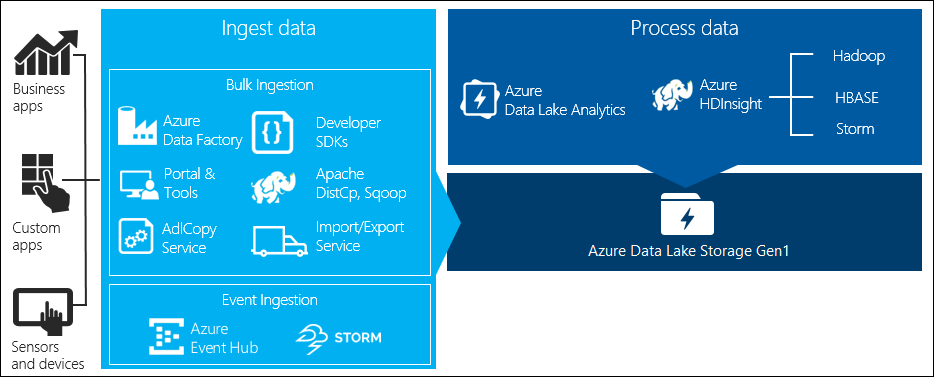

Data Lake Storage 1. Nesil depolanan verileri işleme

veriler Data Lake Storage 1. Nesil'de kullanılabilir olduğunda desteklenen büyük veri uygulamalarını kullanarak bu veriler üzerinde analiz çalıştırabilirsiniz. Şu anda Azure HDInsight ve Azure Data Lake Analytics kullanarak Data Lake Storage 1. Nesil'de depolanan veriler üzerinde veri analizi işleri çalıştırabilirsiniz.

Aşağıdaki örneklere bakabilirsiniz.

- Depolama olarak Data Lake Storage 1. Nesil ile HDInsight kümesi oluşturma

- Azure Data Lake Analytics'i Data Lake Storage 1. Nesil ile kullanma

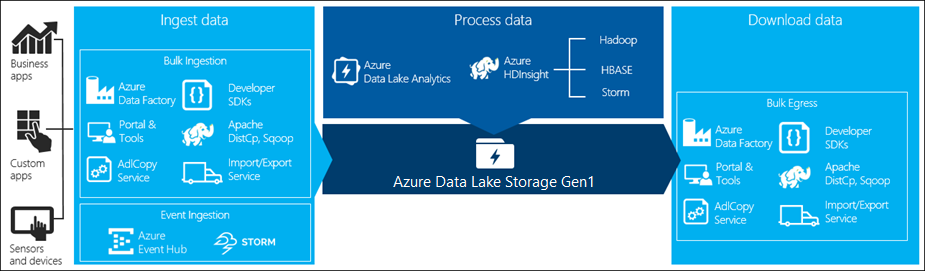

Data Lake Storage 1. Nesil'dan veri indirme

Aşağıdakiler gibi senaryolar için Azure Data Lake Storage 1. Nesil'dan veri indirmek veya taşımak da isteyebilirsiniz:

- Mevcut veri işleme işlem hatlarınızla arabirim sağlamak için verileri diğer depolara taşıyın. Örneğin, verileri Data Lake Storage 1. Nesil Azure SQL Veritabanı veya SQL Server'a taşımak isteyebilirsiniz.

- Uygulama prototipleri oluştururken IDE ortamlarında işlemek üzere verileri yerel bilgisayarınıza indirin.

Böyle durumlarda, aşağıdaki seçeneklerden herhangi birini kullanabilirsiniz:

Ayrıca, Data Lake Storage 1. Nesil'dan veri indirmek üzere kendi betiğinizi/uygulamanızı yazmak için aşağıdaki yöntemleri de kullanabilirsiniz.

Data Lake Storage 1. Nesil'de verileri görselleştirme

Data Lake Storage 1. Nesil depolanan verilerin görsel gösterimlerini oluşturmak için hizmetlerin bir karışımını kullanabilirsiniz.

- Verileri Data Lake Storage 1. Nesil Azure Synapse Analytics'e taşımak için Azure Data Factory'yi kullanarak başlayabilirsiniz

- Bundan sonra, verilerin görsel gösterimini oluşturmak için Power BI'ı Azure Synapse Analytics ile tümleştirebilirsiniz.