Tutorial: Executar Python em um cluster e como um trabalho usando a extensão Databricks para Visual Studio Code

Este tutorial orienta você na configuração da extensão Databricks para Visual Studio Code e, em seguida, executando Python em um cluster do Azure Databricks e como um trabalho do Azure Databricks em seu espaço de trabalho remoto. Consulte O que é a extensão Databricks para Visual Studio Code?.

Requisitos

Este tutorial requer que:

- Você instalou a extensão Databricks para Visual Studio Code. Consulte Instalar a extensão Databricks para Visual Studio Code.

- Você tem um cluster remoto do Azure Databricks para usar. Anote o nome do cluster. Para exibir os clusters disponíveis, na barra lateral do espaço de trabalho do Azure Databricks, clique em Computação. Consulte Computação.

Etapa 1: Criar um novo projeto Databricks

Nesta etapa, você cria um novo projeto Databricks e configura a conexão com seu espaço de trabalho remoto do Azure Databricks.

- Inicie o Visual Studio Code e, em seguida, clique em Arquivo > Abrir pasta e abra alguma pasta vazia em sua máquina de desenvolvimento local.

- Na barra lateral, clique no ícone do logotipo do Databricks . Isso abre a extensão Databricks.

- Na visualização Configuração, clique em Criar configuração.

- A Paleta de Comandos para configurar seu espaço de trabalho Databricks é aberta. Para Databricks Host, insira ou selecione sua URL por espaço de trabalho, por exemplo

https://adb-1234567890123456.7.azuredatabricks.net. - Selecione um perfil de autenticação para o projeto. Consulte Configurar a autorização para a extensão Databricks para Visual Studio Code.

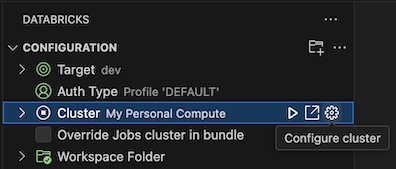

Etapa 2: Adicionar informações de cluster à extensão Databricks e iniciar o cluster

Com a visualização Configuração já aberta, clique em Selecionar um cluster ou clique no ícone de engrenagem (Configurar cluster).

Na Paleta de comandos, selecione o nome do cluster que você criou anteriormente.

Clique no ícone de reprodução (Start Cluster) se ainda não tiver sido iniciado.

Etapa 3: Criar e executar código Python

Crie um arquivo de código Python local: na barra lateral, clique no ícone da pasta (Explorer).

No menu principal, clique em File > New File e escolha um arquivo Python. Nomeie o arquivo demo.py e salve-o na raiz do projeto.

Adicione o seguinte código ao ficheiro e, em seguida, guarde-o. Este código cria e exibe o conteúdo de um DataFrame PySpark básico:

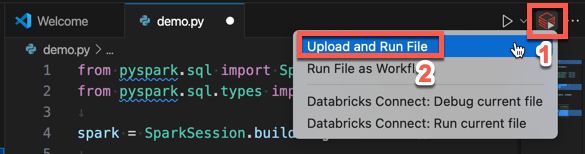

from pyspark.sql import SparkSession from pyspark.sql.types import * spark = SparkSession.builder.getOrCreate() schema = StructType([ StructField('CustomerID', IntegerType(), False), StructField('FirstName', StringType(), False), StructField('LastName', StringType(), False) ]) data = [ [ 1000, 'Mathijs', 'Oosterhout-Rijntjes' ], [ 1001, 'Joost', 'van Brunswijk' ], [ 1002, 'Stan', 'Bokenkamp' ] ] customers = spark.createDataFrame(data, schema) customers.show()# +----------+---------+-------------------+ # |CustomerID|FirstName| LastName| # +----------+---------+-------------------+ # | 1000| Mathijs|Oosterhout-Rijntjes| # | 1001| Joost| van Brunswijk| # | 1002| Stan| Bokenkamp| # +----------+---------+-------------------+Clique no ícone Executar no Databricks ao lado da lista de guias do editor e, em seguida, clique em Carregar e Executar Arquivo. A saída aparece na visualização Debug Console .

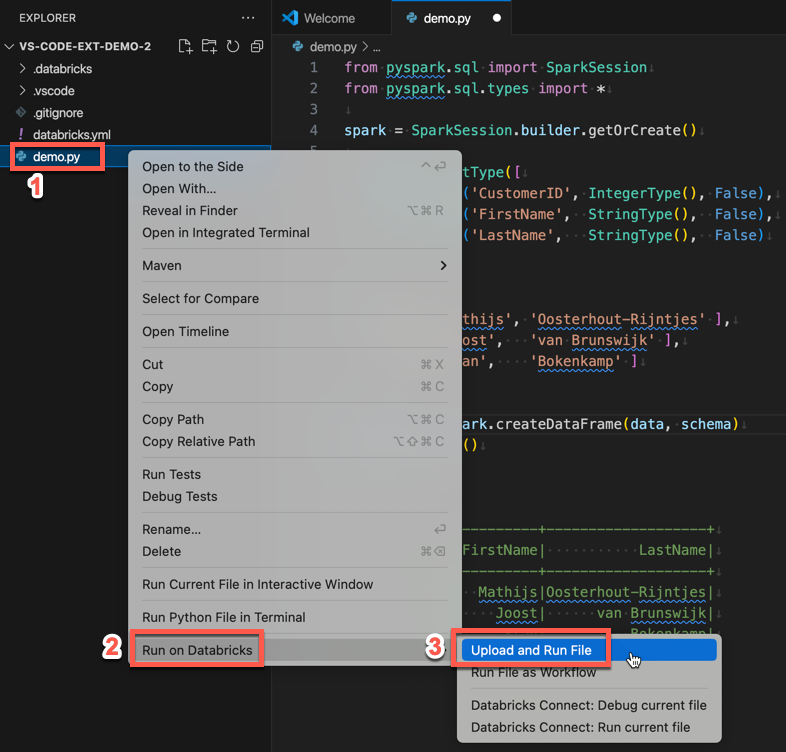

Como alternativa, no modo de exibição Explorer, clique com o botão direito do mouse no arquivo e clique em

demo.py

Etapa 4: Executar o código como um trabalho

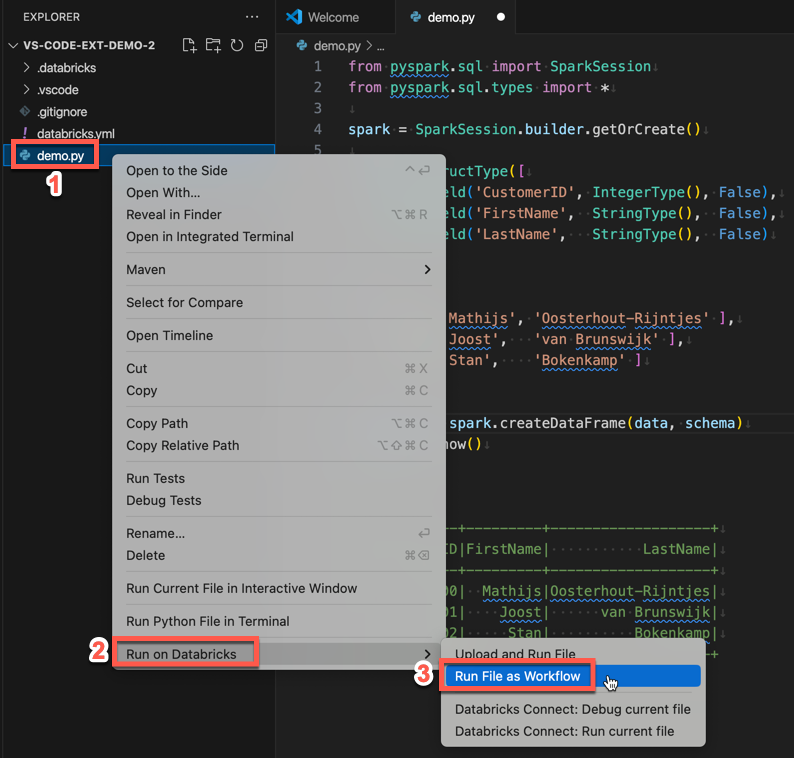

Para executar demo.py como um trabalho, clique no ícone Executar no Databricks ao lado da lista de guias do editor e, em seguida, clique em Executar Arquivo como Fluxo de Trabalho. A saída aparece em uma guia separada do editor ao lado do editor de demo.py arquivos.

![]()

Como alternativa, clique com o botão direito do demo.py mouse no arquivo no painel Explorer e selecione Executar no Databricks>Executar arquivo como fluxo de trabalho.

Próximos passos

Agora que você usou com êxito a extensão Databricks para Visual Studio Code para carregar um arquivo Python local e executá-lo remotamente, você também pode:

- Explore recursos e variáveis do Databricks Asset Bundles usando a interface do usuário de extensão. Consulte Recursos de extensão do Databricks Asset Bundles.

- Execute ou depure código Python com o Databricks Connect. Consulte Depurar código usando Databricks Connect para a extensão Databricks para Visual Studio Code.

- Execute um arquivo ou um bloco de anotações como um trabalho do Azure Databricks. Consulte Executar um arquivo em um cluster ou um arquivo ou bloco de anotações como um trabalho no Azure Databricks usando a extensão Databricks para Visual Studio Code.

- Execute testes com

pytesto . Consulte Executar testes com pytest usando a extensão Databricks para Visual Studio Code.